摘要

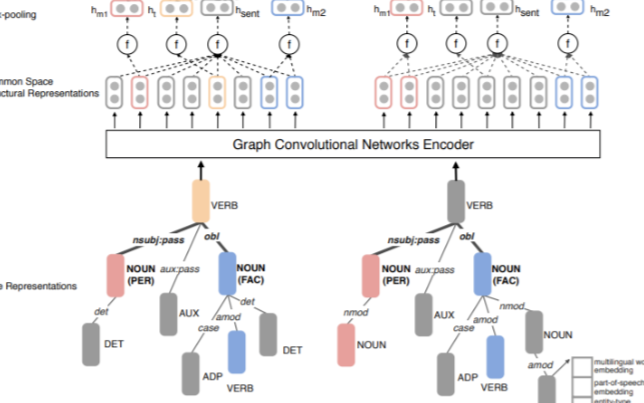

Few-shot關(guān)系提取涉及使用有限數(shù)量的注釋樣本識(shí)別文本中兩個(gè)特定實(shí)體之間的關(guān)系類型。通過應(yīng)用元學(xué)習(xí)和神經(jīng)圖技術(shù),已經(jīng)出現(xiàn)了對(duì)這個(gè)問題的各種解決方案,這些技術(shù)通常需要訓(xùn)練過程進(jìn)行調(diào)整。

最近,上下文學(xué)習(xí)策略已被證明在沒有訓(xùn)練的情況下顯示出顯著的結(jié)果。很少有研究利用上下文學(xué)習(xí)進(jìn)行zero-shot信息提取。不幸的是,推理的證據(jù)在思維鏈提示的構(gòu)建過程中沒有被考慮或隱式建模。

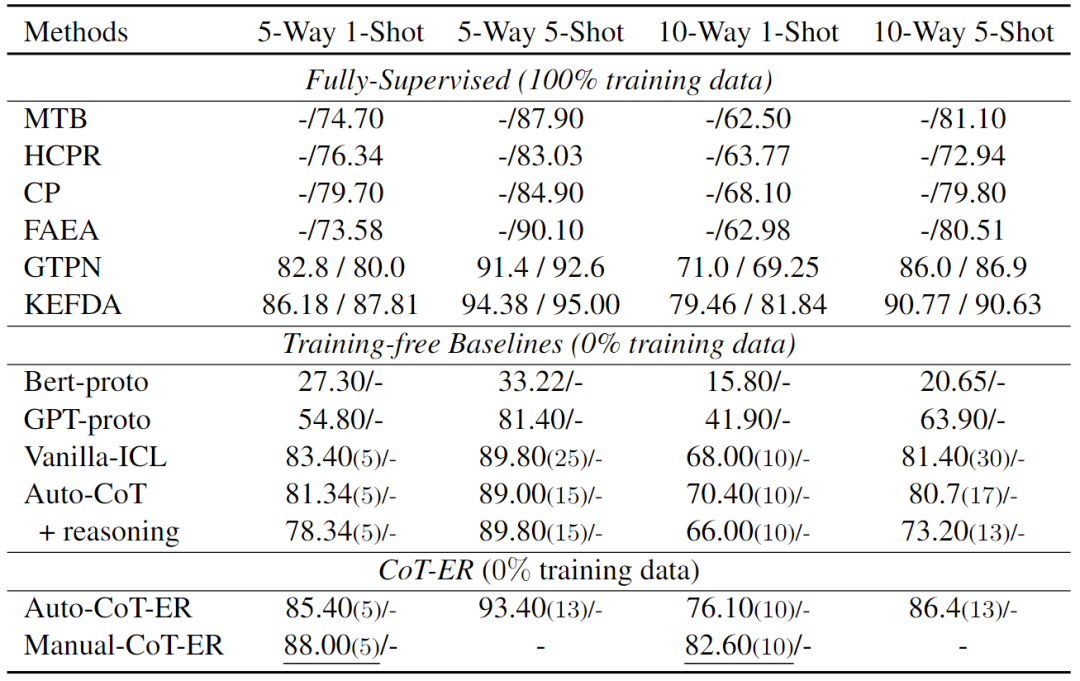

本文提出了一種使用大型語言模型進(jìn)行Few-shot關(guān)系提取的新方法,稱為CoT-ER,具有顯式證據(jù)推理的思維鏈。特別是,CoT-ER首先誘導(dǎo)大型語言模型使用特定任務(wù)和概念級(jí)知識(shí)生成證據(jù)。然后將此證據(jù)明確納入思維鏈提示以進(jìn)行關(guān)系提取。實(shí)驗(yàn)結(jié)果表明,在FewRel 1.0和FewRel 2.0數(shù)據(jù)集上,與完全監(jiān)督(具有100%訓(xùn)練數(shù)據(jù))的最先進(jìn)方法相比,本文的CoT-ER方法(具有0%訓(xùn)練數(shù)據(jù))實(shí)現(xiàn)了具有競爭力的性能。

簡介

關(guān)系提取(Relation Extraction, RE)旨在基于上下文語義信息識(shí)別兩個(gè)給定實(shí)體之間的關(guān)系。

當(dāng)標(biāo)記的數(shù)據(jù)不足時(shí),RE模型的性能往往會(huì)顯著下降。few-shot關(guān)系提取任務(wù)需要使用有限數(shù)量的注釋訓(xùn)練數(shù)據(jù)。最近,許多研究人員通過使用元學(xué)習(xí)和神經(jīng)圖技術(shù)來解決這個(gè)問題,通過在大型數(shù)據(jù)集上對(duì)模型進(jìn)行元訓(xùn)練或結(jié)合外部知識(shí),取得了令人滿意的結(jié)果。

近年來,預(yù)訓(xùn)練的LLMs,如GPT系列模型,已經(jīng)顯示出顯著的上下文學(xué)習(xí)(LLM可以有效地執(zhí)行各種任務(wù),而無需參數(shù)優(yōu)化,這一概念被稱為上下文學(xué)習(xí))能力,在許多NLP任務(wù)中取得了出色的結(jié)果。在上下文學(xué)習(xí)的范式中,LLM在許多NLP任務(wù)中表現(xiàn)出與標(biāo)準(zhǔn)的完全監(jiān)督方法相比的競爭性能,即使只提供了幾個(gè)示例作為提示中的few-shot示例。

思維鏈(Chain-of-Thought, CoT)提示方法在數(shù)學(xué)問題和常識(shí)推理中從LLM引出令人印象深刻的推理能力。在RE任務(wù)中,存在指導(dǎo)LLM確定關(guān)系標(biāo)簽的推理過程。然而,缺乏填補(bǔ)這一空白的研究。盡管GPT-RE引入了一種標(biāo)簽誘導(dǎo)推理方法,通過提示LLM僅基于給定的標(biāo)簽生成合適的推理過程。與特定的few-shot示例檢索方法相比,自動(dòng)生成推理過程的性能改進(jìn)微乎其微。

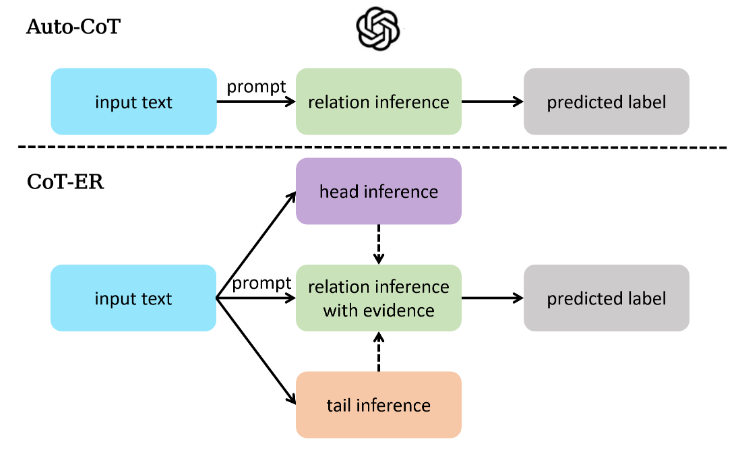

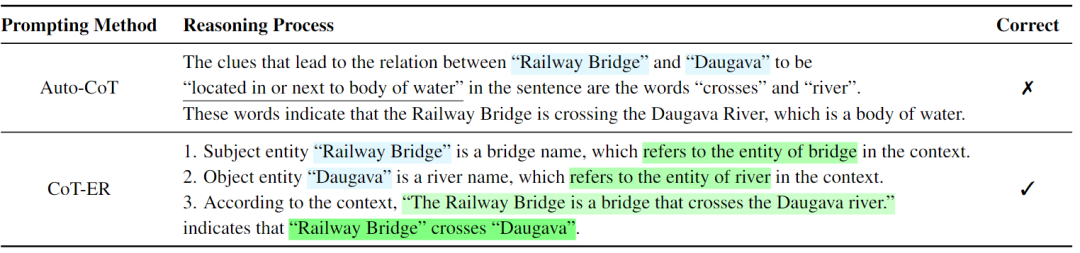

本文為FSRE(Few-shot Relation Extraction, FSRE)任務(wù)提出了一種新的思想鏈提示方法:具有顯式證據(jù)推理的思想鏈,與FewRel 1.0和FewRel 2.0上的最先進(jìn)結(jié)果相比,獲得了具有競爭力的結(jié)果。本文的方法采用三步推理方法來解決上述問題。在第一步和第二步中,CoT-ER要求LLM輸出與頭部和尾部實(shí)體相對(duì)應(yīng)的概念級(jí)實(shí)體,這是RE特定推理的基礎(chǔ)。在第三步中,CoT-ER提示LLM提取相關(guān)的上下文跨度作為明確建立這兩個(gè)實(shí)體之間特定關(guān)系的證據(jù)。通過將頭部實(shí)體、尾部實(shí)體和關(guān)系標(biāo)簽組合成連貫的句子,LLM可以更語義地確定兩個(gè)給定實(shí)體之間的關(guān)系標(biāo)簽,解決了提示方法中關(guān)系標(biāo)簽的語義模糊問題。下圖展示了Auto-CoT和CoT-ER之間的差異。

相關(guān)工作

Few-shot Relation Extraction

few-shot關(guān)系提取旨在基于有限數(shù)量的注釋數(shù)據(jù)預(yù)測給定實(shí)例中指示的頭部和尾部實(shí)體之間的語義關(guān)系。FewRel是Han等人引入的一個(gè)大規(guī)模數(shù)據(jù)集,是第一個(gè)在關(guān)系提取中探索few-shot學(xué)習(xí)的數(shù)據(jù)集。許多方法在缺乏訓(xùn)練數(shù)據(jù)的情況下,結(jié)合外部知識(shí)來提高性能。FSRE的另一條研究路線僅依賴于輸入文本和提供的關(guān)系描述信息,而不包含外部知識(shí)。以前的大多數(shù)方法通常采用復(fù)雜的神經(jīng)網(wǎng)絡(luò)設(shè)計(jì)或引入外部知識(shí),這在現(xiàn)實(shí)場景中可能是勞動(dòng)密集型的。

In-context Learning

GPT-3在上下文學(xué)習(xí)(In-context Learning, ICL)中已成為NLP中的一種新范式,與微調(diào)模型相比,它在各種任務(wù)中表現(xiàn)出了競爭力。通過將相關(guān)文本信息納入提示中,將先驗(yàn)知識(shí)引入LLM要容易得多。此外,ICL是一種無需訓(xùn)練的方法,直接提示LLM,這意味著它是一種現(xiàn)成的方法,只需在提示中進(jìn)行一些演示即可輕松應(yīng)用于各種任務(wù)。

最近,大多數(shù)研究人員專注于ICL的示例設(shè)計(jì),以提高NLP任務(wù)的性能,并逐漸發(fā)展為兩類。演示設(shè)計(jì)的第一類試圖通過從數(shù)據(jù)集中選擇實(shí)例并對(duì)所選演示實(shí)例進(jìn)行排序來尋求提示中的少量示例的最佳安排。另一類示例設(shè)計(jì)旨在發(fā)現(xiàn)一種有效的提示方法,以釋放LLM的潛力。此外,有研究人員通過在給出答案之前手動(dòng)添加中間推理步驟,揭示了LLM的推理能力,這被稱為思維鏈。

盡管CoT提示方法在許多NLP任務(wù)中取得了很好的結(jié)果,但它仍然缺乏對(duì)RE的相關(guān)探索。因此,本文提出了一種新的CoT提示法CoT-ER來填補(bǔ)這一空白。

CoT-ER

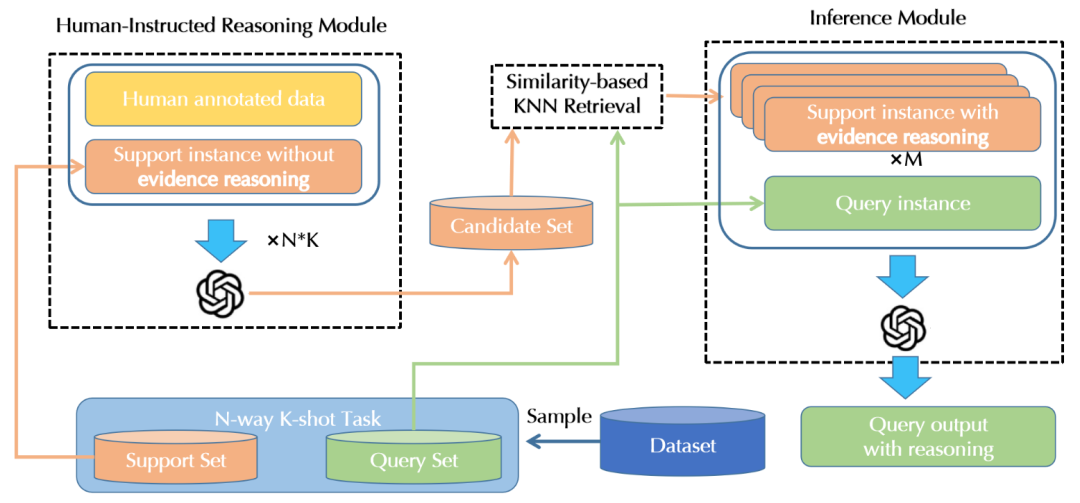

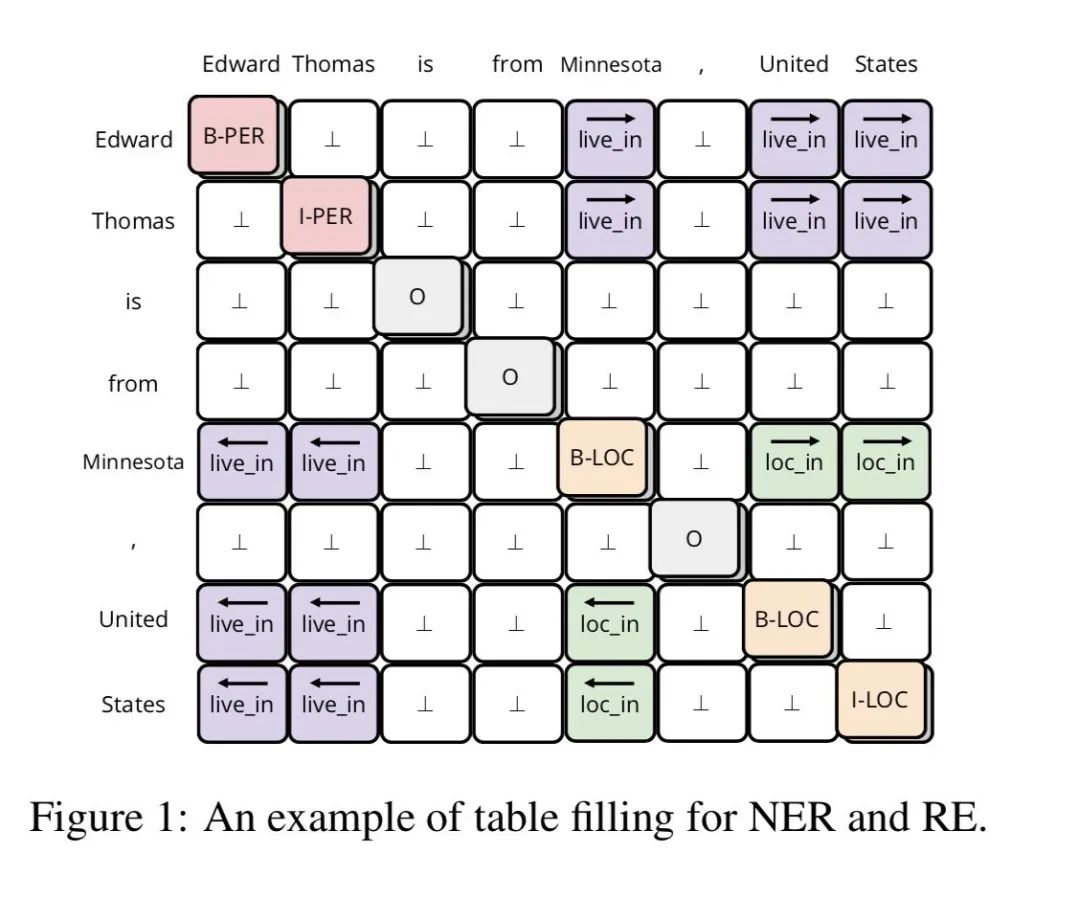

本文提出的CoT-ER的概述如下圖所示,它由3個(gè)組件組成:

- Human-Instructed Reasoning Module:旨在通過用人工注釋數(shù)據(jù)提示LLM,將推理過程與支持集中的每個(gè)實(shí)例相關(guān)聯(lián)。

- Similarity Based KNN Retrieval Module:基于相似性的KNN檢索模塊將根據(jù)與查詢實(shí)例的相似性從支持集中選擇具有推理過程的實(shí)例,這些實(shí)例在最終提示中被視為few-shot示例。

- Inference Module:推理模塊通過最終提示指示LLM來預(yù)測查詢實(shí)例的關(guān)系標(biāo)簽,最終提示將任務(wù)指令、few-shot示例和關(guān)于實(shí)例的問題連接起來。

Human-Instructed Reasoning Module

由于LLM具有上下文學(xué)習(xí)的能力,本文提出了一種人工指導(dǎo)的方法來指導(dǎo)LLM使用最少的注釋數(shù)據(jù)執(zhí)行準(zhǔn)確的推理。

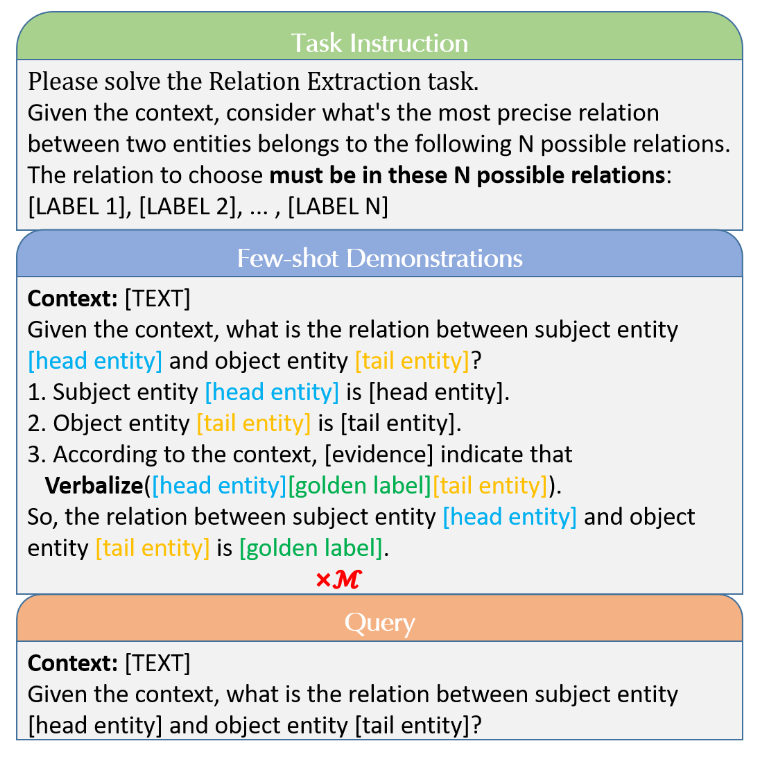

CoT-ER設(shè)計(jì):為了充分利用LLM中存儲(chǔ)的知識(shí)并促進(jìn)逐步推理,引入了一種新的具有概念級(jí)知識(shí)和明確證據(jù)的三步推理框架。在步驟1中,LLM推斷與頭部實(shí)體相關(guān)的概念級(jí)知識(shí),而步驟2對(duì)尾部實(shí)體進(jìn)行同樣的操作。通過這些步驟,LLM可以很容易地排除概念實(shí)體不正確的選項(xiàng)。步驟3:為了找出在給定的上下文中哪一個(gè)關(guān)系標(biāo)簽最適合這對(duì)實(shí)體,明確強(qiáng)調(diào)相關(guān)的文本跨度作為證據(jù),然后構(gòu)建一個(gè)連貫的表達(dá)式,將兩個(gè)實(shí)體和關(guān)系標(biāo)簽結(jié)合在一起。為了進(jìn)一步說明三步推理過程,下圖中的幾個(gè)shot示例演示了該推理過程的模板。

CoT-ER生成:為數(shù)據(jù)集中的每個(gè)關(guān)系類注釋了一個(gè)CoT-ER推理示例作為種子示例。然后,設(shè)計(jì)了一個(gè)適當(dāng)?shù)奶崾荆褂米⑨尩氖纠鳛閒ew-shot示例演示,以指導(dǎo)LLM為每個(gè)支持實(shí)例生成類似的推理步驟。每個(gè)具有CoT-ER推理步驟的支持實(shí)例都將附加到候選集合中。上圖顯示了為人工指導(dǎo)推理模塊設(shè)計(jì)的類似提示。

Retrieval Module

有研究表明,基于相似性選擇few-shot示例會(huì)大大改善上下文學(xué)習(xí)。由于LLM的輸入tokens有限,在給定N路K-Shot任務(wù)的情況下,單個(gè)提示可能無法容納所有支持實(shí)例。在本文中,遵循基于相似性的方法來選擇few-shot示例。為了獲得特定關(guān)系的相似性表示,首先通過合并實(shí)體級(jí)信息,將輸入文本重構(gòu)為“上下文:[文本]給定上下文,“[頭部實(shí)體]”和“[尾部實(shí)體]”之間的關(guān)系是什么?”。然后,利用GPT系列模型“text-embedding-ad-002”作為編碼器來獲得語義嵌入。隨后,計(jì)算候選集合中的每個(gè)實(shí)例與查詢實(shí)例之間的歐幾里得距離。最后,基于候選集合中的M個(gè)實(shí)例到查詢實(shí)例的較低歐幾里得距離,選擇它們作為few-shot示例。

Inference Module

為了創(chuàng)建最終提示,只需將一條任務(wù)指令、few-shot示例和一個(gè)針對(duì)查詢實(shí)例定制的問題連接起來,使用具有CoT-ER推理的支持實(shí)例作為few-shot示例。值得注意的是,LLM在一般情況下有很強(qiáng)的錯(cuò)誤輸出NULL的傾向。本文中強(qiáng)制LLM選擇所提供的關(guān)系標(biāo)簽之一,因?yàn)闆]有考慮FewRel數(shù)據(jù)集中的“無上述”場景示例。

實(shí)驗(yàn)

Datasets

有兩個(gè)標(biāo)準(zhǔn)的few-shot關(guān)系提取數(shù)據(jù)集:FewRel 1.0和FewRel 2.0。

- FewRel 1.0由維基百科構(gòu)建,維基百科由70000個(gè)句子組成,注釋有100個(gè)關(guān)系標(biāo)簽,這100個(gè)關(guān)系標(biāo)記被分為64/16/20個(gè)部分,用于訓(xùn)練/驗(yàn)證/測試集。

- FewRel2.0通過引入醫(yī)學(xué)領(lǐng)域的額外驗(yàn)證和測試集擴(kuò)展了FewRel 1.0,其中包括分別具有1000個(gè)實(shí)例的10個(gè)關(guān)系標(biāo)簽和具有1500個(gè)實(shí)例的15個(gè)關(guān)系標(biāo)簽。

實(shí)驗(yàn)細(xì)節(jié)

在現(xiàn)實(shí)場景中,直接使用固定的、手動(dòng)注釋的示例執(zhí)行RE任務(wù)是合理的,作為每個(gè)關(guān)系標(biāo)簽的少量鏡頭演示。為此,通過從預(yù)先確定的人工注釋CoT-ER數(shù)據(jù)集中選擇few-shot示例來評(píng)估性能,該數(shù)據(jù)集表示為手動(dòng)CoT-ER。在此設(shè)置中,few-shot示例獨(dú)立于支持集,這意味著LLM將使用較少的注釋數(shù)據(jù)執(zhí)行RE任務(wù)。相反,Auto-CoT-ER利用自動(dòng)生成的CoT-ER推理過程作為人工指導(dǎo)推理模塊中描述的支持集的few-shot示例。

對(duì)比模型

本文考慮FSRE任務(wù)的兩類方法。

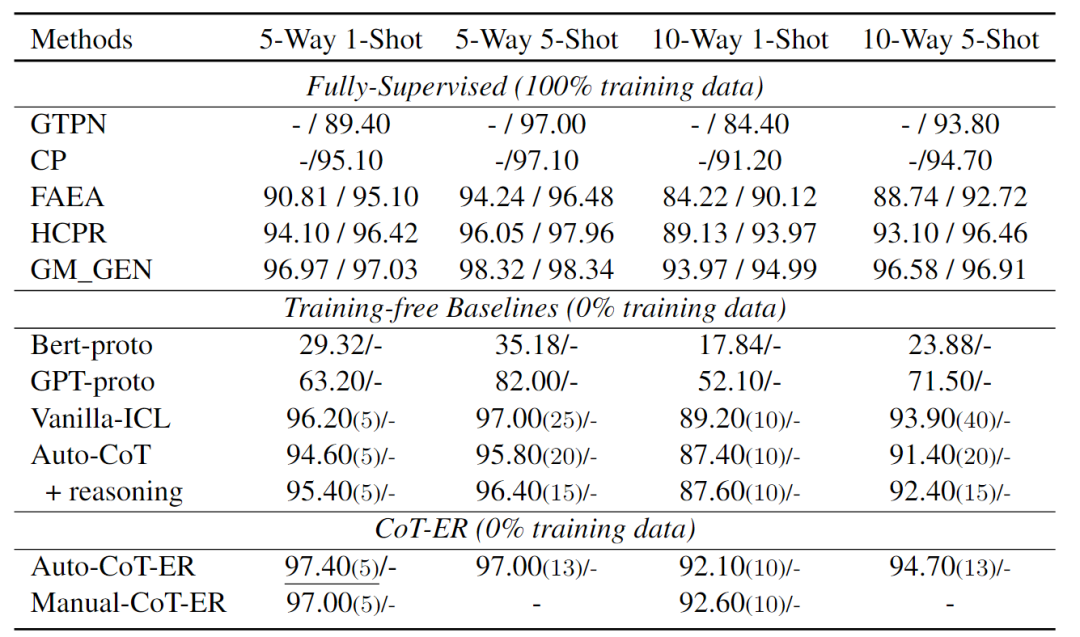

100% 訓(xùn)練數(shù)據(jù)的方法:MTB、CP、HCPR、FAEA、GTPN、GM_GEN和KEFDA。通常,這些方法在FewRel 1.0訓(xùn)練集上訓(xùn)練模型,并在FewRel 1.0、2.0驗(yàn)證和測試集上評(píng)估其性能。

0% 訓(xùn)練數(shù)據(jù)的方法:應(yīng)用Vanilla-ICL和Auto-CoT作為基線提示格式化方法。這些方法利用一些示例作為演示,并提示LLM執(zhí)行NLP任務(wù)。Vanilla-ICL設(shè)計(jì)了一個(gè)直接結(jié)合文本和關(guān)系標(biāo)簽的模板,例如“上下文:[文本],給定上下文,[頭部實(shí)體]和[尾部實(shí)體]之間的關(guān)系就是[關(guān)系標(biāo)簽]”。Auto-CoT通過自動(dòng)生成的推理步驟擴(kuò)展了Vanilla-ICL。

在整個(gè)實(shí)驗(yàn)中,注意到是否要求LLM在最后的回答階段進(jìn)行推理可能會(huì)導(dǎo)致不一致的結(jié)果,如下表所示。此外,利用預(yù)先訓(xùn)練的BERT基本模型6和GPT系列模型text-embedding-ada-002作為編碼器,直接獲得輸入文本的表示。對(duì)于每個(gè)N路K-shot任務(wù),我們通過對(duì)屬于該類的K instance進(jìn)行平均來獲得每個(gè)類的原型。然后,將查詢實(shí)例的預(yù)測標(biāo)簽分配給其原型與查詢實(shí)例具有最接近歐幾里得距離的類。將這兩種方法稱為Bert-proto和GPT-proto。

結(jié)果與分析

結(jié)果

- 與Vanilla-ICL相比,在few-shot場景中,Auto-CoT沒有表現(xiàn)出顯著的改進(jìn)。這可能歸因于推理過程的低質(zhì)量,以及由于最大token限制,few-shot演示中的實(shí)例數(shù)量減少。此外,當(dāng)涉及到在最終答案中生成推理過程時(shí),具有推理的Auto-CoT優(yōu)于在FewRel 1.0上直接生成關(guān)系標(biāo)簽的版本。然而,在FewRel 2.0上得出了相反的結(jié)論。原因可能為:FewRel 1.0從維基百科中提取實(shí)例,通常需要常識(shí)來進(jìn)行推理,而FewRel 2.0需要醫(yī)學(xué)相關(guān)專業(yè)知識(shí),與常識(shí)相比,在預(yù)訓(xùn)練語料庫中所占比例較小。因此,LLM在執(zhí)行醫(yī)學(xué)領(lǐng)域的推理任務(wù)時(shí)遇到困難。

- 手動(dòng)CoT-ER和Auto-CoT-ER都優(yōu)于無訓(xùn)練基線,在few-shot演示中使用的實(shí)例更少。表明有必要設(shè)計(jì)一種針對(duì)RE任務(wù)的特定CoT提示方法,以便在few-shot場景中獲得更好的性能。

- CoT-ER提示方法在FewRel 1.0和FewRel 2.0上都比最先進(jìn)的完全監(jiān)督方法具有競爭力,并以最少的人工超過了大多數(shù)完全監(jiān)督方法。這表明,當(dāng)提供高質(zhì)量的關(guān)系信息和精心設(shè)計(jì)的推理過程時(shí),GPT系列LLM有可能擊敗以前的完全監(jiān)督方法。

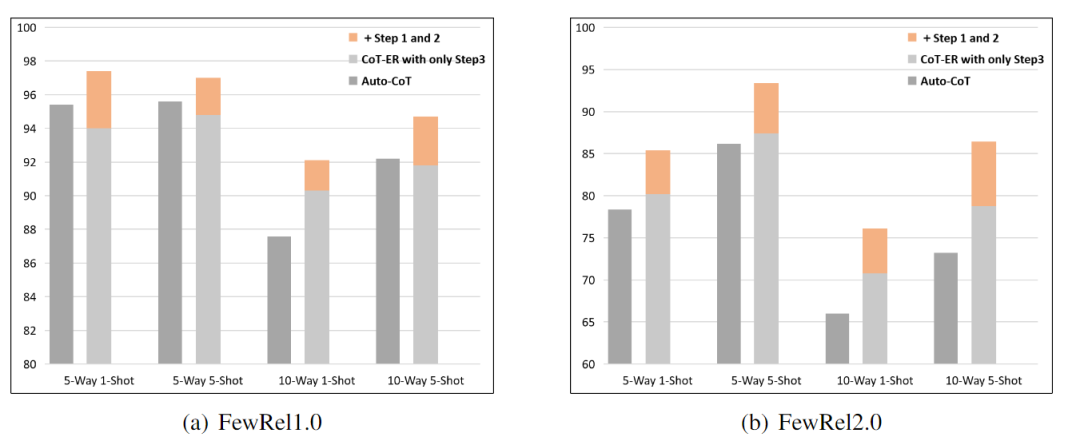

消融CoT-ER

合并實(shí)體信息是否對(duì)CoT-ER有顯著好處?本文進(jìn)行了消融實(shí)驗(yàn),以證明三步推理過程的必要性。在這個(gè)實(shí)驗(yàn)中,去掉了第一步和第二步,并將性能與Auto-CoT reasoning進(jìn)行了比較。出于公平考慮,使用Auto-CoT-ER實(shí)現(xiàn)了這個(gè)實(shí)驗(yàn),它還采用了LLM自動(dòng)生成的推理過程。由于最大輸入和輸出token的限制,將消融實(shí)驗(yàn)的few-shot演示中的實(shí)例數(shù)量設(shè)置為13。結(jié)果如下圖所示。

結(jié)果表明:

- 除第一步和第二步后,Auto-CoT-ER的性能顯著下降,在FewRel 1.0和FewRel 2.0上的精度分別降低了3.4、2.2、1.8、2.9和5.2、6、5.3、7.6。這意味著實(shí)體類型的更高層次抽象,特別是概念級(jí)實(shí)體,有利于LLM在few-shot場景中執(zhí)行RE任務(wù)。

- CoT-ER的第三步是將支持實(shí)例與Auto-CoT相比更簡單的推理過程配對(duì),但它在某些具有挑戰(zhàn)性的場景中實(shí)現(xiàn)了卓越的性能。這一發(fā)現(xiàn)表明,關(guān)系標(biāo)簽提供的語義信息比低質(zhì)量的推理信息更有利于LLM。

CoT-ER穩(wěn)定性實(shí)驗(yàn)

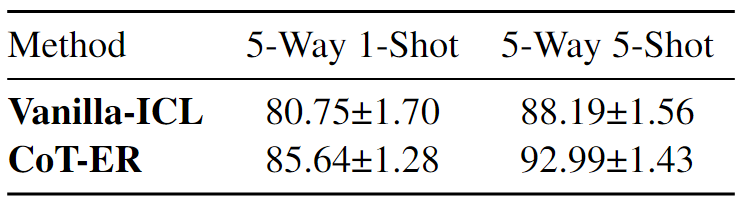

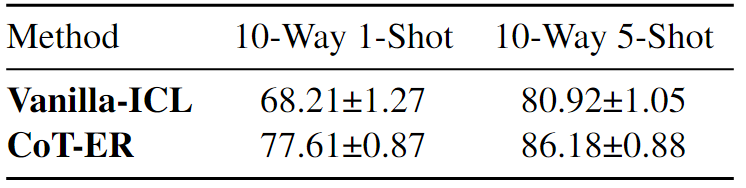

本文對(duì)提出的CoT-ER進(jìn)行了兩項(xiàng)穩(wěn)定性實(shí)驗(yàn)。

- Different Random Seeds for Task Sampling:由于“text-davinci-003”的成本很高,本文對(duì)數(shù)量相對(duì)較少的查詢進(jìn)行了采樣測試,特別是每個(gè)N路K-Shot任務(wù)的查詢數(shù)量為100×N。為此,使用8個(gè)隨機(jī)種子對(duì)CoT-ER和Vanilla-ICL進(jìn)行了評(píng)估,用于N路K-Shot任務(wù)采樣。下表中顯示了FewRel 2.0的平均值±標(biāo)準(zhǔn)偏差的實(shí)驗(yàn)結(jié)果。值得注意的是,CoT-ER在所有N路K-shot設(shè)置中始終以較低的標(biāo)準(zhǔn)差優(yōu)于Vanilla-ICL。

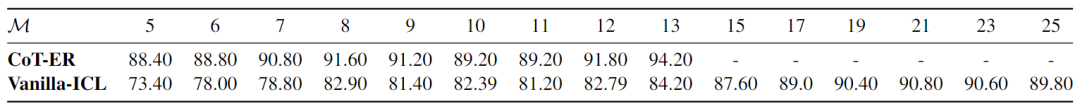

- Different Number of Few-shot Instances:為了研究所選演示數(shù)量如何有助于CoT-ER的性能,在5-Way,5-Shot 設(shè)置下進(jìn)行了實(shí)驗(yàn)。單個(gè)提示在最壞的情況下可以保持13個(gè)CoT-ER推理演示,而所有支持實(shí)例(25)都可以附加到Vanilla-ICL中的提示。結(jié)果如下表所示。

觀察到CoT-ER和Vanilla-ICL都可以受益于更多的few-shot示例,然而,隨著示例數(shù)量的增加,Vanilla-ICL的性能迅速下降。CoT-ER可以有效地利用來自提供實(shí)例的信息,即使實(shí)例數(shù)量減少,也能保持強(qiáng)大的性能。這表明當(dāng)few-shot實(shí)例的數(shù)量發(fā)生變化時(shí),CoT-ER表現(xiàn)出比Vanilla-ICL更大的穩(wěn)定性。

下表展示了CoT-ER和Auto-CoT方法的案例分析。

結(jié)論

本文探索了LLM上下文內(nèi)學(xué)習(xí)在few-shot關(guān)系提取方面的潛力。為了提高低質(zhì)量自動(dòng)生成推理過程所帶來的總體性能,引入了CoT-ER,這是一種專門用于few-shot關(guān)系提取的提示方法。核心思想是促使LLM使用存儲(chǔ)在其預(yù)訓(xùn)練階段的特定任務(wù)和概念級(jí)別的知識(shí)來生成證據(jù)。LLM將在RE任務(wù)中使用這些證據(jù),并促進(jìn)推理過程。此外,設(shè)計(jì)了一種標(biāo)簽描述技術(shù),通過將實(shí)體和關(guān)系標(biāo)簽集成到一個(gè)連貫的表達(dá)式中。該技術(shù)解決了關(guān)系標(biāo)簽的語義歧義,這是在上下文學(xué)習(xí)中使用關(guān)系提取時(shí)遇到的常見挑戰(zhàn)。FewRel 1.0和FewRel 2.0的實(shí)驗(yàn)結(jié)果優(yōu)于所有無訓(xùn)練基線,證明了本文提出的方法的有效性。此外,實(shí)現(xiàn)與最先進(jìn)的完全監(jiān)督方法相當(dāng)?shù)慕Y(jié)果表明,上下文學(xué)習(xí)范式有望成為few-shot關(guān)系提取任務(wù)的新解決方案。

盡管CoT-ER在FewRel 1.0和FewRel 2.0上取得了不錯(cuò)的結(jié)果,但仍有未來改進(jìn)的潛力。由于最大長度的限制,本文提出的方法在處理較大的數(shù)據(jù)集時(shí)并沒有充分利用所有實(shí)例。盡管采用了基于相似性的KNN檢索來為few-shot演示選擇優(yōu)越的實(shí)例,結(jié)果發(fā)現(xiàn),與其他在有大量候選集可用時(shí)表現(xiàn)良好的方法相比,它在few-shot設(shè)置中并不有效。由于通過GPT-3的API使用合理所需ICL的成本很高,本文尚未在具有更長最大輸入token和更大規(guī)模的高級(jí)LLM上評(píng)估CoT-ER。有限的預(yù)算也限制了種子示例構(gòu)建的優(yōu)化。可以通過更具信息性和適當(dāng)?shù)脑O(shè)計(jì)來提高性能。

-

語言模型

+關(guān)注

關(guān)注

0文章

561瀏覽量

10703 -

nlp

+關(guān)注

關(guān)注

1文章

490瀏覽量

22524 -

LLM

+關(guān)注

關(guān)注

1文章

321瀏覽量

710

原文標(biāo)題:EMNLP2023 | 基于顯式證據(jù)推理的few-shot關(guān)系抽取CoT

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

基于將 CLIP 用于下游few-shot圖像分類的方案

基于改進(jìn)模糊熵和證據(jù)推理的多屬性決策方法

深度學(xué)習(xí):遠(yuǎn)程監(jiān)督在關(guān)系抽取中的應(yīng)用

NLP:關(guān)系抽取到底在乎什么

細(xì)解讀關(guān)系抽取SOTA論文

基于機(jī)器學(xué)習(xí)的中文隱式實(shí)體關(guān)系抽取方法

樣本量極少可以訓(xùn)練機(jī)器學(xué)習(xí)模型嗎?

Zero-shot-CoT是multi-task的方法

實(shí)體關(guān)系抽取模型CasRel

介紹兩個(gè)few-shot NER中的challenge

Few-shot NER的三階段

基于GLM-6B對(duì)話模型的實(shí)體屬性抽取項(xiàng)目實(shí)現(xiàn)解析

邁向多模態(tài)AGI之開放世界目標(biāo)檢測

基于多任務(wù)預(yù)訓(xùn)練模塊化提示

基于顯式證據(jù)推理的few-shot關(guān)系抽取CoT

基于顯式證據(jù)推理的few-shot關(guān)系抽取CoT

評(píng)論