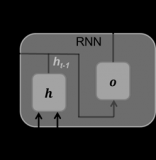

在處理長序列數據時,RNN(循環神經網絡)模型可能會面臨梯度消失的問題,這是由于反向傳播過程中,由于連續的乘法操作,梯度會指數級地衰減,導致較早的時間步的輸入對較后時間步的梯度幾乎沒有影響,難以進行有效的訓練。為了解決這個問題,可以采取以下幾種方法:

梯度裁剪(Gradient Clipping)

梯度裁剪是限制梯度大小的技術,通過設置梯度的閾值,將梯度限制在這個范圍內,以防止梯度爆炸。同時,它也有助于在一定程度上緩解梯度消失問題,因為它確保了梯度不會變得過小而無法對模型參數進行有效更新。常用的剪裁方法包括L2范數和逐元素裁剪。

參數初始化

合適的參數初始化方法也可以緩解梯度消失的問題。使用適當的權重初始化方法,例如Xavier或He初始化,可以通過確保更穩定的初始梯度來減少梯度消失的可能性。另外,避免權重值過大或過小也是關鍵,因為極端的權重值可能導致梯度在反向傳播過程中迅速消失或爆炸。

使用門控循環單元(GRU)或長短期記憶(LSTM)

GRU和LSTM是RNN的兩種改進模型,它們通過引入門控機制來解決梯度消失的問題。這些門控機制能夠控制信息的流動,從而減小梯度消失的影響。

- LSTM :LSTM通過引入三個特殊的門(輸入門、遺忘門和輸出門)和一個細胞狀態來維護長期信息。遺忘門決定從細胞狀態中丟棄哪些不再需要的信息;輸入門控制新輸入信息的多少能夠加入到細胞狀態中;輸出門決定什么信息將從細胞狀態傳遞到輸出。細胞狀態是LSTM網絡的核心,使得信息能跨越多個時間步長時間保留。

- GRU :GRU是LSTM的一個變體,結構更為簡潔。它將LSTM中的遺忘門和輸入門合并為一個單一的更新門,并合并了細胞狀態和隱藏狀態。更新門決定保留多少過去的信息并添加多少新信息;重置門決定在創建當前候選隱藏狀態時忽略多少過去的信息。

雙向RNN

在傳統的RNN模型基礎上,引入雙向RNN可以從兩個方向上讀取輸入序列。在計算梯度時,雙向RNN可以同時考慮前后的信息,這有助于提高模型對長序列的建模能力,從而在一定程度上緩解梯度消失問題。

Skip Connections

類似于殘差網絡的skip connection方法也可以應用于RNN模型中。通過將上一層的輸入直接連接到下一層,可以減小梯度消失的影響,提高模型的訓練效果。

綜上所述,解決RNN中的梯度消失問題需要從多個方面入手,包括梯度裁剪、參數初始化、使用門控循環單元或長短期記憶、引入雙向RNN以及應用skip connections等方法。這些方法可以單獨使用或結合使用來解決RNN中的梯度消失問題,具體選擇方法時可以根據實際情況進行調整。

-

數據

+關注

關注

8文章

7247瀏覽量

91292 -

參數

+關注

關注

11文章

1867瀏覽量

32901 -

循環神經網絡

+關注

關注

0文章

38瀏覽量

3094 -

rnn

+關注

關注

0文章

89瀏覽量

7069

發布評論請先 登錄

訓練RNN時如何避免梯度消失

訓練RNN時如何避免梯度消失

評論