【導讀】全球 AI 競賽正酣,DeepSeek 的出現,宛如一石激水,打破了原有的平靜。作為資深技術專家和行業觀察者,CSDN 高級副總裁、Boolan 首席技術專家李建忠將在本文撥開“DeepSeek 熱”的表象,深入探究其背后的技術創新邏輯和生態戰略布局,揭示 DeepSeek 如何在全球 AI 競爭中脫穎而出,并預見其對未來 AI 格局可能產生的深遠影響。

春節期間,DeepSeek 在全球科技圈引發強烈震動。“DeepSeek 時刻” 、“國運級創新”等熱議現象在歐美科技界和國內不斷涌現,西方主流媒體如《自然》、《紐約時報》、《經濟學人》也紛紛報道,全球科學、技術、金融、政府、軍事等領域的專家政要亦高度關注。盡管對于 DeepSeek 的評價各有側重,但其出圈和影響力已不容忽視。

DeepSeek 到底做了什么?所謂的“DeepSeek 時刻”或者“國運級創新”到底意味著什么?

個人認為 DeepSeek 巨大的影響力不僅僅在于它在 AI 領域實現的幾個方面的關鍵技術創新,更重要的是由其引發的對全球 AI 生態版圖的升級和重塑。本文將從以下兩個維度,談談我對 DeepSeek 的創新研究和思考:

(一)DeepSeek 的關鍵技術創新;

(二)DeepSeek 對于大模型的生態意義。

DeepSeek 的關鍵技術創新

1.開源強化學習引領推理計算范式轉換

去年 9 月份 OpenAI 發布的 o1 模型展現了強化學習在推理計算方面的卓越能力,但是 OpenAI 既沒有開源,技術報告也語焉不詳,全球 AI 界雖然對大模型將迎來從預訓練到推理計算的范式轉換抱有很高期待,但一直沒有成功的復現。直到 DeepSeek R1 的出現,無論是在以推理為主的各項國際公認的評測指標上、還是實際使用感受上,都超越 Claude Sonnet 3.5 、OpenAI GPT-4o 等一眾前沿閉源模型。

DeepSeek 的推理計算路線也讓很多業內專家嘆為觀止,其使用純粹 RL(強化學習),無需 SFT(監督微調),不依賴冷啟動數據,成功地實現了靠純 RL(強化學習)來激勵大模型的推理能力。DeepSeek 在 R1 的訓練中也觀察到了模型推理時“喃喃自語反思錯誤的 Aha Moment”(所謂大模型的“頓悟時刻”)。DeepSeek 的研究人員在其論文中談到,這不僅是大模型的“Aha Moment”,也是研究團隊的“Aha Moment”。

為什么說使用 RL 強化學習來做推理計算,為大模型帶來了新的范式轉換?人類智能的學習行為本質上分兩種:模仿學習和探索學習。

預訓練就是大模型的模仿學習,在 OpenAI o1 和 DeepSeek R1 兩個模型之前,大模型主要進行的是“預訓練”為主的模仿學習。喂給大模型什么樣的數據,大模型才能學會什么。沒教的一概不會,非要回答就會幻覺說胡話。

強化學習就是大模型的探索學習,這是在 OpenAI o1 和 DeepSeek R1 推理時主要的學習方式。在強化學習支持的推理計算下,大模型會不斷探索優化、遇到錯誤會改正自己。不難理解,如果沒有探索學習,僅僅基于預訓練的模仿學習,大模型遇到復雜問題,很難超過人類專家。而有了探索學習,大模型才有可能發展出遠超人類智能的水平,比如在 AlphaGo 當時大敗圍棋冠軍李世石時著名的第 37 手(move 37),背后就是強化學習的功勞。

強化學習在 AI 領域并不新鮮,但將強化學習泛化地應用在大模型領域,成為大模型推理計算的核心,OpenAI o1 和 DeepSeek R1 屬于開先河者。大模型領域也因此迎來了從預訓練到推理計算的范式轉換,而且因為開源的引領,相信 DeepSeek 有機會成為這一范式轉換的領導者。

順便提一句,DeepSeek 在工程領域也有很多可圈可點之處,比如從純強化學習模型 R0,到使用 SFT、基于 V3 基座模型調教出來既有文采又懂推理、文理雙全的 R1;再比如使用 R1 作為教師模型來蒸餾多個小模型,使得小模型也具備很高的推理能力。這些都會加速大模型向推理計算的范式轉換。

2.MLA 和 MoE 等引領大模型架構創新

自 GPT 采用 Transformer 架構取得成功以來,經典 Transformer 架構一直是很多大模型的標配。但這不意味著 Transformer 是完美無缺的。DeepSeek 在 Transformer 架構的基礎上也做了很多創新,主要包括兩個方面:(1)多頭潛在注意力即 MLA ;(2)混合專家模型即MoE。

MLA 用于高效推理,源自 DeepSeek V2 的原創,其顯著降低了推理顯存的消耗。MLA 主要通過改造注意力算子壓縮 KV 緩存大小,將每個查詢 KV 量減少 93.3%,實現了在同樣容量下存儲更多 KV 緩存,極大提升了推理效率。

MoE 用于高效訓練,其由多個專家模型組成,通過部分激活給定任務所需的特定專家,而不是激活整個神經網絡,從而降低計算消耗。MoE 非 DeepSeek 原創,但 DeepSeek 早在 V2 之前的代碼和數學模型(DeepSeek-Coder&DeepSeek-Math),就從稠密架構轉向 MoE 架構。V3 模型中更是大膽地使用了高難度的 256 個路由專家和 1 個共享專家,并創新的采用冗余專家,來實現負載均衡策略和訓練目標。

3.“貼身定制”的軟硬協同工程優化

由于眾所周知的“芯片限制”,DeepSeek 在探索推理范式和模型架構創新的同時,在工程優化方面也絲毫沒有放松。分別從計算、存儲、通信等多個層面實施了軟硬協同的工程優化策略:比如混合精度訓練、跨節點通信優化、雙流水線機制、DualPipe 算法等。甚至采用 PTX 代碼(比 CUDA 更底層的匯編代碼)進行底層優化,實現調整寄存器分配、線程調度、Warp 級別優化。

這種圍繞模型需求,對硬件進行“貼身定制”的軟硬協同工程優化,在一些手握充裕 GPU 卡資源的硅谷大廠技術人員眼里,很像一些“雕蟲小技”。但我想說的是,技術界的雕蟲小技不可小覷,技術領域的創新往往是從這些雕蟲小技開始的。

回顧一下計算歷史:Hadoop 如何倒逼 EMC、IBM 重構存儲架構?ARM 精簡指令集如何用低功耗設計顛覆英特爾 x86 帝國?TCP/IP 協議棧如何倒逼傳統網絡設備革命?記得圖靈獎得主、RISC 指令發明人 David Patterson 曾經有言“硬件架構的創新往往誕生于軟件需求對硬件的持續鞭策”。

如果假以時日,DeepSeek 成為開源大模型領域的標配后,很難說不會出現用“軟件定義硬件”或者說“模型定義硬件”來倒逼硬件廠商,走出一條顛覆英偉達 CUDA 生態的道路。

DeepSeek 對大模型生態的意義

1.大模型成本降到和搜索相當,AI 應用和智能體迎來爆發

DeepSeek 無疑引爆了大模型的成本之戰:(1)自身通過“模型架構創新”和“軟硬件協同工程優化”將大模型訓練成本大幅度降低,大約是 Meta 的 1/10,OpenAI 的 1/20;(2)通過最開放的 MIT 開源協議,和將推理大模型蒸餾給開源小模型等一系列工程方法,為業界帶來低成本的端側模型商品。

谷歌一次搜索成本大約 0.2 美分(0.002 美元),DeepSeek R1 推理成本百萬 token 輸出 16 元(2.2 美元), V3 對話輸出百萬 token 2 元(這只是 DeepSeek 官網對外的 API 價格,如果考慮實際發生的推理成本、會更低)。

作為對比:OpenAI o1 百萬 token 輸出 60 美元,是 DeepSeek R1 的 30 倍。如果假設平均一次推理輸出大約 1000 token(相當于大約 500 個漢字)。那么 DeepSeek 一次推理輸出價格大約 2.2 美元/1000 次=0.2 美分,對話輸出大約 0.025 美分。

也就是說,DeepSeek將大模型的推理輸出降到和谷歌一次搜索成本的價格相當,對話輸出則大約是搜索的 1/10。這是具有指標意義的時刻。

我記得 2023 年 4 月份在硅谷訪問時和 Google 做搜索的朋友聊,他談到他們內部從上到下對 ChatGPT 持相當觀望的態度,因為如果按照當時大模型的成本,來對比谷歌的搜索成本,谷歌馬上會從一個盈利 600 億美金的公司,變成一個虧損上千億美金的公司。雖然,大家都預期大模型的成本會不斷降低,但沒想到不到 2 年時間,降低如此之快。

成本一直是技術革命背后的利器。搜索作為互聯網的基礎設施,正是因為極低的成本,才能快速完成對全球信息的整合,引爆了互聯網革命。而 DeepSeek 在 2025 年開年將大模型成本降到和搜索相當,加上性價比極高的端側模型,大模型將很快成為各種應用的基座支撐,GenAI 也將迎來應用爆發的 tipping point。同時隨著強化學習在推理計算帶來的范式轉換,依賴推理能力的智能體 AI Agent 也將迎來加速,2025 年將是大模型應用和智能體爆發的元年。

2.AI 鐵三角迎來新的變量,AI 產業版圖有望被重塑

算法、算力、數據一直是 AI 的鐵三角。隨著大模型成為 AI 科技樹的主流,基于 Transformer 架構、以預訓練為主的模型算法,及其展現的 Scaling Law 一直在向業界傳達一個信息:算力決定一切,訓練數據越多、算力越大,模型性能就會越來越好,所謂“大力出奇跡“。AI 產業的競爭也變成了“誰擁有 GPU 越多、誰的 AI 能力越強”的軍備競賽。

但 DeepSeek 分別從 “后訓練”和“預訓練”兩個階段對這樣的唯算力論提出了響亮的質疑:

(1)后訓練階段——開源強化學習加速推理計算的范式轉換:隨著強化學習成為后訓練階段的標配,推理計算將占比越來越大(相對預訓練計算)。適應預訓練模式的 GPU 大卡集群計算(英偉達的優勢)將不再是未來 AI 算力需求的主流,而英偉達在推理計算方面的優勢相對較弱,很多頭部廠商如谷歌 TPU、AWS Inferentia、華為昇騰等專為推理優化的芯片,在特定負載下能效比顯著高于通用 GPU,加上適應多元推理場景的分布式計算、邊緣計算、端側計算,推理算力領域將不會是英偉達一家獨大的局面。

(2)預訓練階段——通過 MoE 和 MLA 等對經典 Transformer 架構進行的改進和迭代:這使得 DeepSeek 使用少于同行 10~20 倍的算力,完成了同等規模的預訓練。另外,DeepSeek 使用 R1 作為教師模型來實現對小模型的“強化學習推理能力”蒸餾的工程實踐,也會為很多模型訓練帶來一波紅利。

DeepSeek 從 “后訓練”和“預訓練”兩階段對 AI 算法進行的創新,為“算法、算力、數據”構建的 AI 鐵三角帶來新的變量,有機會重新塑造未來 AI 產業的發展版圖。

3.開源的長期主義是創新搖籃

最后,說說 DeepSeek 的開源戰略。DeepSeek 支持商業友好的 MIT 許可證(最為寬松的開源協議之一),開源模型權重,沒有對下游應用的限制(比如合成數據、蒸餾等)。論文開放的技術細節也很有誠意。在全球排名 Top 10 的頭部模型中,DeepSeek 是開源程度最高的,比最早扛起開源大旗的 Meta 的 LLaMA 還要更 Open。這也是 DeepSeek V3 和 R1 在海內外引起眾多權威專家、大佬認可+尊重、甚至贊不絕口的原因。不隱藏、不吹噓,模型、評測、原理等都結結實實擺在那里。

順便說一句, DeepSeek 的論文從一開始就大大方方地承認了其在微觀設計上遵循了 LLaMA 的設計。相對國內各種扭扭捏捏、遮遮掩掩的“半開源”,以及違背開源協議、使用開源實現自己的閉源,DeepSeek 在模型開源方面可以說相當慷慨、也很敞亮。

DeepSeek 實際上在第一天就擁抱開源,回想起早期閱讀《DeepSeek LLM :用長期主義來擴展開源語言模型》 這篇 DeepSeek 于 2024 年 1 月發表的論文,對開源的信仰和宣言,讀起來讓人心生敬意。深層次來看,DeepSeek 是真正深刻領悟開源精神、站在全人類創新的高度、從戰略而非戰術上擁抱開源的。

摘抄 DeepSeek 創始人梁文鋒 2024 年 7 月份接受采訪中的一段話“我們認為當下最重要的,是參與全球科技創新。長期以來,中國企業習慣于利用海外的技術創新,并通過應用層面進行商業化,但這種模式是不可持續的。我們的目標不是快速盈利,而是推動技術前沿的發展,從根本上促進整個生態的成長。開源和發表論文不會帶來重大損失。對于技術人員來說,被同行追隨本身就是一種成就。開源不僅僅是商業策略,更是一種文化。”以此觀之,2025 年 1 月,DeepSeek V3 和 R1 給全球 AI 界帶來的震撼,不足為奇。

DeepSeek 的成功點亮了中國技術界最純粹、最原始的創新火種,他們會激勵一代又一代的中國技術人為全世界做出自己獨特的創新。致敬 DeepSeek。

-

AI

+關注

關注

88文章

34691瀏覽量

276653 -

DeepSeek

+關注

關注

1文章

787瀏覽量

1528

原文標題:李建忠:DeepSeek 關鍵技術創新及對 AI 生態的影響

文章出處:【微信號:AI科技大本營,微信公眾號:AI科技大本營】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

耐能KNEO Pi開發板的三大技術革新

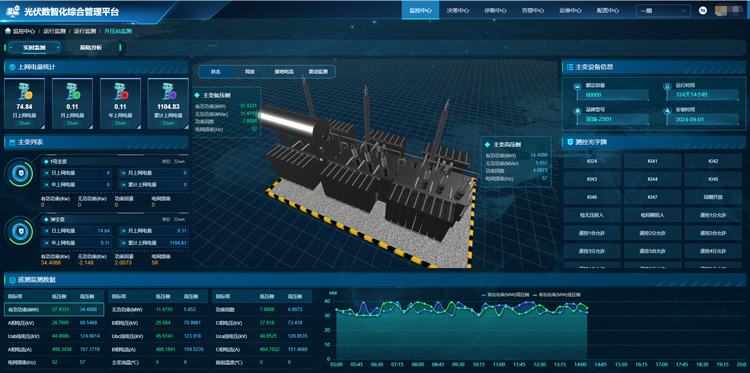

光伏電站智能運維:技術革新引領綠色能源新時代

FPGA+AI王炸組合如何重塑未來世界:看看DeepSeek東方神秘力量如何預測......

DeepSeek模型引領AI變革,廣電運通率先集成應用

AI賦能邊緣網關:開啟智能時代的新藍海

IBM CEO:DeepSeek將加速AI技術采用

引領少兒 AI 編程教育革新!英荔教育率先接入 DeepSeek

新華三全面接入DeepSeek,引領AI發展新熱潮

DeepSeek:引領全球AI競賽的中國新范式

蓄電池放電技術革新:引領能源存儲新時代

吉利汽車與DeepSeek深度融合,引領智能汽車AI新紀元

研華AI Agent引領工業物聯網應用革新

技術革新:AI與RFID的融合,亞馬遜引領零售行業變革

全球視野下的PCB線路板:技術革新引領產業變革

李建忠:DeepSeek技術革新引領AI生態新變革

李建忠:DeepSeek技術革新引領AI生態新變革

評論