編者按:今天外網有一篇論文非常火,它提出了一種序列到序列預測的新方法,無需編碼器和解碼器,只用一個2D卷積神經網絡就能超過現(xiàn)有方法的性能。當然,論文內容絕不是點贊的唯一理由……重點是,真的好萌

摘要

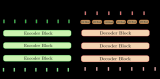

當前最先進的機器翻譯系統(tǒng)都基于Encoder-Decoder框架:輸入序列后,系統(tǒng)先對序列進行編碼,然后基于輸入序列的編碼生成輸出序列。為了讓系統(tǒng)能基于解碼器狀態(tài)重新組合源語句單詞的固定編碼,現(xiàn)在編碼器和解碼器中間往往會有一個注意力模型。

我們提出了一種替代方法,它依賴于跨兩個序列的單個2D卷積神經網絡。網絡的每一層都會根據(jù)到目前為止產生的輸出序列重新編碼源語句單詞。因此,其實類似注意力的屬性在整個網絡中都是普遍存在的。實驗證明,我們的模型產生了出色的結果,它優(yōu)于最先進的Encoder-Decoder框架,同時,它在概念上更簡單,參數(shù)也更少。

簡介

現(xiàn)如今,深層神經網絡對自然語言處理技術產生了深遠的影響,其中以機器翻譯(MT)最為明顯。這是一種序列到序列的預測問題,解決它的最先進方法是使用帶注意力模塊的編碼器-解碼器模型。注意力模塊能在解碼過程中重復地重新訪問源序列,提高模型的預測效率和精度。

但是,注意力機制存在局限。它的常規(guī)做法是在源語句上做簡單加權,用到的權重也只是源單詞和目標單詞之間的淺匹配結果。它只能重新組合相同的源單詞編碼,在解碼時并不能重新編碼,也無法重新解釋源序列。

為了解決這些局限,我們提出了一種基于深層2D卷積神經網絡(CNN)的新方法。它和圖像、音頻生成模型的自回歸模型類似,用源序列和目標序列的輸出空間定義網絡中的2D網格,同時禁止卷積filter從目標序列的單詞中獲得未來信息。具體如下圖所示:

卷積層的filter大小是3×3,它只能根據(jù)先前的輸出計算,不能讀取目標序列內容。圖中深藍色表示一層感受野,淺藍色是二層感受野,灰色部分是filter被禁止查看的部分

輸入源-目標張量:設給定源語句的長度為|s|,目標對(s, t)的長度為|t|。首先,在ds和dt維空間中通過查找表嵌入詞向量。整合兩個空間,f0= dt+ ds,把嵌入的詞向量{x1, . . . , x|s|}和{y1, . . . , y|t|}并成三維向量X∈R|t|×|s|×f0,其中,

這是卷積神經網絡的輸入。

卷積層:卷積層參考的是DenseNet的架構,這是圖像分類任務上的最新技術。網絡中的層都是密集連接的,這意味著不僅是最后一層,每個層都會把前一層的激活函數(shù)輸出作為自己的輸入,從而生成g特征映射。這個參數(shù)g是“增長率”,表示每層網絡輸出的附加通道數(shù)。

DenseNet架構

目標序列預測:從最初的f0特征映射開始,DenseNet中的每一層l∈{1, . . . , L}會產生一個大小為|t|×|s|×fl的張量,其中fl是該層的輸出通道數(shù)。

為了計算輸出中的單詞分布,我們要折疊張量的第二維,因為它來自輸入序列的可變長度,能檢索每個目標位置的唯一編碼。而做到這點的具體方法是添加一個最大池化層或對輸入序列做平均池化。完成池化后,我們可以根據(jù)詞典用特征進行預測。

實驗結果

在實驗階段,我們測試了深層CNN和先進編碼器-解碼器機器翻譯模型在IWSLT德英互譯任務上的效果,數(shù)據(jù)如上表所示。其中Pervasive Attention是本文提出的方法。可以發(fā)現(xiàn),無論是德譯英還是英譯德,各模型在BPE(字節(jié)對編碼)上獲得的所有結果都優(yōu)于基于單詞的結果。

而橫向對比來看,Pervasive Attention和RNN Reasearch有相同的參數(shù)量,但前者的BLEU分數(shù)比后者高了近3點。Vaswani等人和Gehring等人提出的兩個模型可以被看作是近期的最新研究,相比之前的記錄,它們確實有不小的進步,但Pervasive Attention還是超過了它們,并且參數(shù)只有它們的1/3和1/8。

從計算成本看,Pervasive Attention和RNN Reasearch差不多;而convs2s由于進行了很好的優(yōu)化,訓練用時更短。

小結

本文提出了一種新的神經機器翻譯架構,它脫離了編碼器-解碼器的范疇,能把源序列和目標序列聯(lián)合編碼為深度特征層次結構,其中源語句單詞會被嵌入部分目標序列的上下文中。

總得來看,這是一個基于DenseNet的二維CNN,它具有類似注意力機制的屬性,理念更簡單,參數(shù)更好,性能也更好。

-

編碼器

+關注

關注

45文章

3782瀏覽量

137420 -

神經網絡

+關注

關注

42文章

4811瀏覽量

103019 -

機器翻譯

+關注

關注

0文章

140瀏覽量

15148

原文標題:Pervasive Attention:用于序列到序列預測的2D卷積神經網絡

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

機器翻譯三大核心技術原理 | AI知識科普 2

神經機器翻譯的編碼-解碼架構有了新進展, 具體要怎么配置?

編碼器和解碼器的區(qū)別是什么,編碼器用軟件還是硬件好

基于結構感知的雙編碼器解碼器模型

PyTorch教程10.7之用于機器翻譯的編碼器-解碼器Seq2Seq

基于transformer的編碼器-解碼器模型的工作原理

一種新的神經機器翻譯架構,它脫離了編碼器-解碼器的范疇

一種新的神經機器翻譯架構,它脫離了編碼器-解碼器的范疇

評論