谷歌語音輸入法可離線識別啦!

這次出手的,又是谷歌 AI 團隊。剛剛,他們為旗下的一款手機輸入法 Gboard (不要跟谷歌拼音輸入法搞混了啊~)上線了新功能:離線語音識別。目前這一新功能,只能在其自家的產品 Pixel 系列手機上使用。

廣大已經下載或正在趕往下載路上的 Pixel 圈外人士,包括 iOS 用戶可能都會失望了。

他們是這樣描述這款新功能的配置的:端到端、全神經、本地部署的語音識別系統。

在其最近的論文 “Streaming End-to-End Speech Recognition for Mobile Devices” 中,他們提出了一種基于 RNN-T(RNN transducer)的訓練模型。

它非常緊湊,可滿足在手機上部署。這意味著不會出現太多網絡延遲或紊亂,即使用戶處于脫機狀態,這款語音識別系統也始終可用。該模型始終以字符級工作, 因此即便你說話,它也會逐個字符地輸出單詞,就好像有人在實時鍵入并準確在虛擬鍵盤聽寫出你說的話。

例如,下面兩張圖片中展示的是在聽寫系統中輸入相同句子時的情況展示:左側為服務器端,右側為本地端。哪邊的語音識別體驗更好呢?

總結起來就是,“離線狀態下,沒有任何延遲。”這也是谷歌此次亮出的大殺器。

發生延遲是因為你的語音數據必須從手機傳輸到服務器上,解析完成后再返回。這可能需要幾毫秒甚至幾秒的時間。萬一語音數據包在以太網中丟失,則需要更長的時間。

將語音轉換成毫秒級的文本需要相當多的計算力。這不只簡單是聽到聲音然后寫一個單詞那么簡單,而是需要理解一個人講話的含義,以及背后涉及的很多有關語言和意圖的上下文語境。

在手機上是可以做到這一點的,但如此的話,又會很損耗電池電量。

語音識別模型簡史

一般來講,語音識別系統由幾個部分組成:將音頻片段(通常為 10 毫秒幀)映射到音素的聲學模型、將音素連接起來形成單詞的發聲模型,以及一個表達給定模型的語言模型。在早期系統,這些組件是相對獨立優化的。

2014 年左右,研究人員開始專注于訓練單個神經網絡,將輸入音頻波形直接映射到輸出句子。通過在給定一系列音頻特征的情況下生成一系列單詞或字形來學習模型,這種 sequence-to-sequence 的方法促使了 attention-based 和 listen-attend-spell(LAS)模型的誕生。雖然這些模型在準確性方面表現出極大的前景,但它們通常會檢查整個輸入序列,并且在輸入時不允許輸出,這是實時語音轉錄的必要特征。

同時,一種稱為 connectionist temporal classification(CTC)的技術有助于減少當時識別系統的延時問題。這對于后來創建 RNN-T 架構是一次重要的里程碑,也被看作是 CTC 技術的一次泛化。

(編者注:CTC,其全稱為 Connectionist Temporal Classfication,由 Graves 等人于 2006 年提出,用于訓練遞歸神經網絡(RNN)以解決時序可變的序列問題。它可用于在線手寫識別或識別語音音頻中音素等任務。發展到如今,CTC 早已不是新名詞,它在工業界的應用十分成熟。例如,在百度近日公布的在線語音識別輸入法中,其最新語音模型在CTC 的基礎上還融合了 Attention 等新技術。)

何為RNN-T?

RNN-T 是一種不采用注意力機制的 sequence-to-sequence 模型。與大多數 sequence-to-sequence 模型(通常需要處理整個輸入序列(在語音識別中即是波形)以產生輸出句子)不同,RNN-T 會連續處理輸入樣本和流輸出符號。

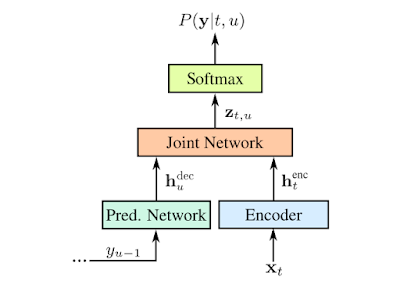

輸出符號是字母表的字符。RNN-T 會逐個輸出字符,并在適當的位置輸入空格。它通過反饋循環執行此操作,該訓練將模型預測的符號反饋到其中以預測下一個符號。如下圖所示。

用輸入音頻樣本 x 和預測符號 y 表示 RNN-T。預測符號(Softmax 層的輸出)通過預測網絡反饋到模型中。

有效訓練這樣的模型已經很困難,但隨著新開發的訓練技術進一步將單詞錯誤率降低了 5%,它的計算強度變得更高。為了解決這個問題,研究人員開發了一個并行實現過程,因此 RNN-T 損失功能可以在 Google Cloud TPU v2 上大批量運行。訓練中實現了大約 3 倍的加速。

離線識別

在傳統的語音識別引擎中,聲學、發聲和語音模型組合成一個大的圖搜索(search graph),其邊緣用語音單元及其概率標記。當語音波形呈現給識別系統時,“解碼器”在給定輸入信號的情況下會搜索圖中相似度最高的路徑,并讀出該路徑所采用字序列。通常,解碼器采用基礎模型的有限狀態傳感器(Finite State Transducer, FST)表示。然而,盡管有復雜的解碼技術,圖搜索仍很困難,因為生產模型幾乎有 2GB 大小。這可不是在移動電話上想托管就可以實現的,因此這種方法需要在線連接才能正常使用。

為了提高語音識別的有效性,研究人員嘗試直接在設備上托管新模型以避免通信網絡的延遲和固有的不可靠性。因此,端到端的方法不需要在大型解碼器圖上進行搜索。相反,解碼器包括通過單個神經網絡的集束搜索(beam search)。RNN-T 與傳統的基于服務器端的模型具有相同的精度,但前者只有 450MB,而且更加智能地使用參數和打包信息。但即便在如今的智能手機上,450MB 還是占用了很大的空間,例如通過大型網絡是信號傳播可能會很慢。

因此,研究人員通過使用參數量化和混合內核技術進一步減小了模型大小。這項技術早在 2016 年就已發布,并在 TensorFlow Lite 版本中提供公開的模型優化工具包。模型量化相對于訓練的浮點模型提供 4 倍壓縮,在運行時實現了 4 倍加速,這使得 RNN-T 比單核上的實時語音運行得更快。壓縮后,最終模型大小只占 80MB。

效果如何?

谷歌公開這一新功能后,TechCrunch 評論稱,“鑒于 Google 的其他產品幾乎沒有是離線工作的,那么你會在離線狀態下寫一封電子郵件嗎?當然,在網絡條件不好的情況下,這款應用新功能可能會解決了用戶痛點,但顯然,這還是有點諷刺(雞肋)。”

而這也一度吸引來了 HackerNews 上不少用戶評論,他們也將部分矛頭指向了所謂的“離線功能”:

“離線功能雖然不是最主要的吸引力,但正如本文中提到的,延遲問題的減少是巨大的。他們可能沒有提及的是對隱私問題的影響。不過,用戶一般不會離線處理事物,但如果需要來回的穩定數據包流,連接網絡也是很麻煩的問題。”

不過,經過嘗試后的用戶還是非常看好:“我只是將我的 Pixel1 代切換到飛行模型,并嘗試了語音輸入。果然,它的離線工作速度很快!這令人非常印象深刻(我之前嘗試過,但過去它只能理解一些特殊的短語。)

有多好方法可以實現這一功能呢,但我認為任何應用都能從這次語音的改進中受益。“

為此,營長也特意下載了 Gboard、訊飛、百度三家語音輸入法,試看它們在飛行模式下的效果如何。

Round 1

Gboard:目前非 Pixel 手機中離線語音尚無法使用,且針對某些機型甚至不支持語音。不過,打字還是比較絲滑流暢的。

Round 2

訊飛:可下載離線語音包,不過在正常網絡通暢情況下,語音識別的速度和準確性還是相當高的。

Round 3

百度:也可下載離線語音,無網絡連接狀態下,語音識別效果還是可以的。

不知國內經常使用訊飛、百度輸入法的小伙伴們,看到這一消息有何想法?歡迎留言。

-

谷歌

+關注

關注

27文章

6231瀏覽量

107997 -

輸入法

+關注

關注

0文章

48瀏覽量

9905 -

語音識別

+關注

關注

39文章

1779瀏覽量

114166

原文標題:Google又逆天:語音輸入離線實時輸出文字,僅占80MB!然而……

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【AWTK使用經驗】如何使用系統輸入法與開啟最大化窗口功能

微軟拼音輸入法導致KiCad卡死

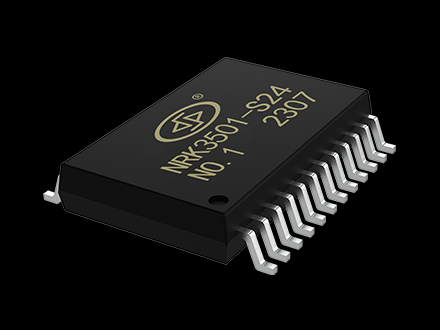

EVS103智能純離線語音識別芯片介紹

TLV320AIC3204N1_L有語音輸入、IN1_R沒語音輸入時,采集IN1_R的數據聲音是IN1_L端的聲音,為什么?

瑞芯微RK3566鴻蒙開發板Android11修改第三方輸入法為默認輸入法

智能玩具用離線語音識別芯片有什么優勢

谷歌語音輸入法可離線識別啦!

谷歌語音輸入法可離線識別啦!

評論