“Jeff Dean稱贊,TensorFlow官方推特支持,BERT目前工業界最耗時的應用,計算量遠高于ImageNet。我們將BERT的訓練時間從三天縮短到了一小時多。”UC Berkeley大學在讀博士尤洋如是說道。

近日,來自Google、UC Berkeley、UCLA研究團隊再度合作,成功燃燒1024塊TPU,將BERT預訓練模型的訓練時長從3天縮減到了76分鐘。batch size技術是加速神經網絡訓練的關鍵,在“Reducing BERT Pre-Training Time from 3 Days to 76 Minutes”這篇論文中,作者提出了LAMB優化器,它支持自適應元素更新和分層校正。

論文傳送門:https://arxiv.org/pdf/1904.00962.pdf

論文摘要:batch size增加到很大時的模型訓練是加速大型分布式系統中深度神經網絡訓練的關鍵。但是,這種模型訓練很難,因為它會導致一種泛化差距。直接優化通常會導致測試集上的準確性下降。

BERT是一種先進的深度學習模型,它建立在語義理解的深度雙向轉換器上。當我們增加batch size的大小(如超過8192)時,此前的模型訓練技巧在BERT上表現得并不好。BERT預訓練也需要很長時間才能完成,如在16個TPUv3上大約需要三天。

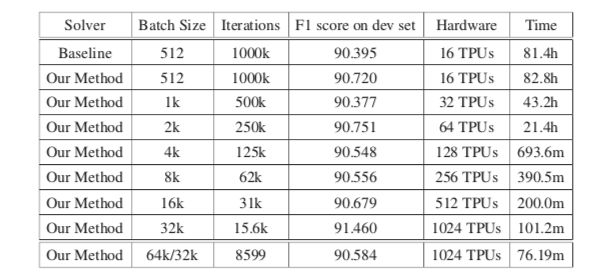

為了解決這個問題,我們提出了LAMB優化器,可將batch size擴展到65536,且不會降低準確率。LAMB是一個通用優化器,batch size大小均使用,且除了學習率之外不需要別的參數調整。

基線BERT-Large模型需要100萬次迭代才能完成預訓練,而batch size大小為65536/32768的LAMB僅需要8599次迭代。我們還將batch size進行內存限制,接近TPUv3 pod,結果可在76分鐘內完成BERT訓練。

據悉,該論文的一作是來自UC Berkeley計算機科學部的在讀博士尤洋,同時也是Google Brain的實習生。據公開信息顯示,尤洋的導師是美國科學院與工程院院士,ACM/IEEE fellow,伯克利計算機系主任,以及首批中關村海外顧問James Demmel教授。他當前的研究重點是大規模深度學習訓練算法的分布式優化。2017年9月,尤洋等人的新算法以24分鐘完成ImageNet訓練,刷新世界紀錄。

在此之前,他曾在英特爾實驗室、微軟研究院、英偉達、IBM沃森研究中心等機構實習。尤洋本科就讀于中國農業大學計算機系,碩士保送清華大學計算機系,是一名杠杠的理工學霸!

-

神經網絡

+關注

關注

42文章

4810瀏覽量

102918 -

TPU

+關注

關注

0文章

152瀏覽量

21097 -

深度學習

+關注

關注

73文章

5555瀏覽量

122534 -

訓練模型

+關注

關注

1文章

37瀏覽量

3940

原文標題:1024塊TPU在燃燒!BERT訓練從3天縮短到76分鐘 | 技術頭條

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

用PaddleNLP為GPT-2模型制作FineWeb二進制預訓練數據集

1024塊TPU在燃燒!將BERT預訓練模型的訓練時長從3天縮減到了76分鐘

1024塊TPU在燃燒!將BERT預訓練模型的訓練時長從3天縮減到了76分鐘

評論