這是一個(gè)系列教程,試圖將機(jī)器學(xué)習(xí)這門深?yuàn)W的課程,以更加淺顯易懂的方式講出來(lái),讓沒(méi)有理科背景的讀者都能看懂。

前情提要:這是一個(gè)系列教程。如果你剛好第一次看到這篇文章,那么你可能需要收藏一下本篇文章,然后先看一下這個(gè)系列的前一篇《文科生都能看懂的機(jī)器學(xué)習(xí)教程:梯度下降、線性回歸、邏輯回歸》。如果你已經(jīng)看過(guò)了,那么就不再多說(shuō),讓我們繼續(xù)吧。

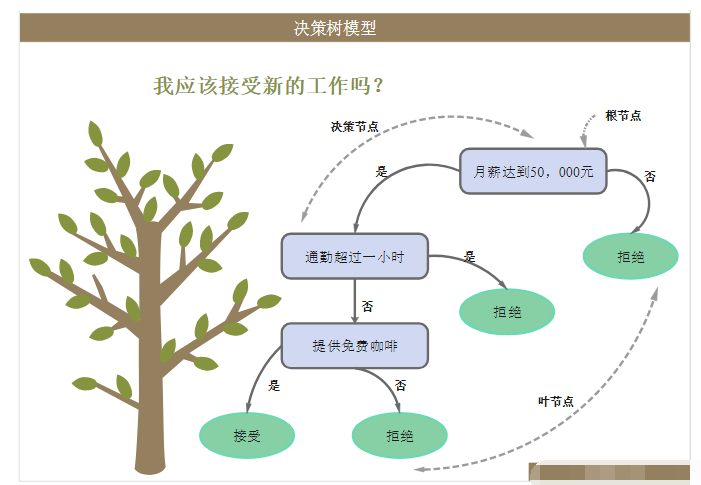

本次主要講的是決策樹和隨機(jī)森林模型,

決策樹

決策樹是個(gè)超簡(jiǎn)單結(jié)構(gòu),我們每天都在頭腦中使用它。它代表了我們?nèi)绾巫龀鰶Q策的表現(xiàn)形式之一,類似if-this-then-that:

首先從一個(gè)問(wèn)題開始;然后給出這個(gè)問(wèn)題的可能答案,然后是這個(gè)答案的衍生問(wèn)題,然后是衍生問(wèn)題的答案…直到每個(gè)問(wèn)題都有答案。程序員和PM應(yīng)該這個(gè)流程非常熟悉的。

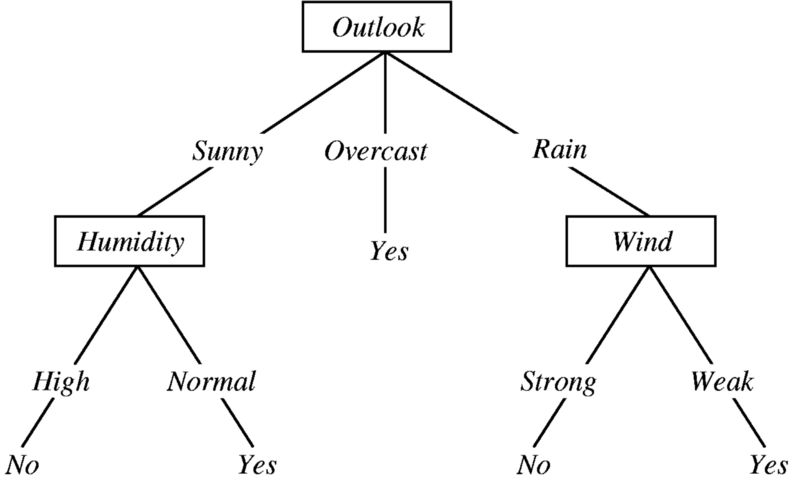

先看一個(gè)決策樹的例子,決定某人是否應(yīng)該在特定的一天打棒球。

圖片來(lái)源:Ramandeep Kaur的 “ 機(jī)器學(xué)習(xí)與決策樹”

這棵樹從上往下,首先提出一個(gè)問(wèn)題:今天的天氣預(yù)期如何?接下來(lái)會(huì)有三種可能的答案:晴;陰;雨。

1. if 天氣=晴天,那么判斷濕度如何

1. if 濕度高,then 取消

2. if 濕度低,then 去玩

2. if 天氣=陰天,then 去

3. if 天氣=下雨,then 取消

一棵簡(jiǎn)單的決策樹就出來(lái)了。決策樹具備以下特性:

決策樹用于建模非線性關(guān)系(與線性回歸模型和邏輯回歸模型相反)

決策樹可以對(duì)分類和連續(xù)結(jié)果變量進(jìn)行建模,盡管它們主要用于分類任務(wù)(即分類結(jié)果變量)

決策樹很容易理解! 您可以輕松地對(duì)它們進(jìn)行可視化,并準(zhǔn)確找出每個(gè)分割點(diǎn)發(fā)生的情況。 您還可以查看哪些功能最重要

決策樹容易過(guò)擬合。這是因?yàn)闊o(wú)論通過(guò)單個(gè)決策樹運(yùn)行數(shù)據(jù)多少次,因?yàn)橹皇且幌盗衖f-this-then-that語(yǔ)句,所以總是會(huì)得到完全相同的結(jié)果。這意味著決策樹可以非常精確地適配訓(xùn)練數(shù)據(jù),但一旦開始傳遞新數(shù)據(jù),它可能無(wú)法提供有用的預(yù)測(cè)

決策樹有多種算法,最常用的是ID3(ID代表“迭代二分法”)和CART(CART代表“分類和回歸樹”)。這些算法中的每一個(gè)都使用不同的度量來(lái)決定何時(shí)分割。ID3樹使用信息增益 ,而CART樹使用基尼指數(shù) 。

ID3樹和信息增益

基本上ID3樹的全部意義在于最大限度地提高信息收益,因此也被稱為貪婪的樹。

從技術(shù)上講,信息增益是使用熵作為雜質(zhì)測(cè)量的標(biāo)準(zhǔn)。好吧。我們先來(lái)了解一下熵。

簡(jiǎn)單地說(shuō),熵是(dis)順序的衡量標(biāo)準(zhǔn),它能夠表示信息的缺失流量,或者數(shù)據(jù)的混亂程度。缺失大量信息的東西被認(rèn)為是無(wú)序的(即具有高度熵),反之則是低度熵。

舉例說(shuō)明:

假設(shè)一個(gè)凌亂的房間,地板上是臟衣服,也許還有一些樂(lè)高積木,或者switch、iPad等等。總之房間非常亂,那么它就是熵很高、信息增益很低。

現(xiàn)在你開始清理這個(gè)房間,把散落各處的東西意義歸類。那么就是低熵和高信息增益。

好,回到?jīng)Q策樹。ID3樹將始終做出讓他們獲得最高收益的決定,更多信息、更少的熵。

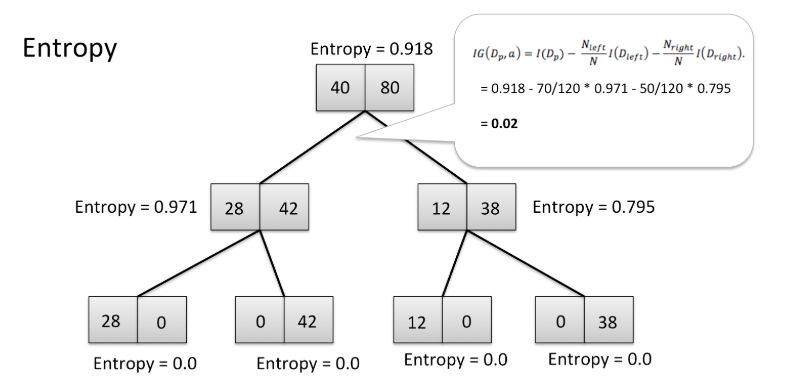

在決策樹中的可視化的熵

在上面的樹中,你可以看到起始點(diǎn)的熵為0.918,而停止點(diǎn)的熵為0.這棵樹以高信息增益和低熵結(jié)束,這正是我們想要的。

除了向低熵方向發(fā)展外,ID3樹還將做出讓他們獲得最高純度的決定。 因?yàn)镮D3希望每個(gè)決定都盡可能清晰,具有低熵的物質(zhì)也具有高純度,高信息增益=低熵=高純度。

其實(shí)結(jié)合到現(xiàn)實(shí)生活中,如果某些事情令人困惑和混亂(即具有高熵),那么對(duì)該事物的理解就會(huì)是模糊的,不清楚的或不純的。

CART樹和基尼指數(shù)

和ID3算法不同,CART算法的決策樹旨在最小化基尼指數(shù)。

基尼指數(shù)可以表示數(shù)據(jù)集中隨機(jī)選擇的數(shù)據(jù)點(diǎn)可能被錯(cuò)誤分類的頻率。 我們總是希望最小化錯(cuò)誤標(biāo)記數(shù)據(jù)可能性對(duì)吧,這就是CART樹的目的。

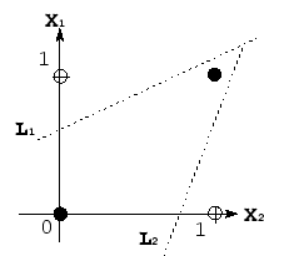

線性模型下線性函數(shù)的可視化

隨機(jī)森林

隨機(jī)森林可以說(shuō)是初學(xué)數(shù)據(jù)科學(xué)家最受歡迎的集合模型。

集合模型顧名思義。是許多其他模型的集合。

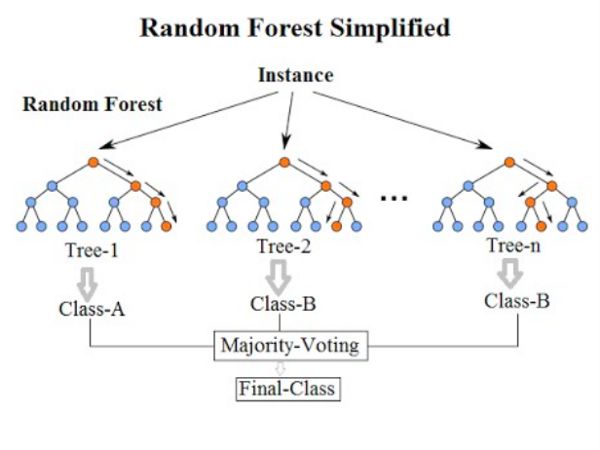

來(lái)自KDNuggets的隨機(jī)森林結(jié)構(gòu)。

正如你在左邊的圖表中看到的3個(gè)決策樹,像Random Forest這樣的集合模型只是一堆決策樹。

像隨機(jī)森林這樣的集合模型,旨在通過(guò)使用引導(dǎo)聚集算法(裝袋算法)來(lái)減少過(guò)度擬合和方差。

我們知道決策樹容易過(guò)擬合。換句話說(shuō),單個(gè)決策樹可以很好地找到特定問(wèn)題的解決方案,但如果應(yīng)用于以前從未見(jiàn)過(guò)的問(wèn)題則非常糟糕。俗話說(shuō)三個(gè)臭皮匠賽過(guò)諸葛亮,隨機(jī)森林就利用了多個(gè)決策樹,來(lái)應(yīng)對(duì)多種不同場(chǎng)景。

然而在數(shù)據(jù)科學(xué)領(lǐng)域,除了過(guò)度擬合,我們還要解決另一個(gè)問(wèn)題叫做方差。具有“高方差”的模型,盡管輸入最微小的位改變,其結(jié)果也會(huì)有很大的變化,類似于失之毫厘謬以千里,這意味著具有高方差的模型不能很好地概括為新數(shù)據(jù)。

裝袋算法

在深入研究隨機(jī)森林依賴的裝袋算法之前,仍然了解一個(gè)概念:learner。

在機(jī)器學(xué)習(xí)中,分為弱learner和強(qiáng)learner,裝袋算法主要用于處理弱learner。

弱learner

弱learner構(gòu)成了隨機(jī)森林模型的支柱,它是一種算法,可以準(zhǔn)確地對(duì)數(shù)據(jù)進(jìn)行預(yù)測(cè)/分類!

像隨機(jī)森林這樣的集合模型使用裝袋算法來(lái)避免高方差和過(guò)度擬合的缺陷,而單個(gè)決策樹等更簡(jiǎn)單的模型更容易出現(xiàn)。

當(dāng)算法通過(guò)隨機(jī)數(shù)據(jù)樣本建立決策樹時(shí),所有數(shù)據(jù)都是可以被利用起來(lái)的。

綜上所述: 隨機(jī)森林模型使用裝袋算法來(lái)構(gòu)建較少的決策樹,每個(gè)決策樹與數(shù)據(jù)的隨機(jī)子集同時(shí)構(gòu)建。

隨機(jī)森林模型中的每個(gè)樹不僅包含數(shù)據(jù)的子集,每個(gè)樹也只使用數(shù)據(jù)的特征子集。

隨機(jī)森林模型的基本結(jié)構(gòu)( 隨機(jī)森林,決策樹和集合方法由Dylan Storey 解釋 )

通過(guò)這篇文章,我們學(xué)習(xí)了所有關(guān)于決策樹、過(guò)度擬合和方差以及隨機(jī)森林等集合模型。第三部分將介紹兩個(gè)線性模型:SVM和樸素貝葉斯。

-

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8499瀏覽量

134334 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25368 -

決策樹

+關(guān)注

關(guān)注

3文章

96瀏覽量

13799

原文標(biāo)題:文科生也能看懂的機(jī)器學(xué)習(xí)教程2:決策樹和隨機(jī)森林

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

關(guān)于決策樹,這些知識(shí)點(diǎn)不可錯(cuò)過(guò)

介紹支持向量機(jī)與決策樹集成等模型的應(yīng)用

決策樹的生成資料

解讀決策樹與隨機(jī)森林模型的概念

決策樹的構(gòu)建設(shè)計(jì)并用Graphviz實(shí)現(xiàn)決策樹的可視化

人工智能機(jī)器學(xué)習(xí)之隨機(jī)森林(RF)

決策樹的原理和決策樹構(gòu)建的準(zhǔn)備工作,機(jī)器學(xué)習(xí)決策樹的原理

什么是決策樹模型,決策樹模型的繪制方法

使用TensorFlow決策森林創(chuàng)建提升樹模型

大數(shù)據(jù)—決策樹

什么是隨機(jī)森林?隨機(jī)森林的工作原理

決策樹和隨機(jī)森林模型

決策樹和隨機(jī)森林模型

評(píng)論