在過去十年中,機(jī)器學(xué)習(xí)在圖像識(shí)別、自動(dòng)駕駛汽車和圍棋等領(lǐng)域取得了前所未有的進(jìn)步。這些成功在很大程度上是靠監(jiān)督學(xué)習(xí)和強(qiáng)化學(xué)習(xí)來實(shí)現(xiàn)的。

這兩種方法都要求由人設(shè)計(jì)訓(xùn)練信號(hào)并傳遞給計(jì)算機(jī)。在監(jiān)督學(xué)習(xí)的情況下,這些是“目標(biāo)”(例如圖像的正確標(biāo)簽); 在強(qiáng)化學(xué)習(xí)的情況下,它們是成功行為的“獎(jiǎng)勵(lì)”(例如在Atari游戲中獲得高分)。因此,機(jī)器學(xué)習(xí)的極限是由人類訓(xùn)練師決定的。

但是學(xué)習(xí)知識(shí)還應(yīng)該有其他的策略,就像讓幼兒學(xué)習(xí),不僅有指導(dǎo)(監(jiān)督學(xué)習(xí))和鼓勵(lì)(強(qiáng)化學(xué)習(xí)),還應(yīng)該有自由探索世界(無監(jiān)督學(xué)習(xí))。如果要讓AI脫離人類發(fā)展成出通用智能,必須要讓它掌握無監(jiān)督學(xué)習(xí)的技能。

DeepMind今天在官方博客中對(duì)無監(jiān)督學(xué)習(xí)的原理、近年來取得的成果、發(fā)展前景進(jìn)行了綜述。

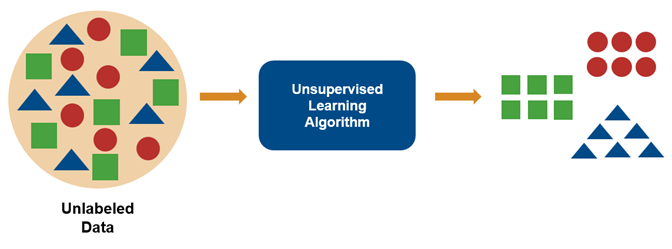

無監(jiān)督學(xué)習(xí)關(guān)鍵的特點(diǎn)是,傳遞給算法的數(shù)據(jù)在內(nèi)部結(jié)構(gòu)中非常豐富,而用于訓(xùn)練的目標(biāo)和獎(jiǎng)勵(lì)非常稀少。無監(jiān)督學(xué)習(xí)算法學(xué)到的大部分內(nèi)容必須包括理解數(shù)據(jù)本身,而不是將這種理解應(yīng)用于特定任務(wù)。

解碼視覺元素

2012年是深度學(xué)習(xí)的里程碑,AlexNet席卷了ImageNet圖像分類競賽,但是更引人注目的是藏在AlexNet之下的事情。

研究人員在分析AlexNet時(shí)發(fā)現(xiàn),它通過為輸入構(gòu)建復(fù)雜的內(nèi)部表示來解釋圖像,低層次的特征,如紋理和邊緣在底層中表示,然后將它們組合在一起形成高級(jí)概念,例如更高層次中的輪子和狗。

這與我們的大腦中處理信息的方式非常相似,其中初級(jí)感官處理區(qū)域中的簡單邊緣和紋理,然后組裝成復(fù)雜對(duì)象。因此復(fù)雜場景的表示可以由“視覺基元”所構(gòu)建,這種方式與單詞構(gòu)成句子大致相同。

在沒有人類明確的指導(dǎo)的情況下,研究人員發(fā)現(xiàn)AlexNet的層可以通過基本的“視覺詞匯”來解決任務(wù)。

遷移學(xué)習(xí)

AlexNet還可以被遷移到訓(xùn)練之外的視覺任務(wù)中,例如識(shí)別整個(gè)場景而不是單個(gè)圖像。

人類就非常擅長這種學(xué)習(xí)方法,我們能迅速調(diào)整自己的經(jīng)驗(yàn),以適應(yīng)新的技能和理解收集到的信息。例如,經(jīng)過專業(yè)訓(xùn)練的鋼琴家可以相對(duì)輕松地掌握彈奏爵士鋼琴的方法。

理論上,構(gòu)成世界正確內(nèi)部表征的智能體應(yīng)該能夠做同樣的事情。

但是AlexNet等分類器所學(xué)到的表示仍具有局限性,特別是網(wǎng)絡(luò)只用單一類別標(biāo)記圖像訓(xùn)練時(shí),那些推斷標(biāo)簽時(shí)用不上的信息 ,無論它在其他任務(wù)中用處多大,都可能被網(wǎng)絡(luò)所忽略。如果標(biāo)簽總是指向前景,則表示可能無法獲取圖像的背景。

一種可能的解決方案是提供更全面的訓(xùn)練信號(hào),比如描述圖像的詳細(xì)內(nèi)容,不單單把圖像描述成“狗”,而是“柯基犬在陽光明媚的公園里叼飛盤”。

但是,這些信息很難大規(guī)模提供,而且這樣做仍然有可能不足以捕獲完成任務(wù)所需的全部信息。

無監(jiān)督學(xué)習(xí)的基本前提是學(xué)習(xí)豐富、可廣泛轉(zhuǎn)移表示的最佳方式,這種方式可以學(xué)習(xí)關(guān)于數(shù)據(jù)的全部內(nèi)容。

如果你覺得轉(zhuǎn)移的概念看起來過于抽象,那么請(qǐng)想象一個(gè)學(xué)習(xí)簡筆畫的孩子。她發(fā)現(xiàn)了人體形態(tài)的特征。通過增加具體細(xì)節(jié),她可以為她的所有同學(xué)繪制肖像,加上眼鏡、紅色T恤的同桌等等。

她發(fā)展出這項(xiàng)技能不是為了完成一項(xiàng)特定任務(wù)或獲得獎(jiǎng)勵(lì),而是為了反映她描繪周圍世界的基本要求。

生成模型和GAN

無監(jiān)督學(xué)習(xí)的最簡單目標(biāo)是訓(xùn)練算法生成自己的數(shù)據(jù)實(shí)例,但是模型不應(yīng)該簡單地重現(xiàn)之前訓(xùn)練的數(shù)據(jù),否則就是簡單的記憶行為。

它必須是建立一個(gè)從數(shù)據(jù)中的基礎(chǔ)類模型。不是生成特定的馬或彩虹照片,而是生成馬和彩虹的圖片集;不是來自特定發(fā)言者的特定話語,而是說出話語的一般分布。

生成模型的指導(dǎo)原則是,能夠構(gòu)建一個(gè)令人信服的數(shù)據(jù)示例是理解它的最有力證據(jù)。正如物理學(xué)家理查德·費(fèi)曼所說:“我不能創(chuàng)造的東西,我就不能了解”(What I cannot create, I do not understand.)。

對(duì)于圖像來說,迄今為止最成功的生成模型是生成對(duì)抗網(wǎng)絡(luò)(GAN)。它由兩個(gè)網(wǎng)絡(luò)組成:一個(gè)生成器和一個(gè)鑒別器,分別負(fù)責(zé)偽造圖片和識(shí)別真假。

生成器產(chǎn)生圖像的目的是誘使鑒別者相信它們是真實(shí)的,同時(shí),鑒別者會(huì)因?yàn)榘l(fā)現(xiàn)假圖片而獲得獎(jiǎng)勵(lì)。

GAN開始生成的圖像是雜亂的和隨機(jī)的,在許多次迭代中被細(xì)化,形成更加逼真的圖像,甚至無法與真實(shí)照片區(qū)別開來。最近英偉達(dá)的GauGAN還能根據(jù)用戶草圖生成圖片。

通過預(yù)測創(chuàng)建內(nèi)容

無監(jiān)督學(xué)習(xí)中另一個(gè)值得注意的成員是自回歸模型,它把數(shù)據(jù)分成一系列小片段,每個(gè)片段依次被預(yù)測。這些模型可以通過連續(xù)猜測接下來會(huì)發(fā)生什么來作為輸入,并能夠再次生成猜測數(shù)據(jù)。

在語言模型中,每個(gè)單詞都是從它之前的單詞預(yù)測出來的。它能夠支持在電子郵件和消息應(yīng)用程序中彈出的文本預(yù)測內(nèi)容。

最近OpenAI公布的GPT-2模型還能能夠生成以假亂真的文字段落。

通過控制用于調(diào)節(jié)輸出預(yù)測的輸入序列,自回歸模型也能用于將一個(gè)序列轉(zhuǎn)換為另一個(gè)序列。例如將文本轉(zhuǎn)換為逼真的手寫體、自然的語音,還能將一種語言翻譯成另一種語言。

自回歸模型以預(yù)測特定順序數(shù)據(jù)的方式來理解數(shù)據(jù)。通過預(yù)測任何其他數(shù)據(jù)的任何部分,可以構(gòu)建更一般的無監(jiān)督學(xué)習(xí)算法。

例如從句子中刪除一個(gè)單詞,并試圖從剩余的內(nèi)容中預(yù)測它。通過學(xué)習(xí)進(jìn)行大量局部預(yù)測,系統(tǒng)被迫從整體上理解數(shù)據(jù)。

生成模型的出現(xiàn)讓人們產(chǎn)生了一種擔(dān)憂,就是它們可能被濫用。雖然通過照片、視頻和音頻編輯操縱證據(jù)歷史已久,但生成模型讓惡意編輯媒體內(nèi)容變得更加容易。一個(gè)知名的“deepfakes”范例是奧巴馬演講視頻片段。

令人鼓舞的是,人們已經(jīng)做出了面對(duì)這些挑戰(zhàn)的努力,包括利用統(tǒng)計(jì)技術(shù)幫助檢測偽造內(nèi)容和驗(yàn)證真實(shí)內(nèi)容、提高公眾意識(shí)、以及圍繞限制生成模型使用范圍展開討論。

生成模型本身也能用在檢測偽造內(nèi)容和異常數(shù)據(jù)。例如,檢測虛假語音或識(shí)別支付異常,保護(hù)客戶免受欺詐。研究人員需要研究生成模型,以便更好地理解它們并降低風(fēng)險(xiǎn)。

實(shí)現(xiàn)通用智能

生成模型本身很吸引人,DeepMind的主要興趣是用它作為通用智能的踏腳石。賦予智能體生成數(shù)據(jù)的能力是一種賦予其想象力的方式,從而能夠規(guī)劃和推理未來。

DeepMind的研究表明,即使沒有明確的生成數(shù)據(jù),學(xué)習(xí)預(yù)測環(huán)境的不同方面可以豐富智能體的世界模型,從而提高其解決問題的能力。

-

AI

+關(guān)注

關(guān)注

87文章

34275瀏覽量

275464 -

DeepMind

+關(guān)注

關(guān)注

0文章

131瀏覽量

11383

原文標(biāo)題:DeepMind綜述無監(jiān)督學(xué)習(xí):通用智能路上的踏腳石,讓AI更聰明

文章出處:【微信號(hào):gh_ecbcc3b6eabf,微信公眾號(hào):人工智能和機(jī)器人研究院】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

使用MATLAB進(jìn)行無監(jiān)督學(xué)習(xí)

【「零基礎(chǔ)開發(fā)AI Agent」閱讀體驗(yàn)】+ 入門篇學(xué)習(xí)

首創(chuàng)開源架構(gòu),天璣AI開發(fā)套件讓端側(cè)AI模型接入得心應(yīng)手

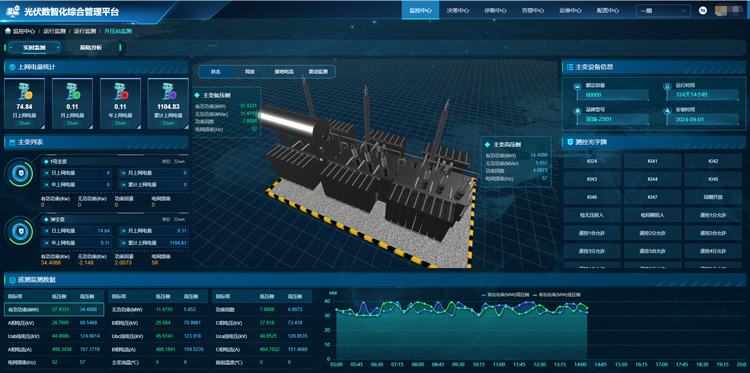

智慧光伏運(yùn)維管理系統(tǒng)讓電站更聰明更省心

無橋PFC變換器綜述

無人機(jī)智能巡檢系統(tǒng)讓運(yùn)維更省心

愛立信如何讓網(wǎng)絡(luò)運(yùn)維更簡單

谷歌加速AI部門整合:AI Studio團(tuán)隊(duì)并入DeepMind

讓AI變得更聰明,他這樣訓(xùn)練和改造AI

時(shí)空引導(dǎo)下的時(shí)間序列自監(jiān)督學(xué)習(xí)框架

DeepMind綜述無監(jiān)督學(xué)習(xí):通用智能路上的踏腳石,讓AI更聰明

DeepMind綜述無監(jiān)督學(xué)習(xí):通用智能路上的踏腳石,讓AI更聰明

評(píng)論