谷歌Evolved Transformer通過AutoML技術(shù)進(jìn)行特定任務(wù)定制,在編碼器和解碼器模塊底部的卷積層以分支模式運(yùn)行,提高了語(yǔ)言建模的性能,目前在機(jī)器翻譯領(lǐng)域可以達(dá)到最先進(jìn)的結(jié)果。

Transformer是一種AI架構(gòu),最早是在2017年Google的科學(xué)家合著的論文《Attention Is All You Need》中介紹的,它比較擅長(zhǎng)撰寫散文和產(chǎn)品評(píng)論、合成聲音、以古典作曲家的風(fēng)格制作和聲。

但是,谷歌的一個(gè)研究小組認(rèn)為它可以更進(jìn)一步使用AutoML技術(shù),根據(jù)特定任務(wù)進(jìn)行定制翻譯。在一篇新發(fā)表的論文和博客中,研究人員描述了工作成果:與原始的Transformer相比,現(xiàn)在的Transformer既達(dá)到了最先進(jìn)的翻譯結(jié)果,也提高了語(yǔ)言建模的性能。

目前,他們已經(jīng)發(fā)布了新的模型Evolved Transformer——開放源代碼的AI模型和數(shù)據(jù)集庫(kù),來(lái)作為Tensor2Tensor(谷歌基于tensorflow新開源的深度學(xué)習(xí)庫(kù),該庫(kù)將深度學(xué)習(xí)所需要的元素封裝成標(biāo)準(zhǔn)化的統(tǒng)一接口,在使用其做模型訓(xùn)練時(shí)可以更加的靈活)的一部分。

一般意義上,AutoML方法是從控制器訓(xùn)練和評(píng)估質(zhì)量的隨機(jī)模型庫(kù)開始,該過程重復(fù)數(shù)千次,每次都會(huì)產(chǎn)生新的經(jīng)過審查的機(jī)器學(xué)習(xí)架構(gòu),控制器可以從中學(xué)習(xí)。最終,控制器開始為模型組件分配高概率,以便這些組件在驗(yàn)證數(shù)據(jù)集上更加準(zhǔn)確,而評(píng)分差的區(qū)域則獲得較低的概率。

研究人員稱,使用AutoML發(fā)現(xiàn)Evolved Transformer需要開發(fā)兩種新技術(shù),因?yàn)橛糜谠u(píng)估每種架構(gòu)性能的任務(wù)WMT'14英德語(yǔ)翻譯的計(jì)算成本很高。

第一種是通過暖啟動(dòng)(warm starting)的方式,將初始模型填充為Transformer架構(gòu)進(jìn)行播種,而不采用隨機(jī)模型,有助于實(shí)現(xiàn)搜索。第二種漸進(jìn)式動(dòng)態(tài)障礙(PDH)則增強(qiáng)了搜索功能,以便將更多的資源分配給能力最強(qiáng)的候選對(duì)象,若模型“明顯不良”,PDH就會(huì)終止評(píng)估,重新分配資源。

通過這兩種技術(shù),研究人員在機(jī)器翻譯上進(jìn)行大規(guī)模NAS,最終找到了Evolved Transformer。

(Evolved Transformer架構(gòu))

那么Evolved Transformer有什么特別之處呢?

與所有深度神經(jīng)網(wǎng)絡(luò)一樣,Evolved Transformer包含神經(jīng)元(函數(shù)),這些神經(jīng)元從輸入數(shù)據(jù)中傳輸“信號(hào),并緩慢調(diào)整每個(gè)連接的突觸強(qiáng)度(權(quán)重),這是模型提取特征和學(xué)習(xí)進(jìn)行預(yù)測(cè)的方式。此外,Evolved Transformer還能使每個(gè)輸出元件連接到每個(gè)輸入元件,并且動(dòng)態(tài)地計(jì)算它們之間的權(quán)重。

與大多數(shù)序列到序列模型一樣,Evolved Transformer包含一個(gè)編碼器,它將輸入數(shù)據(jù)(翻譯任務(wù)中的句子)編碼為嵌入(數(shù)學(xué)表示)和一個(gè)解碼器,同時(shí)使用這些嵌入來(lái)構(gòu)造輸出(翻譯)。

但研究人員也指出,Evolved Transformer也有一些部分與傳統(tǒng)模型不同:在編碼器和解碼器模塊底部的卷積層以分支模式運(yùn)行,即在合并到一起時(shí),輸入需要通過兩個(gè)單獨(dú)的的卷積層。

雖然最初的Transformer僅僅依賴于注意力,但Evolved Transformer是一種利用自我關(guān)注和廣泛卷積的優(yōu)勢(shì)的混合體。

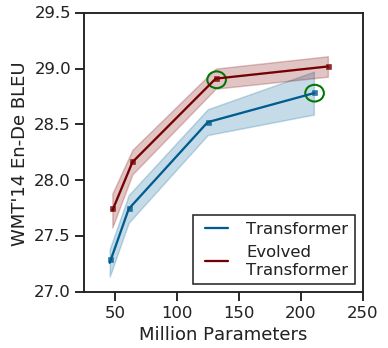

(原始Transforme與Evolved Transformer的性能對(duì)比)

在測(cè)試中,研究人員將Evolved Transformer與原始Transformer在模型搜索期間使用的英德翻譯任務(wù)進(jìn)行了比較,發(fā)現(xiàn)前者在BLEU(評(píng)估機(jī)器翻譯文本質(zhì)量的算法)和Perplexity(衡量概率分布預(yù)測(cè)樣本的程度)上性能更好。

在較大的數(shù)據(jù)中,Evolved Transformer達(dá)到了最先進(jìn)的性能,BLEU得分為29.8分。在涉及不同語(yǔ)言對(duì)和語(yǔ)言建模的翻譯實(shí)驗(yàn)中,Evolved Transformer相比于原始Transformer的性能提升了兩個(gè)Perplexity。

-

谷歌

+關(guān)注

關(guān)注

27文章

6231瀏覽量

108137 -

AI

+關(guān)注

關(guān)注

88文章

35152瀏覽量

279843 -

機(jī)器翻譯

+關(guān)注

關(guān)注

0文章

140瀏覽量

15193 -

Transformer

+關(guān)注

關(guān)注

0文章

151瀏覽量

6520

原文標(biāo)題:谷歌Transformer大進(jìn)化,機(jī)翻最強(qiáng)王者上線

文章出處:【微信號(hào):Aiobservation,微信公眾號(hào):人工智能觀察】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

Transformer架構(gòu)中編碼器的工作流程

Transformer架構(gòu)概述

日立建機(jī)MES制造執(zhí)行系統(tǒng)正式上線

快手上線鴻蒙應(yīng)用高性能解決方案:數(shù)據(jù)反序列化性能提升90%

快手上線鴻蒙應(yīng)用高性能解決方案

集特17.3英寸上翻式加固工業(yè)便攜機(jī)GDC-7001

如何使用MATLAB構(gòu)建Transformer模型

transformer專用ASIC芯片Sohu說(shuō)明

AI眼鏡形態(tài)席卷可穿戴市場(chǎng)!谷歌眼鏡幾次“流產(chǎn)”,將靠AI翻盤

自動(dòng)駕駛中一直說(shuō)的BEV+Transformer到底是個(gè)啥?

谷歌Transformer大進(jìn)化 機(jī)翻最強(qiáng)王者上線

谷歌Transformer大進(jìn)化 機(jī)翻最強(qiáng)王者上線

評(píng)論