完善資料讓更多小伙伴認(rèn)識(shí)你,還能領(lǐng)取20積分哦,立即完善>

電子發(fā)燒友網(wǎng)技術(shù)文庫(kù)為您提供最新技術(shù)文章,最實(shí)用的電子技術(shù)文章,是您了解電子技術(shù)動(dòng)態(tài)的最佳平臺(tái)。

DXG 服務(wù)器配備 8 塊 H100 GPU,6400億個(gè)晶體管,在全新的 FP8 精度下 AI 性能比上一代高 6 倍,可提供 900GB/s 的帶寬。...

AI是計(jì)算機(jī)科學(xué)的分支領(lǐng)域,專注在創(chuàng)建擁有人類智能行為的系統(tǒng)或機(jī)器,其目標(biāo)為模擬人類的各種認(rèn)知功能,包含學(xué)習(xí)、推理、解決問(wèn)題、感知、語(yǔ)言理解等等。AI涵蓋了各種技術(shù)領(lǐng)域,如機(jī)器學(xué)習(xí)、深度學(xué)習(xí)、自然語(yǔ)言處理、計(jì)算機(jī)視覺(jué)、機(jī)器人等。...

在監(jiān)督式學(xué)習(xí)下,輸入數(shù)據(jù)被稱為“訓(xùn)練數(shù)據(jù)”,每組訓(xùn)練數(shù)據(jù)有一個(gè)明確的標(biāo)識(shí)或結(jié)果,如對(duì)防垃圾郵件系統(tǒng)中“垃圾郵件”“非垃圾郵件”,對(duì)手寫數(shù)字識(shí)別中的“1“,”2“,”3“,”4“等。...

從評(píng)測(cè)能力上來(lái)看,由于目前的評(píng)測(cè)數(shù)據(jù)集主要是利用人類試題及其標(biāo)準(zhǔn)答案進(jìn)行評(píng)測(cè),這種評(píng)價(jià)方式更偏向?qū)ν评砟芰Φ脑u(píng)估,存在評(píng)估結(jié)果和模型真實(shí)能力有?定偏差。...

作為通用序列模型的骨干,Mamba 在語(yǔ)言、音頻和基因組學(xué)等多種模態(tài)中都達(dá)到了 SOTA 性能。在語(yǔ)言建模方面,無(wú)論是預(yù)訓(xùn)練還是下游評(píng)估,他們的 Mamba-3B 模型都優(yōu)于同等規(guī)模的 Transformer 模型,并能與兩倍于其規(guī)模的 Transformer 模型相媲美。...

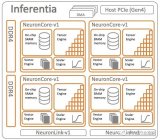

Trainium1 芯片于 2020 年 12 月發(fā)布,并以兩個(gè)不同的實(shí)例(Trn1 和 Trn1n)發(fā)貨。我們當(dāng)時(shí)對(duì) Trainium1 和2021 年 12 月的這些實(shí)例進(jìn)行了盡可能多的分析,坦率地說(shuō),AWS 沒(méi)有提供大量有關(guān)這些本土 AI 計(jì)算引擎的數(shù)據(jù)。...

作者對(duì)Transformer Block移除了各種參數(shù),減少了15%參數(shù)量,提高了15%的訓(xùn)練速度,各個(gè)環(huán)節(jié)都有做充分的實(shí)驗(yàn),但一些經(jīng)驗(yàn)性得到的結(jié)論也并沒(méi)有直接回答一些問(wèn)題(如LN為什么影響收斂速度)。...

本文對(duì)比了多種基線方法,包括無(wú)監(jiān)督域自適應(yīng)的傳統(tǒng)方法(如Pseudo-labeling和對(duì)抗訓(xùn)練)、基于檢索的LM方法(如REALM和RAG)和情境學(xué)習(xí)方法(如In-context learning)。...

以太網(wǎng)是一種廣泛使用的網(wǎng)絡(luò)協(xié)議,但其傳輸速率和延遲無(wú)法滿足大型模型訓(xùn)練的需求。相比之下,端到端IB(InfiniBand)網(wǎng)絡(luò)是一種高性能計(jì)算網(wǎng)絡(luò),能夠提供高達(dá) 400 Gbps 的傳輸速率和微秒級(jí)別的延遲,遠(yuǎn)高于以太網(wǎng)的性能。這使得IB網(wǎng)絡(luò)成為大型模型訓(xùn)練的首選網(wǎng)絡(luò)技術(shù)。...

在傳統(tǒng)“小”模型方法中,需要對(duì)訓(xùn)練數(shù)據(jù)進(jìn)行構(gòu)建,例如訓(xùn)練一個(gè)分類模型,以便將用戶的問(wèn)題分類為不同的意圖。同樣,回答用戶問(wèn)題的方式也需要模型的處理,因?yàn)槭酆髥?wèn)題的多樣性,有的需要直接回答,有的需要引導(dǎo)用戶執(zhí)行一系列步驟來(lái)解決。...

使用了LLaMA-13B來(lái)訓(xùn)練模型和獎(jiǎng)勵(lì)模型,使用BAD模型作為有害內(nèi)容檢測(cè)模型。...

Copilot 最初是由 GitHub/Microsoft 和 OpenAI 合作推出的開發(fā)項(xiàng)目,致力于輔助軟件開發(fā)人員編寫代碼,提供諸如將代碼注釋轉(zhuǎn)換為可運(yùn)行代碼、自動(dòng)完成代碼塊、代碼重復(fù)部分以及整個(gè)方法和/或函數(shù)等功能。...

我們使用LLAMA2-7B作為實(shí)驗(yàn)的基礎(chǔ)模型。我們主要評(píng)估將舊知識(shí)更新為新知識(shí)的能力,因此模型將首先在舊知識(shí)上進(jìn)行為期3個(gè)時(shí)期的微調(diào)。表1中F-Learning中設(shè)置的超參數(shù)λ分別取值為0.3、0.7、0.1和1.5。...

PanopticNeRF-360是PanopticNeRF的擴(kuò)展版本,借助3D粗標(biāo)注快速生成大量的新視點(diǎn)全景分割和RGB圖,并引入幾何-語(yǔ)義聯(lián)合優(yōu)化來(lái)解決交叉區(qū)域的類別模糊問(wèn)題,對(duì)于數(shù)據(jù)標(biāo)注領(lǐng)域有一定價(jià)值。...

在研究人員選擇的模型中,GPT-3 davinci(非指令微調(diào))、GPT-3 textdavinci-001(指令微調(diào))和GPT-3 textdavinci-003(InstructGPT)都是以前觀察到過(guò)涌現(xiàn)能力的模型。這一選擇主要是出于模型可用性的考慮。...

大模型當(dāng)前以生成類應(yīng)用為主,多模態(tài)是未來(lái)重點(diǎn)發(fā)展方向 企業(yè)用戶是從應(yīng)用視角出發(fā),分成生成類應(yīng)用、決策類應(yīng)用和多模態(tài)應(yīng)用。 受限于模型能力、應(yīng)用效果等因素,當(dāng)前階段以生成類應(yīng)用為主。...

未來(lái)全球服務(wù)器市場(chǎng)規(guī)模有望超萬(wàn)億。長(zhǎng)遠(yuǎn)來(lái)看,在國(guó)內(nèi)外數(shù)據(jù)流量迅速增長(zhǎng)以及公有云蓬勃發(fā)展的背景下,服務(wù)器作為云網(wǎng)體系中最重要的算力基礎(chǔ)設(shè)施,未來(lái)存在巨大的成長(zhǎng)空間,預(yù)計(jì)2027年市場(chǎng)規(guī)模將超萬(wàn)億元(1891.4億美元)。...

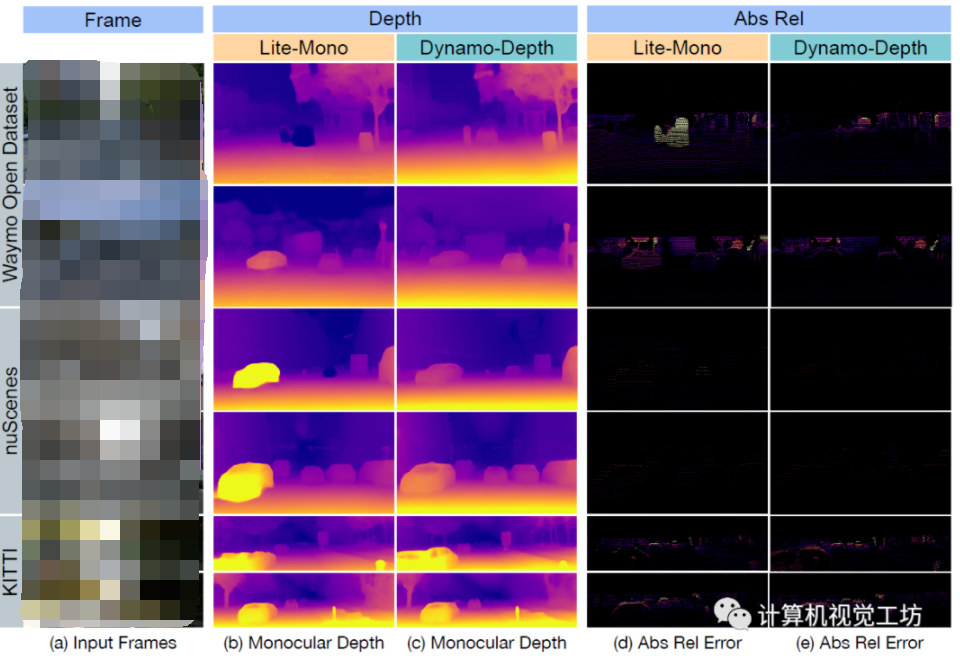

自監(jiān)督單目深度估計(jì)的訓(xùn)練可以在大量無(wú)標(biāo)簽視頻序列來(lái)進(jìn)行,訓(xùn)練集獲取很方便。但問(wèn)題是,實(shí)際采集的視頻序列往往會(huì)有很多動(dòng)態(tài)物體,而自監(jiān)督訓(xùn)練本身就是基于靜態(tài)環(huán)境假設(shè),動(dòng)態(tài)環(huán)境下會(huì)失效。...

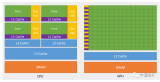

AI服務(wù)器按芯片類型可分為CPU+GPU、CPU+FPGA、CPU+ASIC等組合形式,CPU+GPU是目前國(guó)內(nèi)的主要選擇(占比91.9%);AI服務(wù)器的成本主要來(lái)自CPU、GPU等芯片,占比25%-70%不等,對(duì)于訓(xùn)練型服務(wù)器其80%以上的成本來(lái)源于CPU和GPU。...