摘要

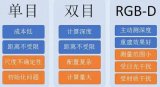

最近,神經(jīng)隱含表征在各個領(lǐng)域顯示出令人鼓舞的結(jié)果,包括在同步定位和映射(SLAM)方面取得的可喜進展。然而,現(xiàn)有的方法產(chǎn)生了過度平滑的場景重建,并且難以擴展到大場景。這些限制主要是由于其簡單的全連接網(wǎng)絡(luò)結(jié)構(gòu),沒有將局部信息納入觀察范圍。

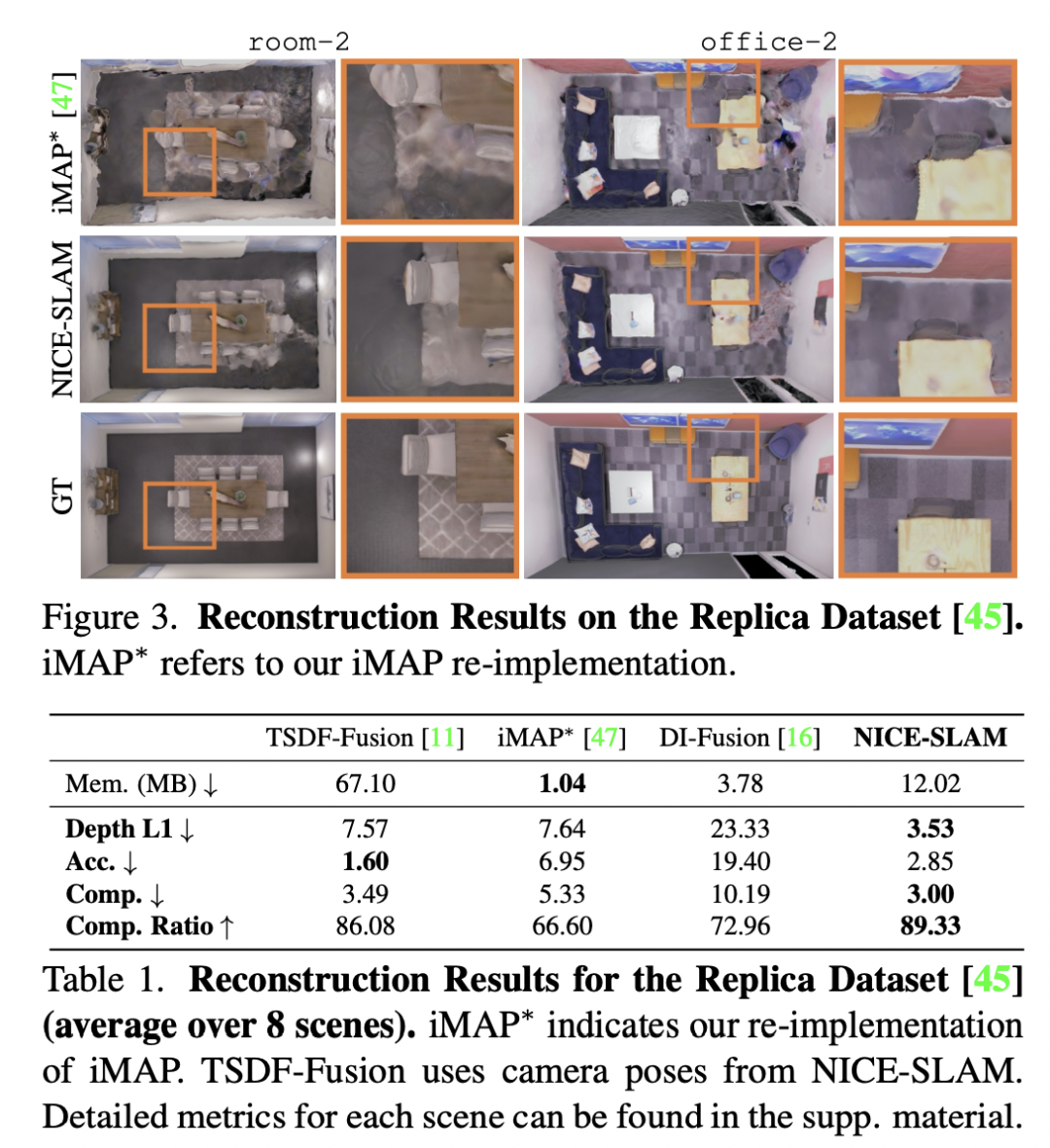

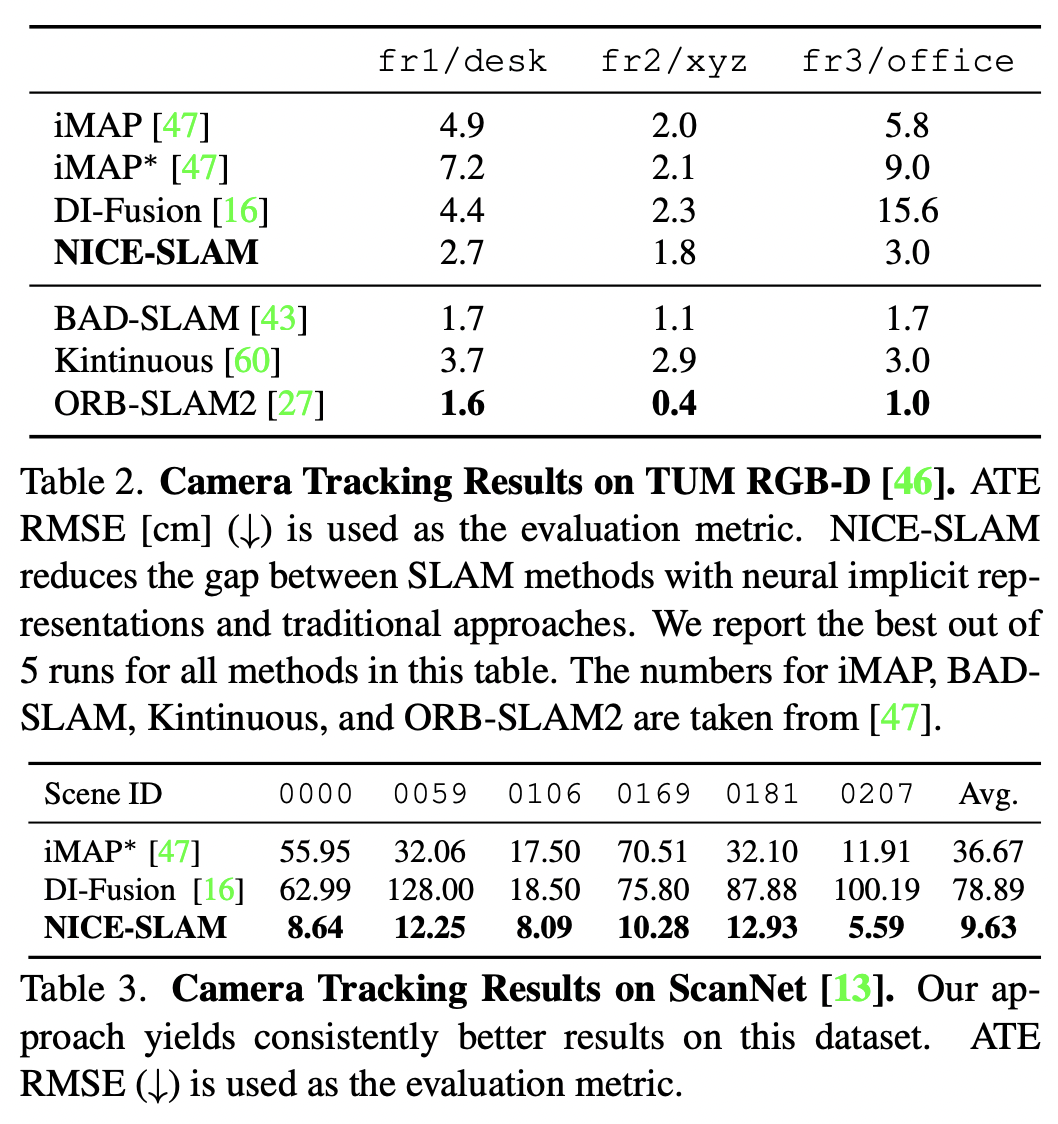

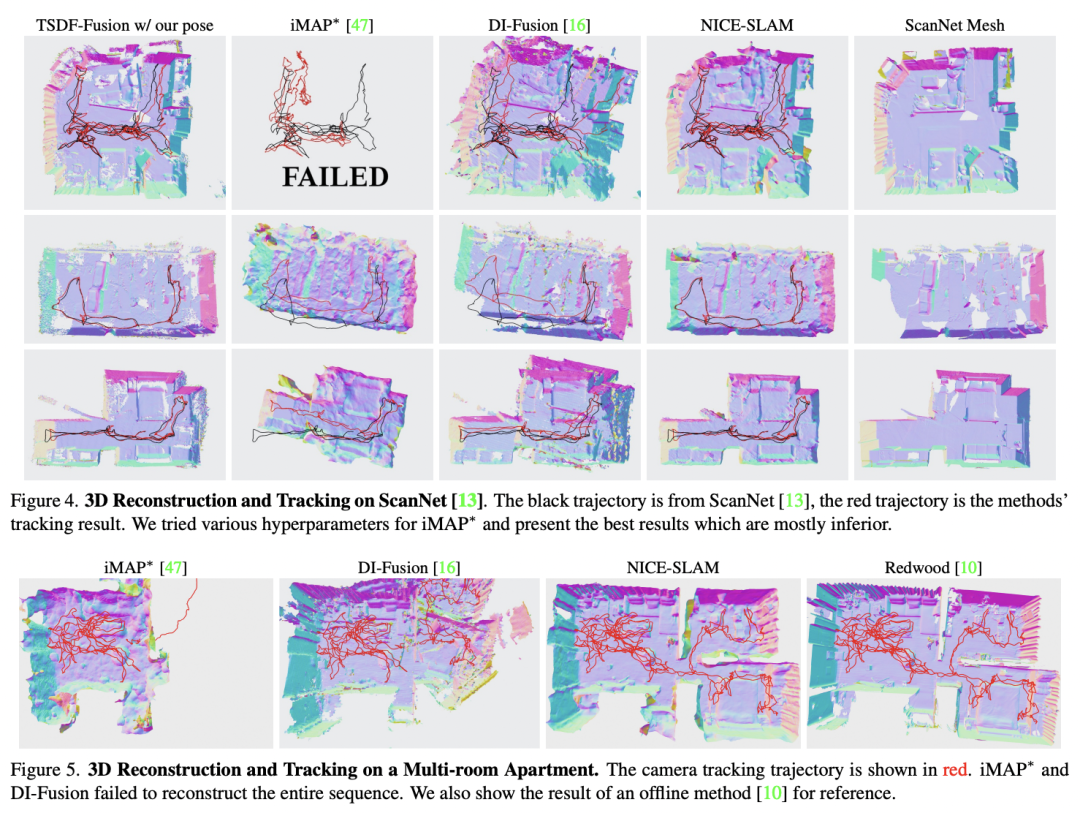

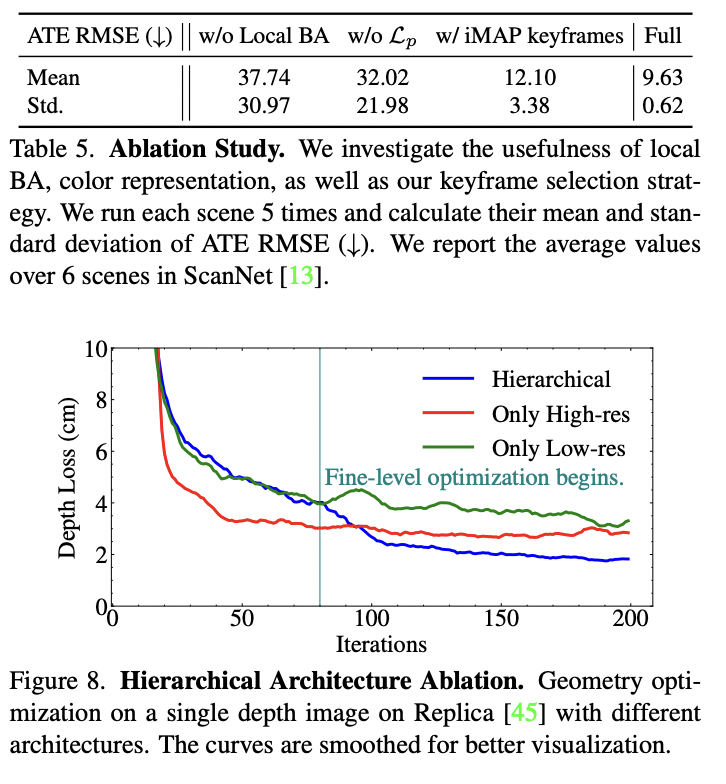

在本文中,我們提出了NICE-SLAM,這是一個密集的SLAM系統(tǒng),通過引入分層的場景表示,納入了多層次的本地信息。用預(yù)先訓(xùn)練好的幾何先驗來優(yōu)化這個表示,可以在大的室內(nèi)場景中進行詳細的重建。與最近的神經(jīng)隱含SLAM系統(tǒng)相比,我們的方法更具可擴展性、效率和魯棒性。在五個具有挑戰(zhàn)性的數(shù)據(jù)集上進行的實驗表明,NICE-SLAM在映射和跟蹤質(zhì)量方面都具有競爭力。

主要貢獻

我們提出了NICE-SLAM,一個密集的RGB-DSLAM系統(tǒng),它具有實時性、可擴展性、預(yù)測性和對各種挑戰(zhàn)性場景的魯棒性。

NICE-SLAM的核心是一個分層的、基于網(wǎng)格的神經(jīng)隱式編碼。與全局神經(jīng)場景編碼相比,這種表示法允許局部更新,這是大規(guī)模方法的一個先決條件。

我們在各種數(shù)據(jù)集上進行了廣泛的評估,證明了在映射和跟蹤方面具有競爭力的性能。

主要方法

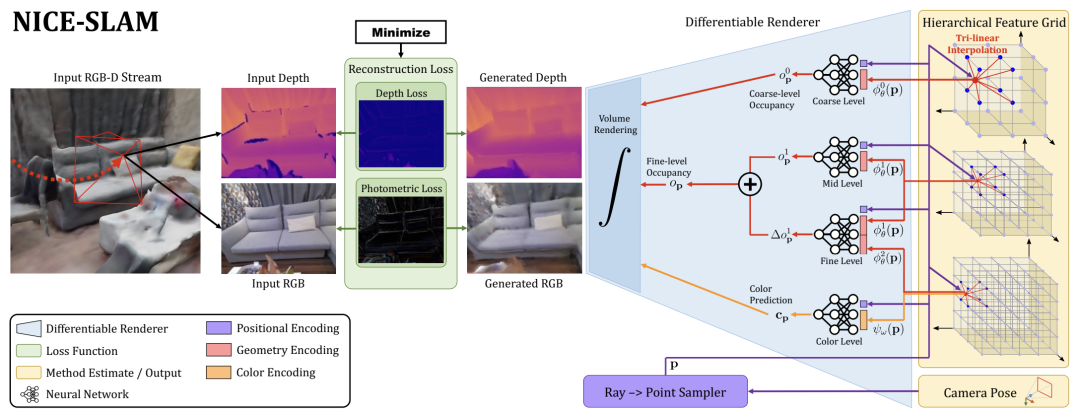

我們的方法將RGB-D圖像流作為輸入,并以分層特征網(wǎng)格的形式輸出攝像機的姿勢和學(xué)習(xí)到的場景表示。從右到左,我們的管道可以被解釋為一個生成模型,它根據(jù)給定的場景表示和攝像機姿勢渲染深度和顏色圖像。在測試時,我們通過逆向傳播圖像和深度重建損失來解決逆向問題,并通過可區(qū)分的渲染器(從左到右)來估計場景表現(xiàn)和攝像機的姿勢。

這兩個實體都是在交替優(yōu)化中估計的。映射:逆?zhèn)鞑ブ桓聦哟位膱鼍氨硎尽8櫍耗鎮(zhèn)鞑ブ桓聰z像機的姿態(tài)。為了提高可讀性,我們將用于幾何編碼的細尺度網(wǎng)格與同等大小的顏色網(wǎng)格結(jié)合起來,并將它們顯示為具有兩個屬性(紅色和橙色)的一個網(wǎng)格。

1. 層次化的場景表示

現(xiàn)在我們介紹一下我們的分層場景表示,它結(jié)合了多級網(wǎng)格特征和預(yù)訓(xùn)練的解碼器,用于占用率預(yù)測。幾何圖形被編碼成三個特征網(wǎng)格j l θ和它們相應(yīng)的MLP解碼器f l,其中l(wèi)∈{0,1,2}是指粗、中、細三級場景細節(jié)。此外,我們還有一個單一的特征網(wǎng)格ψω和解碼器gω來模擬場景外觀。這里θ和ω表示幾何和顏色的可優(yōu)化參數(shù),即網(wǎng)格中的特征和顏色解碼器中的權(quán)重。

2. 深度和色彩渲染

給定相機的固有參數(shù)和當(dāng)前相機的姿勢,我們可以計算出一個像素坐標(biāo)的觀察方向r。我們首先沿著這條射線對Nstrat點進行分層采樣,同時對靠近深度的Nimp點進行均勻采樣1。

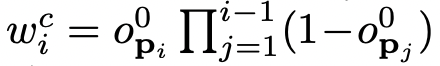

我們對每條射線總共取樣N=Nstrat+Nimp點。更正式地說,讓pi = o + dir, i∈ {1, - -, N}表示給定攝像機原點o的射線r上的采樣點,di對應(yīng)于pi沿該射線的深度值。對于每一個點pi,我們可以計算出它們的粗粒度占用概率o0 pi,細粒度占用概率opi,和顏色值cpi。

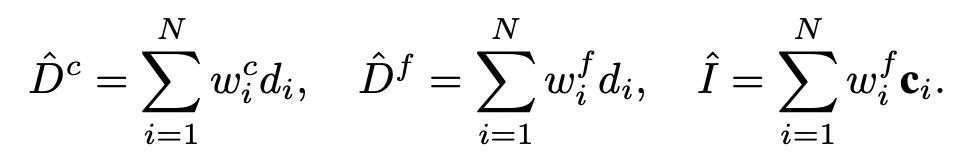

最后,對于每條射線,在粗略和精細層面的深度,以及顏色可以被呈現(xiàn)為:

3. 建圖和跟蹤

建圖。

為了優(yōu)化上文提到的場景表示,我們從當(dāng)前幀和選定的關(guān)鍵幀中均勻地取樣共M個像素。接下來,我們以分階段的方式進行優(yōu)化,以最小化幾何和光度損失。

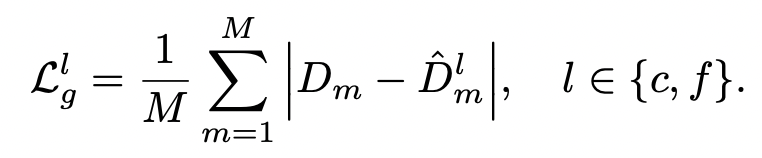

幾何損失僅僅是觀測值和預(yù)測深度之間的L1損失,在粗略的或精細的水平上為:

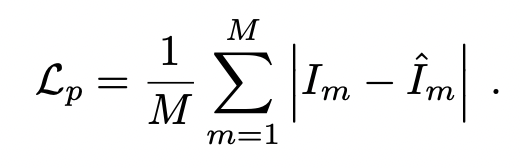

光度損失為:

相機跟蹤。

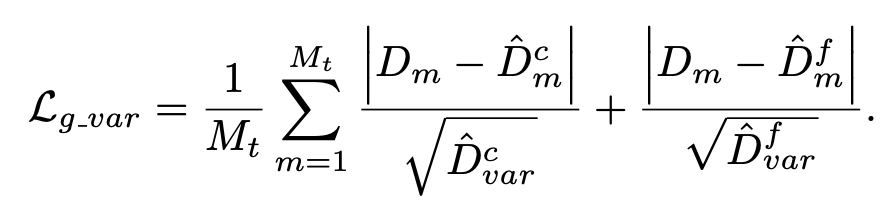

除了優(yōu)化場景表示外,我們還平行運行攝像機跟蹤,以優(yōu)化當(dāng)前幀的攝像機姿勢,即旋轉(zhuǎn)和平移{R,t}。為此,我們對當(dāng)前幀中的Mt像素進行采樣,并應(yīng)用上面相同的光度損失,但使用一個修改過的幾何損失:

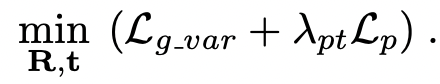

修改后的損失在重建的幾何形狀中減少了某些區(qū)域的權(quán)重,例如物體的邊緣。攝像機跟蹤最終被表述為以下最小化問題:

4. 關(guān)鍵幀的選擇 與其他SLAM系統(tǒng)類似

我們用一組選定的關(guān)鍵幀不斷優(yōu)化我們的分層場景表示。我們按照iMAP的方法維護一個全局關(guān)鍵幀列表,我們根據(jù)信息增益逐步添加新的關(guān)鍵幀。然而,與iMAP相比,我們在優(yōu)化場景幾何時只包括與當(dāng)前幀有視覺重疊的關(guān)鍵幀。這是可能的,因為我們能夠?qū)ξ覀兊幕诰W(wǎng)格的表示進行局部更新,而且我們不會像iMap那樣存在關(guān)鍵幀消失的問題。

這種關(guān)鍵幀選擇策略不僅確保了當(dāng)前視圖之外的幾何形狀保持靜態(tài),而且還導(dǎo)致了一個非常有效的優(yōu)化問題,因為我們每次只優(yōu)化必要的參數(shù)。在實踐中,我們首先隨機地對像素進行采樣,并使用優(yōu)化后的相機姿勢對相應(yīng)的深度進行反投影。

然后,我們將點云投影到全局關(guān)鍵幀列表中的每個關(guān)鍵幀。從這些有點投射到的關(guān)鍵幀中,我們隨機選擇K-2幀。此外,我們還將最近的關(guān)鍵幀和當(dāng)前的幀包括在場景表示優(yōu)化中,形成總共K個活動幀。

主要結(jié)果

審核編輯:劉清

-

解碼器

+關(guān)注

關(guān)注

9文章

1164瀏覽量

41726 -

RGB

+關(guān)注

關(guān)注

4文章

804瀏覽量

59642 -

SLAM

+關(guān)注

關(guān)注

24文章

436瀏覽量

32349 -

MLP

+關(guān)注

關(guān)注

0文章

57瀏覽量

4504

原文標(biāo)題:NICE-SLAM:用于SLAM的神經(jīng)隱含可擴展編碼(CVPR 2022)

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

SLAM技術(shù)的應(yīng)用及發(fā)展現(xiàn)狀

讓機器人完美建圖的SLAM 3.0到底是何方神圣?

【案例分享】基于BP算法的前饋神經(jīng)網(wǎng)絡(luò)

SLAM技術(shù)目前主要應(yīng)用在哪些領(lǐng)域

激光SLAM與視覺SLAM有什么區(qū)別?

基于視覺的slam自動駕駛

單目視覺SLAM仿真系統(tǒng)的設(shè)計與實現(xiàn)

可擴展應(yīng)用與可擴展系統(tǒng)

谷歌全新操作系統(tǒng)Android Q Beta 1發(fā)布 可擴展神經(jīng)網(wǎng)絡(luò)API

用于神經(jīng)場SLAM的矢量化對象建圖

視覺SLAM是什么?視覺SLAM的工作原理 視覺SLAM框架解讀

NeRF何去何從?GS SLAM到底哪家強?來看看最新的開源方案!

用于SLAM的神經(jīng)隱含可擴展編碼

用于SLAM的神經(jīng)隱含可擴展編碼

評論