電子發燒友網報道(文/周凱揚)隨著LLM與生成式AI熱度不減,不少AI芯片初創公司都找到了新的發力點,紛紛調整設計思路,專為這一爆款應用開發出了新款芯片。且不說這些芯片的實際性能如何,但這無疑是當下推動這些公司獲得投資,并在行業下行期存活下去的救命稻草。今天我們就來聊聊剛發布新品SN40L的AI芯片初創公司SambaNova。

SN40L背后的SambaNova

SambaNova成立于2017年,截至目前已經歷了共計6輪融資,參與融資的公司包括谷歌、英特爾和軟銀等,融資總額高達11億美元。只不過最近的D輪融資,距今已經有兩年多的時間,也難怪SambaNova急于推出SN40L這一芯片,畢竟此類初創公司的開發從來都是燒錢的。

其實在SN40L推出以前,SambaNova也并非默默無聞,比如美國阿貢國家實驗室早在第一代產品SN10推出時就在使用和測試SambaNova的系統了,只不過屆時基于SN10的SambaNova Dataflow系統還只是用于消除數據噪聲而已。

如果我們現在看阿貢國家實驗室的ALCF AI測試平臺,我們可以看到5大系統,分別是Cerebras的CS2、SambaNova的Dataflow、Graphcore的Bow Pod64、Grop系統以及Habana的Gaudi。而目前用于ALCF AI測試平臺的SambaNova Dataflow就是基于SN40L的上一代產品SN30 RDU打造的,該芯片基于臺積電的7nm工藝打造。

目前SN30用在阿貢國家實驗室的這套系統主要用于一些科學研究領域的AI計算,比如中微子物理、癌癥預測、氣候建模以及下一代汽車引擎研發等。而我們真正關注的是剛發布的SN40L,以及它在LLM這一應用上能提供何種不同的優勢。

英偉達GPU的替代方案

目前LLM的主流方案,即英偉達的A100、H100 GPU,存在一個很大的問題,那就是缺貨。對于任何互聯網廠商來說,在市面上找到足夠多的GPU都是一件費錢費力的事。而對于云服務廠商來說也是如此,他們也要考慮出租這類服務器時,GPU的算力與容量分配問題。

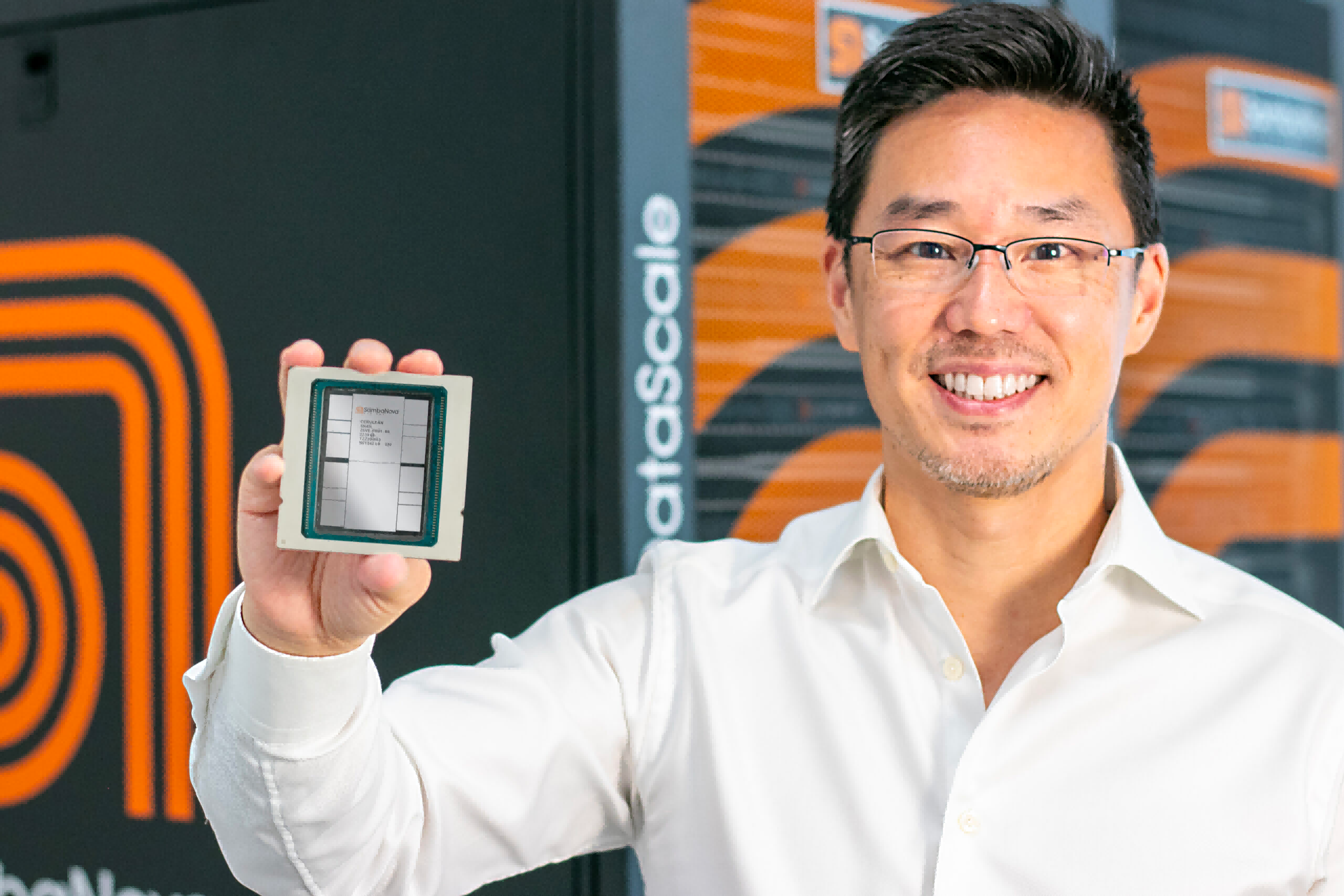

SN40L芯片和CEO Rodrigo Liang / SambaNova

為了解決“數量”的問題,SambaNova推出了SN40L。相較上一代的SN30,該芯片基于臺積電5nm工藝打造,每個芯片集成了1020億個晶體管和1040個核,算力高達638TFlops。更夸張的是,SambaNova稱單個SN40L系統節點(8塊SN40L芯片)就能支持到最高5萬億參數的大模型。

與其他AI芯片初創公司不一樣的是,他們并沒有選擇直接將芯片賣給其他公司這條路線,而是選擇了售賣訪問其定制AI技術棧的訪問權,包括其自研硬件和運行超大模型的軟件等。這種商業模式或許能吸引一部分互聯網公司,但在云服務廠商眼中,他們應該不會覺得這是一套可盈利的方案。

此外,SambaNova與其他競爭對手一樣,在AI芯片上引入了64GB HBM用于解決內存墻的問題,這也是SN40L與上一代芯片的差異之一。只不過SambaNova并沒有透露SN40L用的是何種HBM,以及帶寬性能如何。

寫在最后

雖然SambaNova展示了提高LLM擴展性的另一條道路,但在沒有經過實際驗證之前,市場還是會對其持觀望態度。此前也有不少AI芯片公司發表過同樣大膽的聲明,但事實證明這類芯片只適合用于運行那些預訓練完成的模型,而訓練過程仍需要靠GPU來完成。所以哪怕SambaNova的CEO Rodrigo Liang強調SN40L的訓練性能足夠優秀,但是否能在這套商業模式下闖出一片天,就得交由市場去驗證了。

-

gpu

+關注

關注

28文章

4937瀏覽量

131117 -

SambaNova

+關注

關注

0文章

7瀏覽量

299 -

SN40L

+關注

關注

0文章

2瀏覽量

88

發布評論請先 登錄

AI大模型不再依賴英偉達GPU?蘋果揭秘自研大模型

大模型推理顯存和計算量估計方法研究

為什么無法在GPU上使用INT8 和 INT4量化模型獲得輸出?

【「算力芯片 | 高性能 CPU/GPU/NPU 微架構分析」閱讀體驗】+NVlink技術從應用到原理

請問如何在imx8mplus上部署和運行YOLOv5訓練的模型?

無法在GPU上運行ONNX模型的Benchmark_app怎么解決?

GPU是如何訓練AI大模型的

PyTorch GPU 加速訓練模型方法

【一文看懂】大白話解釋“GPU與GPU算力”

當前主流的大模型對于底層推理芯片提出了哪些挑戰

英偉達Blackwell可支持10萬億參數模型AI訓練,實時大語言模型推理

英偉達震撼發布:全新AI模型參數規模躍升至80億量級

不再焦慮GPU供應,8芯片挑戰5萬億參數大模型

不再焦慮GPU供應,8芯片挑戰5萬億參數大模型

評論