完善資料讓更多小伙伴認(rèn)識(shí)你,還能領(lǐng)取20積分哦,立即完善>

標(biāo)簽 > llm

在人工智能領(lǐng)域,LLM代表“大型語(yǔ)言模型”。在人工智能(AI)領(lǐng)域自然語(yǔ)言處理(NLP)是一個(gè)快速進(jìn)展的領(lǐng)域。NLP中最重要是大語(yǔ)言模型(LLM)。大語(yǔ)言模型(英文:Large Language Model,縮寫(xiě)LLM),也稱(chēng)大型語(yǔ)言模型,是一種基于機(jī)器學(xué)習(xí)和自然語(yǔ)言處理技術(shù)的模型。

文章:314個(gè) 瀏覽:624次 帖子:3個(gè)

采用ChatGPT的企業(yè)可能會(huì)擔(dān)心API調(diào)用的巨大成本、服務(wù)中斷、數(shù)據(jù)所有權(quán)和隱私問(wèn)題,以及其他不可預(yù)測(cè)的事件,如最近關(guān)于董事會(huì)解雇CEO Sam Al...

本實(shí)驗(yàn)旨在驗(yàn)證LLM在模擬復(fù)雜歷史事件方面的有效性。實(shí)驗(yàn)選用了OpenAI開(kāi)發(fā)的GPT-4作為后端模型,討論以下問(wèn)題。

大模型對(duì)話(huà)系統(tǒng)的內(nèi)功與外功

Zero-shot Setting:在 O-Cue 中,由于單步指令較復(fù)雜(不要要進(jìn)行推理還要進(jìn)行回復(fù)生成,以及生成的格式要求),單步生成內(nèi)容過(guò)多,導(dǎo)致...

2023-12-01 標(biāo)簽:數(shù)據(jù)集大模型LLM 729 0

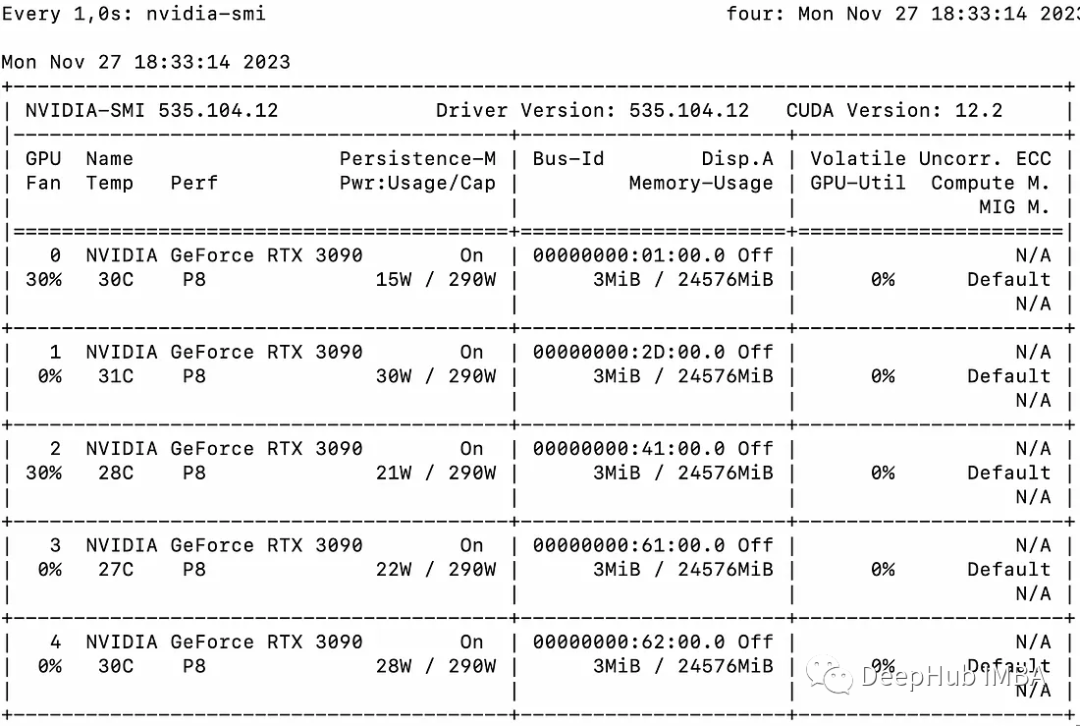

怎樣使用Accelerate庫(kù)在多GPU上進(jìn)行LLM推理呢?

大型語(yǔ)言模型(llm)已經(jīng)徹底改變了自然語(yǔ)言處理領(lǐng)域。隨著這些模型在規(guī)模和復(fù)雜性上的增長(zhǎng),推理的計(jì)算需求也顯著增加。

2023-12-01 標(biāo)簽:GPU芯片自然語(yǔ)言處理LLM 1816 0

隨著ChatGPT的快速發(fā)展,基于Transformer的大型語(yǔ)言模型(LLM)為人工通用智能(AGI)鋪平了一條革命性的道路,并已應(yīng)用于知識(shí)庫(kù)、人機(jī)界...

2023-11-27 標(biāo)簽:模型深度學(xué)習(xí)ChatGPT 3271 0

為什么Agent落地這么難?AI最大賽道Agent機(jī)遇全解析

“如果一篇論文提出了某種不同的訓(xùn)練方法,OpenAI內(nèi)部會(huì)嗤之以鼻,認(rèn)為都是我們玩剩下的。但是當(dāng)新的AI Agent論文出來(lái)時(shí),我們會(huì)十分認(rèn)真且興奮地討...

本文假設(shè)不同的ICL為L(zhǎng)LM提供了關(guān)于任務(wù)的不同知識(shí),導(dǎo)致對(duì)相同數(shù)據(jù)的不同理解和預(yù)測(cè)。因此,一個(gè)直接的研究問(wèn)題出現(xiàn)了:llm能否用多個(gè)ICL提示輸入來(lái)增...

2023-11-24 標(biāo)簽:轉(zhuǎn)換器Sample自然語(yǔ)言 1859 0

在 LLaMA, BERT 以及 ViTs 模型上,4-bit 量化皆取得了遠(yuǎn)超 SOTA 的結(jié)果。特別是,這篇文章展示了 4-bit 量化的 LLaM...

2023-11-24 標(biāo)簽:浮點(diǎn)數(shù)大模型LLM 1116 0

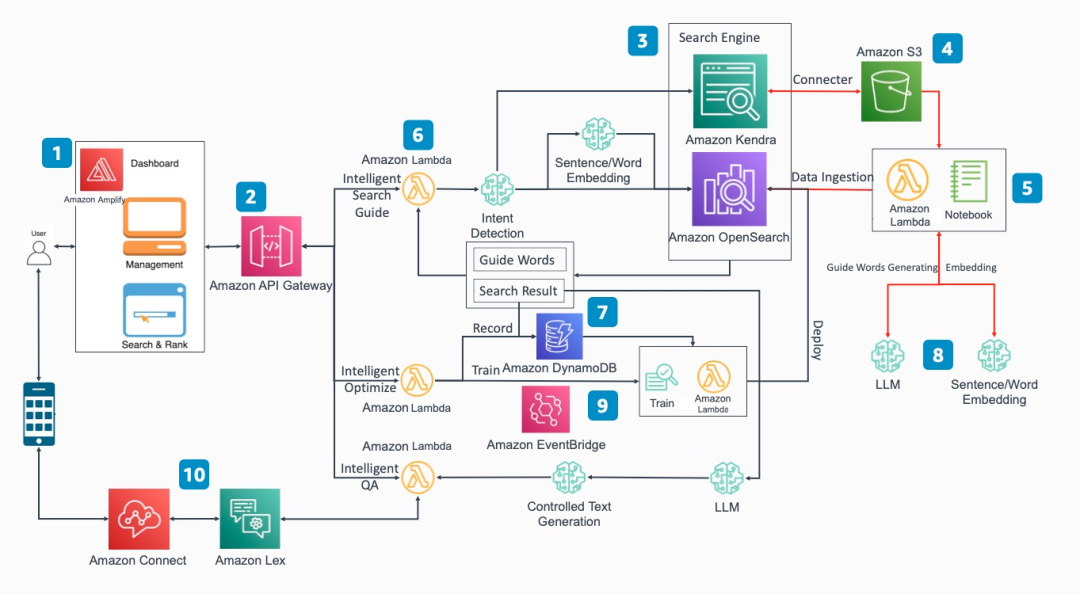

如何基于亞馬遜云科技LLM相關(guān)工具打造知識(shí)庫(kù)

背景 本篇將為大家闡述亞馬遜云科技大語(yǔ)言模型下沉到具體行業(yè)進(jìn)行場(chǎng)景以及實(shí)施案例的介紹,是亞馬遜云科技官方《基于智能搜索和大模型打造企業(yè)下一代知識(shí)庫(kù)》系列...

LLM的發(fā)展為情感分析任務(wù)帶來(lái)的新的解決方案。有研究人員使用LLM,在上下文學(xué)習(xí)(in-context learning, ICL)的范式下,僅使用少量...

2023-11-23 標(biāo)簽:生成器自然語(yǔ)言處理半監(jiān)督學(xué)習(xí) 1115 0

幻覺(jué)被描述為無(wú)意義或不忠實(shí)于所提供源內(nèi)容的生成內(nèi)容。根據(jù)與源內(nèi)容的矛盾,這些幻覺(jué)又進(jìn)一步分為內(nèi)在幻覺(jué)和外在幻覺(jué)。在LLMs中,幻覺(jué)的范圍包含了一個(gè)更廣泛...

基于大語(yǔ)言模型的共情回復(fù)生成:實(shí)證研究和改進(jìn)

對(duì)以ChatGPT為代表的LLMs在共情回復(fù)生成上的表現(xiàn)進(jìn)行了全面的實(shí)證研究,LLMs在現(xiàn)有的基準(zhǔn)數(shù)據(jù)集上,對(duì)比以往的SOTA模型,表現(xiàn)極其優(yōu)越。

基于顯式證據(jù)推理的few-shot關(guān)系抽取CoT

最近,上下文學(xué)習(xí)策略已被證明在沒(méi)有訓(xùn)練的情況下顯示出顯著的結(jié)果。很少有研究利用上下文學(xué)習(xí)進(jìn)行zero-shot信息提取。不幸的是,推理的證據(jù)在思維鏈提示...

運(yùn)行 安裝上面的步驟,到這里就全部安裝好了,體驗(yàn)LLM有兩種方式,一個(gè)是直接在shell窗口中以聊天的方式使用,還有一個(gè)是通過(guò)topic的訂閱和發(fā)布來(lái)使...

2023-11-20 標(biāo)簽:數(shù)據(jù)LLM大語(yǔ)言模型 993 0

對(duì)LLM的理解比較有限,從代碼實(shí)現(xiàn)的角度來(lái)說(shuō),RWKV的狀態(tài)和KV Cache不同,不依賴(lài)序列長(zhǎng)度,這讓RWKV模型在各種長(zhǎng)度下運(yùn)行內(nèi)存和運(yùn)行速度都是趨...

LLM推理上的DeepSpeed Inference優(yōu)化實(shí)踐方案

首先將 batch 拆分為 micro-batch,其中 micro-batch 數(shù)等于 pipeline 深度,micro-batch通過(guò)動(dòng)態(tài)隊(duì)列的順...

怎樣讓PPO訓(xùn)練更穩(wěn)定?早期人類(lèi)征服RLHF的馴化經(jīng)驗(yàn)

盡管魯迅先生曾言:真的強(qiáng)化敢于直面慘淡的結(jié)果,敢于正視崩壞的曲線(xiàn)。但日復(fù)一復(fù)地開(kāi)盲盒難免會(huì)讓人心臟承受不了,好在前人們留下了寶貴的馴化經(jīng)驗(yàn),今天讓我們一...

換一批

換一批

編輯推薦廠(chǎng)商產(chǎn)品技術(shù)軟件/工具OS/語(yǔ)言教程專(zhuān)題

| 電機(jī)控制 | DSP | 氮化鎵 | 功率放大器 | ChatGPT | 自動(dòng)駕駛 | TI | 瑞薩電子 |

| BLDC | PLC | 碳化硅 | 二極管 | OpenAI | 元宇宙 | 安森美 | ADI |

| 無(wú)刷電機(jī) | FOC | IGBT | 逆變器 | 文心一言 | 5G | 英飛凌 | 羅姆 |

| 直流電機(jī) | PID | MOSFET | 傳感器 | 人工智能 | 物聯(lián)網(wǎng) | NXP | 賽靈思 |

| 步進(jìn)電機(jī) | SPWM | 充電樁 | IPM | 機(jī)器視覺(jué) | 無(wú)人機(jī) | 三菱電機(jī) | ST |

| 伺服電機(jī) | SVPWM | 光伏發(fā)電 | UPS | AR | 智能電網(wǎng) | 國(guó)民技術(shù) | Microchip |

| Arduino | BeagleBone | 樹(shù)莓派 | STM32 | MSP430 | EFM32 | ARM mbed | EDA |

| 示波器 | LPC | imx8 | PSoC | Altium Designer | Allegro | Mentor | Pads |

| OrCAD | Cadence | AutoCAD | 華秋DFM | Keil | MATLAB | MPLAB | Quartus |

| C++ | Java | Python | JavaScript | node.js | RISC-V | verilog | Tensorflow |

| Android | iOS | linux | RTOS | FreeRTOS | LiteOS | RT-THread | uCOS |

| DuerOS | Brillo | Windows11 | HarmonyOS |