完善資料讓更多小伙伴認(rèn)識你,還能領(lǐng)取20積分哦,立即完善>

標(biāo)簽 > transformer

文章:139個 瀏覽:6397次 帖子:3個

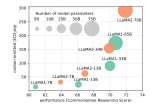

探索高效的大型語言模型!大型語言模型的高效學(xué)習(xí)方法

在大型語言模型(LLMs)的應(yīng)用中,提示工程(Prompt Engineering)是一種關(guān)鍵技術(shù),用于引導(dǎo)模型生成特定輸出或執(zhí)行特定任務(wù)。通過精心設(shè)計...

2023-12-13 標(biāo)簽:cpuGPTTransformer 946 0

Transformer迎來強(qiáng)勁競爭者 新架構(gòu)Mamba引爆AI圈!

作為通用序列模型的骨干,Mamba 在語言、音頻和基因組學(xué)等多種模態(tài)中都達(dá)到了 SOTA 性能。在語言建模方面,無論是預(yù)訓(xùn)練還是下游評估,他們的 Mam...

2023-12-07 標(biāo)簽:神經(jīng)網(wǎng)絡(luò)AI機(jī)器學(xué)習(xí) 623 0

更深層的理解視覺Transformer, 對視覺Transformer的剖析

最后是在ADE20K val上的LeaderBoard,通過榜單也可以看出,在榜單的前幾名中,Transformer結(jié)構(gòu)依舊占據(jù)是當(dāng)前的主力軍。

2023-12-07 標(biāo)簽:算法計算機(jī)視覺Transformer 1100 0

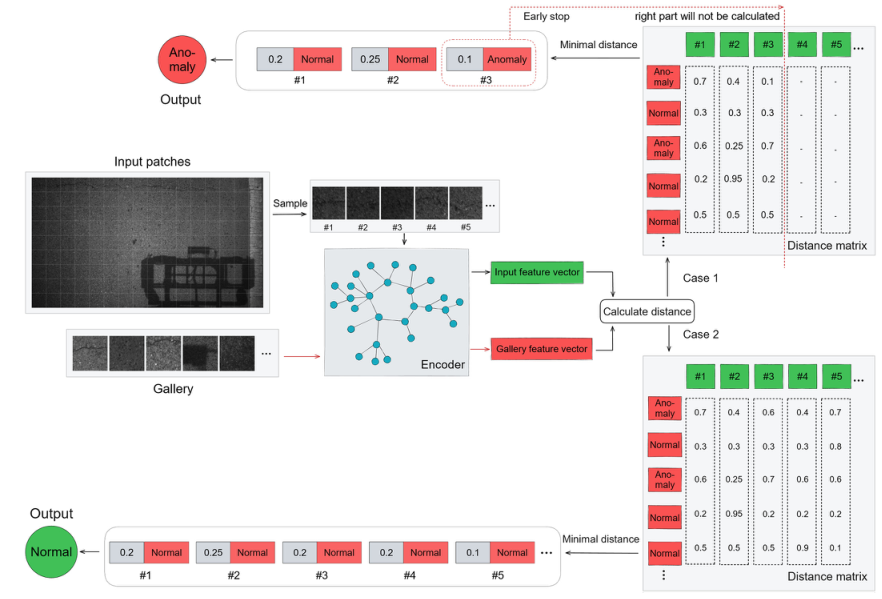

基于transformer和自監(jiān)督學(xué)習(xí)的路面異常檢測方法分享

鋪設(shè)異常檢測可以幫助減少數(shù)據(jù)存儲、傳輸、標(biāo)記和處理的壓力。本論文描述了一種基于Transformer和自監(jiān)督學(xué)習(xí)的新方法,有助于定位異常區(qū)域。

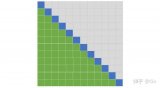

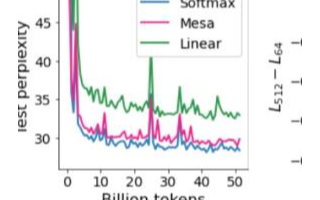

降低Transformer復(fù)雜度O(N^2)的方法匯總

首先來詳細(xì)說明為什么Transformer的計算復(fù)雜度是 。將Transformer中標(biāo)準(zhǔn)的Attention稱為Softmax Attention。令...

2023-12-04 標(biāo)簽:矩陣線性Transformer 1588 0

RoBERTa 架構(gòu)的 BigBird 模型現(xiàn)已集成入 transformers 中。本文的目的是讓讀者 深入 了解 BigBird 的實現(xiàn),并讓讀者能...

2023-11-29 標(biāo)簽:gpu算法Transformer 832 0

基于Transformer的可泛化人體表征設(shè)計方案

本文在ZJU-MoCap和H36M上進(jìn)行了泛化性實驗,結(jié)果如下圖所示。主要分為四個setting: Pose的泛化,Identity的泛化,只給一張參考...

2023-11-23 標(biāo)簽:Transformer 655 0

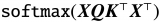

關(guān)于深度學(xué)習(xí)模型Transformer模型的具體實現(xiàn)方案

Transformer 本質(zhì)上是一個 Encoder-Decoder 架構(gòu)。因此中間部分的 Transformer 可以分為兩個部分:編碼組件和解碼組件。

2023-11-17 標(biāo)簽:解碼器編碼器深度學(xué)習(xí) 702 0

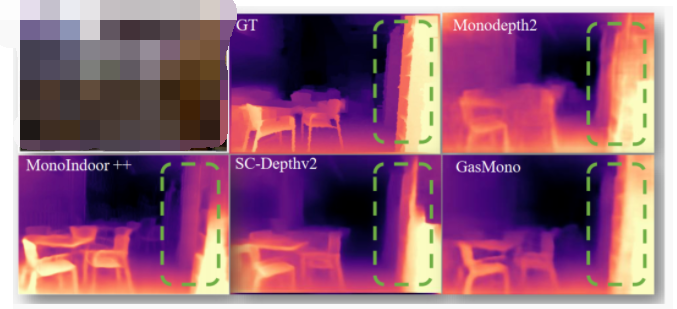

本文方法是一種自監(jiān)督的單目深度估計框架,名為GasMono,專門設(shè)計用于室內(nèi)場景。本方法通過應(yīng)用多視圖幾何的方式解決了室內(nèi)場景中幀間大旋轉(zhuǎn)和低紋理導(dǎo)致自...

2023-11-06 標(biāo)簽:RGB深度學(xué)習(xí)cnn 664 0

利用Transformer BEV解決自動駕駛Corner Case的技術(shù)原理

BEV是一種將三維環(huán)境信息投影到二維平面的方法,以俯視視角展示環(huán)境中的物體和地形。在自動駕駛領(lǐng)域,BEV 可以幫助系統(tǒng)更好地理解周圍環(huán)境,提高感知和決策...

SK hynix的“內(nèi)存中心計算”系統(tǒng)介紹

SK hynix面臨的問題是這樣的:生成式人工智能推理的成本非常高昂,不僅僅涉及到人工智能計算,還包括功耗、互聯(lián)和內(nèi)存,這些因素也在很大程度上推動了成本的增加。

為什么transformer性能這么好?Transformer的上下文學(xué)習(xí)能力是哪來的?

為什么 transformer 性能這么好?它給眾多大語言模型帶來的上下文學(xué)習(xí) (In-Context Learning) 能力是從何而來?在人工智能領(lǐng)...

2023-09-25 標(biāo)簽:人工智能深度學(xué)習(xí)DeepMind 1615 0

基于Transformer和深度證據(jù)學(xué)習(xí)的立體匹配框架

作者在各種數(shù)據(jù)集上評估了所提出的ELFNet,包括Scene Flow ,KITTI 2012和KITTI 2015 和Middlebury 2014 ...

2023-09-18 標(biāo)簽:神經(jīng)網(wǎng)絡(luò)深度學(xué)習(xí)Transformer 601 0

最近,馬毅教授團(tuán)隊探索了基于Transformer架構(gòu)的模型中涌現(xiàn)分割能力是否僅僅是復(fù)雜的自監(jiān)督學(xué)習(xí)機(jī)制的結(jié)果,或者是否可以通過模型架構(gòu)的適當(dāng)設(shè)計在更通...

2023-09-14 標(biāo)簽:模型深度學(xué)習(xí)Transformer 722 0

大模型基礎(chǔ)Transformer結(jié)構(gòu)的原理解析

該研究的結(jié)果適用于一般數(shù)據(jù)集,可以擴(kuò)展到交叉注意力層,并且研究結(jié)論的實際有效性已經(jīng)通過徹底的數(shù)值實驗得到了驗證。該研究建立一種新的研究視角,將多層 tr...

2023-09-07 標(biāo)簽:AI向量機(jī)Transformer 1469 0

這些embedding可以使用谷歌Word2vec (單詞的矢量表示) 找到。在我們的數(shù)值示例中,我們將假設(shè)每個單詞的embedding向量填充有 (0...

2023-09-06 標(biāo)簽:函數(shù)Transformer 1368 0

將BEV下的每個grid作為query,在高度上采樣N個點,投影到圖像中sample到對應(yīng)像素的特征,且利用了空間和時間的信息。并且最終得到的是BEV ...

2023-09-04 標(biāo)簽:算法感知Transformer 1675 0

換一批

換一批

編輯推薦廠商產(chǎn)品技術(shù)軟件/工具OS/語言教程專題

| 電機(jī)控制 | DSP | 氮化鎵 | 功率放大器 | ChatGPT | 自動駕駛 | TI | 瑞薩電子 |

| BLDC | PLC | 碳化硅 | 二極管 | OpenAI | 元宇宙 | 安森美 | ADI |

| 無刷電機(jī) | FOC | IGBT | 逆變器 | 文心一言 | 5G | 英飛凌 | 羅姆 |

| 直流電機(jī) | PID | MOSFET | 傳感器 | 人工智能 | 物聯(lián)網(wǎng) | NXP | 賽靈思 |

| 步進(jìn)電機(jī) | SPWM | 充電樁 | IPM | 機(jī)器視覺 | 無人機(jī) | 三菱電機(jī) | ST |

| 伺服電機(jī) | SVPWM | 光伏發(fā)電 | UPS | AR | 智能電網(wǎng) | 國民技術(shù) | Microchip |

| Arduino | BeagleBone | 樹莓派 | STM32 | MSP430 | EFM32 | ARM mbed | EDA |

| 示波器 | LPC | imx8 | PSoC | Altium Designer | Allegro | Mentor | Pads |

| OrCAD | Cadence | AutoCAD | 華秋DFM | Keil | MATLAB | MPLAB | Quartus |

| C++ | Java | Python | JavaScript | node.js | RISC-V | verilog | Tensorflow |

| Android | iOS | linux | RTOS | FreeRTOS | LiteOS | RT-THread | uCOS |

| DuerOS | Brillo | Windows11 | HarmonyOS |