LLM的幻覺問題最新綜述

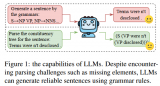

幻覺被描述為無意義或不忠實(shí)于所提供源內(nèi)容的生成內(nèi)容。根據(jù)與源內(nèi)容的矛盾,這些幻覺又進(jìn)一步分為內(nèi)在幻覺....

Scaling Law大模型設(shè)計(jì)實(shí)操案例

縱軸是"Bits for words", 這也是交叉熵的一個(gè)單位。在計(jì)算交叉熵時(shí),如果使用以 2 為....

基于大語言模型的共情回復(fù)生成:實(shí)證研究和改進(jìn)

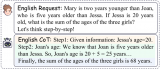

對(duì)以ChatGPT為代表的LLMs在共情回復(fù)生成上的表現(xiàn)進(jìn)行了全面的實(shí)證研究,LLMs在現(xiàn)有的基準(zhǔn)數(shù)....

基于顯式證據(jù)推理的few-shot關(guān)系抽取CoT

最近,上下文學(xué)習(xí)策略已被證明在沒有訓(xùn)練的情況下顯示出顯著的結(jié)果。很少有研究利用上下文學(xué)習(xí)進(jìn)行zero....

LLMs實(shí)際上在假對(duì)齊!

LLM的訓(xùn)練分為預(yù)訓(xùn)練和安全訓(xùn)練。預(yù)訓(xùn)練是指在大規(guī)模語料庫上進(jìn)行訓(xùn)練,因此LLM獲得了各種強(qiáng)大的能力....

500篇論文!最全代碼大模型綜述

經(jīng)典 Transformer 使用不可學(xué)習(xí)的余弦編碼,加在模型底層的詞向量輸入上。GPT、BERT將....

多任務(wù)微調(diào)框架MFTCoder詳細(xì)技術(shù)解讀

MFTCoder具備高效訓(xùn)練特征,包括提供高效的數(shù)據(jù)Tokenization模式和支持PEFT微調(diào),....

用LLM生成反駁:首先洞察審稿人的心理,再巧妙回應(yīng)!

同行評(píng)審對(duì)于確保科學(xué)的高質(zhì)量至關(guān)重要:作者提交研究成果,而審稿人則辯論應(yīng)不應(yīng)該接受其發(fā)表。通常評(píng)審后....

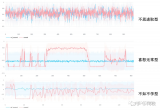

怎樣讓PPO訓(xùn)練更穩(wěn)定?早期人類征服RLHF的馴化經(jīng)驗(yàn)

盡管魯迅先生曾言:真的強(qiáng)化敢于直面慘淡的結(jié)果,敢于正視崩壞的曲線。但日復(fù)一復(fù)地開盲盒難免會(huì)讓人心臟承....

如何解決LLMs的規(guī)則遵循問題呢?

傳統(tǒng)的計(jì)算系統(tǒng)是圍繞計(jì)算機(jī)程序中表達(dá)的指令的執(zhí)行來設(shè)計(jì)的。相反,語言模型可以遵循用自然語言表達(dá)的指令....

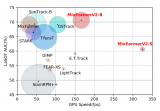

MixFormerV2:基于Transformer的高效跟蹤器

我們通過簡(jiǎn)潔有效的模型結(jié)構(gòu)設(shè)計(jì)和高效的基于知識(shí)蒸餾的模型壓縮,對(duì)于現(xiàn)有的 MixFormer 模型進(jìn)....

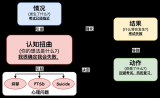

認(rèn)知扭曲類別

可以看出認(rèn)知扭曲本身雖然往往和負(fù)面情緒相關(guān),但其更多是強(qiáng)調(diào)不合理的負(fù)面情緒,這些負(fù)面情緒的形成和加強(qiáng)....

全球首款支持 8K(8192)輸入長(zhǎng)度的開源向量模型發(fā)布

在大模型時(shí)代,向量模型的重要性進(jìn)一步增強(qiáng)。尤其是在檢索增強(qiáng)生成(RAG)場(chǎng)景中,它成為了一個(gè)核心組件....

探索SFT訓(xùn)練策略對(duì)性能的影響

大模型混合多種能力項(xiàng)數(shù)據(jù)進(jìn)行微調(diào)時(shí),會(huì)呈現(xiàn)高資源沖突,低資源增益的現(xiàn)象。我們提出的DMT策略通過在第....

開源LLEMMA發(fā)布:超越未公開的頂尖模型,可直接應(yīng)用于工具和定理證明

但LLEMMA的出現(xiàn)改變了這一局面。它不僅在MATH基準(zhǔn)測(cè)試上創(chuàng)下了新高,甚至超越了某些還未對(duì)外公開....

LLaMA2上下文長(zhǎng)度暴漲至100萬tokens,只需調(diào)整1個(gè)超參數(shù)

目前的Transformer位置編碼方法,有絕對(duì)位置編碼(將位置信息融入到輸入)、相對(duì)位置編碼(將位....

DISC-LawLLM:復(fù)旦大學(xué)團(tuán)隊(duì)發(fā)布中文智慧法律系統(tǒng),構(gòu)建司法評(píng)測(cè)基準(zhǔn),開源30萬微調(diào)數(shù)據(jù)

DISC-LawLLM是基于我們構(gòu)建的高質(zhì)量數(shù)據(jù)集DISC-Law-SFT在通用領(lǐng)域中文大模型Bai....

多模態(tài)大模型最全綜述來了!

其中最后一個(gè)表示監(jiān)督信號(hào)是從圖像本身中挖掘出來的,流行的方法包括對(duì)比學(xué)習(xí)、非對(duì)比學(xué)習(xí)和masked ....

華為提出Sorted LLaMA:SoFT代替SFT,訓(xùn)練多合一大語言模型

而這一切的背后,是一項(xiàng)名為Sorted Fine-Tuning(SoFT)的新訓(xùn)練技術(shù)。SoFT讓我....

AIGC移動(dòng)端也有機(jī)會(huì)

a16z是硅谷一家有名的投資機(jī)構(gòu),近期發(fā)布了他們根據(jù)月瀏覽量統(tǒng)計(jì)的TOP50 GenAI產(chǎn)品,并給出....

DreamLLM:多功能多模態(tài)大型語言模型,你的DreamLLM~

由于固有的模態(tài)缺口,如CLIP語義主要關(guān)注模態(tài)共享信息,往往忽略了可以增強(qiáng)多模態(tài)理解的模態(tài)特定知識(shí)。....