電子發(fā)燒友網(wǎng)報道(文/李彎彎)在深度學(xué)習(xí)中,經(jīng)常聽到一個詞“模型訓(xùn)練”,但是模型是什么?又是怎么訓(xùn)練的?在人工智能中,面對大量的數(shù)據(jù),要在雜亂無章的內(nèi)容中,準(zhǔn)確、容易地識別,輸出需要的圖像/語音

2022-10-23 00:19:00 24517

24517 分布式深度學(xué)習(xí)框架中,包括數(shù)據(jù)/模型切分、本地單機優(yōu)化算法訓(xùn)練、通信機制、和數(shù)據(jù)/模型聚合等模塊。現(xiàn)有的算法一般采用隨機置亂切分的數(shù)據(jù)分配方式,隨機優(yōu)化算法(例如隨機梯度法)的本地訓(xùn)練算法,同步或者異步通信機制,以及參數(shù)平均的模型聚合方式。

2018-07-09 08:48:22 13627

13627

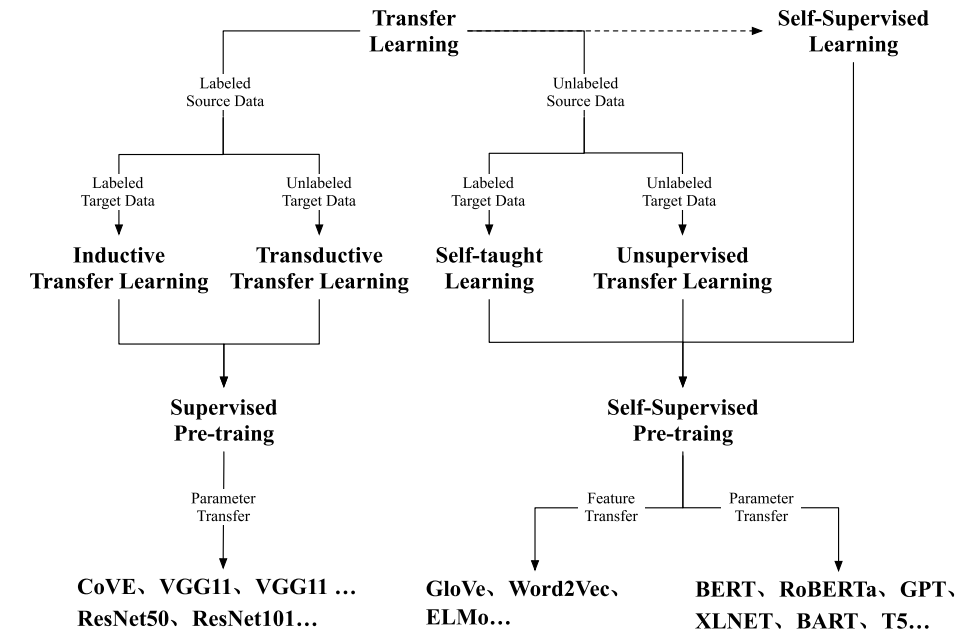

隨著預(yù)訓(xùn)練語言模型(PLMs)的不斷發(fā)展,各種NLP任務(wù)設(shè)置上都取得了不俗的性能。盡管PLMs可以從大量語料庫中學(xué)習(xí)一定的知識,但仍舊存在很多問題,如知識量有限、受訓(xùn)練數(shù)據(jù)長尾分布影響魯棒性不好

2022-04-02 17:21:43 8830

8830 NLP領(lǐng)域的研究目前由像RoBERTa等經(jīng)過數(shù)十億個字符的語料經(jīng)過預(yù)訓(xùn)練的模型匯主導(dǎo)。那么對于一個預(yù)訓(xùn)練模型,對于不同量級下的預(yù)訓(xùn)練數(shù)據(jù)能夠提取到的知識和能力有何不同?

2023-03-03 11:21:51 1353

1353 訓(xùn)練好的ai模型導(dǎo)入cubemx不成功咋辦,試了好幾個模型壓縮了也不行,ram占用過大,有無解決方案?

2023-08-04 09:16:28

Edge Impulse是一個應(yīng)用于嵌入式領(lǐng)域的在線的機器學(xué)習(xí)網(wǎng)站,不僅為用戶提供了一些現(xiàn)成的神經(jīng)網(wǎng)絡(luò)模型以供訓(xùn)練,還能直接將訓(xùn)練好的模型轉(zhuǎn)換成能在單片機MCU上運行的代碼,使用方便,容易上手。本文

2021-12-20 06:51:26

工具篇Flair之訓(xùn)練模型教程

2020-04-27 14:03:05

),其中y取值1或-1(代表二分類的類別標(biāo)簽),這也是GBDT可以用來解決分類問題的原因。模型訓(xùn)練代碼地址 https://github.com/qianshuang/ml-expdef train

2019-01-23 14:38:58

PaddlePaddle Fluid版本的PaddlePaddle如何在訓(xùn)練前加載此前訓(xùn)練好的模型?

2019-04-15 11:19:15

本教程以實際應(yīng)用、工程開發(fā)為目的,著重介紹模型訓(xùn)練過程中遇到的實際問題和方法。在機器學(xué)習(xí)模型開發(fā)中,主要涉及三大部分,分別是數(shù)據(jù)、模型和損失函數(shù)及優(yōu)化器。本文也按順序的依次介紹數(shù)據(jù)、模型和損失函數(shù)

2018-12-21 09:18:02

能否直接調(diào)用訓(xùn)練好的模型文件?

2021-06-22 14:51:03

本帖最后由 wcl86 于 2021-9-9 10:39 編輯

`labview調(diào)用深度學(xué)習(xí)tensorflow模型非常簡單,效果如下,附上源碼和訓(xùn)練過的模型:[hide][/hide

2021-06-03 16:38:25

準(zhǔn)備開始為家貓做模型訓(xùn)練檢測,要去官網(wǎng)https://maix.sipeed.com/home 注冊帳號,文章尾部的視頻是官方的,與目前網(wǎng)站略有出路,說明訓(xùn)練網(wǎng)站的功能更新得很快。其實整個的過程

2022-06-26 21:19:40

TOP1的桂冠,可想大家對本書的認(rèn)可和支持!

這本書為什么如此受歡迎?它究竟講了什么?下面就給大家詳細(xì)~~

本書主要內(nèi)容

本書圍繞大語言模型構(gòu)建的四個主要階段——預(yù)訓(xùn)練、有監(jiān)督微調(diào)、獎勵建模和強化

2024-03-11 15:16:39

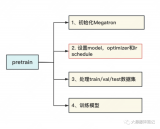

,導(dǎo)出onnx

這里就取了個巧,直接用torch官方庫里面預(yù)訓(xùn)練好的模型導(dǎo)出來,得到onnx模型。后續(xù)還可以進一步轉(zhuǎn)化為-sim.onnx文件,做了一定的簡化,不過差別不大。

import torch

2023-12-10 16:34:43

` EasyDL網(wǎng)站可以免費生成針對EdgeBoard板卡FZ5的離線訓(xùn)練模型SDK,該SDK可以完美與FZ5硬件契合,最重要的是——free(免費)。下面就是針對FZ5生成模型SDK的實例——圖片

2021-03-23 14:32:35

的模型似乎只提供了更多的圖像,而世界上并不缺少圖像。研究生成模型有幾個原因,包括: ●從生成模型中進行訓(xùn)練和采樣是對我們表示和操作高維概率分布能力的極好測試。高維概率分布是...

2021-09-15 06:03:29

醫(yī)療模型人訓(xùn)練系統(tǒng)是為滿足廣大醫(yī)學(xué)生的需要而設(shè)計的。我國現(xiàn)代醫(yī)療模擬技術(shù)的發(fā)展處于剛剛起步階段,大部分仿真系統(tǒng)產(chǎn)品都源于國外,雖然對于模擬人仿真已經(jīng)出現(xiàn)一些產(chǎn)品,但那些產(chǎn)品只是就模擬人的某一部分,某一個功能實現(xiàn)的仿真,沒有一個完整的系統(tǒng)綜合其所有功能。

2019-08-19 08:32:45

RS-LiDAR-Algorithms 感知算法。經(jīng)過與多個自動駕駛汽車研發(fā)團隊的聯(lián)合調(diào)試打磨,RS-LiDAR-Algorithms 目前已經(jīng)可以駕馭常見的大部分自動駕駛場景,其以內(nèi)測為主的階段性使命已經(jīng)完成。速騰

2017-12-15 14:20:48

增加學(xué)習(xí)功能并應(yīng)用于機器學(xué) 習(xí),發(fā)明了感知器算法[20],該算法使用 MCP 模型能夠 采用梯度下降法從訓(xùn)練樣本中自動學(xué)習(xí)并更新權(quán) 值,并能對輸入的多維數(shù)據(jù)進行二分類,其理論與實 踐的效果引起了

2022-08-02 10:39:39

問題最近在Ubuntu上使用Nvidia GPU訓(xùn)練模型的時候,沒有問題,過一會再訓(xùn)練出現(xiàn)非常卡頓,使用nvidia-smi查看發(fā)現(xiàn),顯示GPU的風(fēng)扇和電源報錯:解決方案自動風(fēng)扇控制在nvidia

2022-01-03 08:24:09

CV:基于Keras利用訓(xùn)練好的hdf5模型進行目標(biāo)檢測實現(xiàn)輸出模型中的臉部表情或性別的gradcam(可視化)

2018-12-27 16:48:28

一個超平面上的線性二分類模型。作為原著第二章,實在是簡單得不能再簡單了。然而實際運用中,越簡單的模型往往生命力越頑強。這里唯一需要補充的是,感知機是個在線學(xué)習(xí)模型,學(xué)習(xí)一個訓(xùn)練實例后,就可以更新整個

2019-01-14 11:15:41

使用TensorFlow的transform_graph工具生成一個優(yōu)化的8位模型,該模型效率更高,但精度較低。

4.在設(shè)備上對優(yōu)化的模型進行基準(zhǔn)測試,并選擇最符合您部署需求的模型。

本教程使用預(yù)訓(xùn)練

2023-08-02 06:43:57

我正在嘗試使用 eIQ 門戶訓(xùn)練人臉檢測模型。我正在嘗試從 tensorflow 數(shù)據(jù)集 (tfds) 導(dǎo)入數(shù)據(jù)集,特別是 coco/2017 數(shù)據(jù)集。但是,我只想導(dǎo)入 wider_face。但是,當(dāng)我嘗試這樣做時,會出現(xiàn)導(dǎo)入程序錯誤,如下圖所示。任何幫助都可以。

2023-04-06 08:45:14

無法確定如何轉(zhuǎn)換 PyTorch 掩碼 R-CNN 模型以配合OpenVINO?使用。

2023-08-15 07:04:51

PyTorch Hub 加載預(yù)訓(xùn)練的 YOLOv5s 模型,model并傳遞圖像進行推理。'yolov5s'是最輕最快的 YOLOv5 型號。有關(guān)所有可用模型的詳細(xì)信息,請參閱自述文件。詳細(xì)示例此示例

2022-07-22 16:02:42

(1 GPU)和時間(24小時)資源下從頭開始訓(xùn)練ViT模型。首先,提出了一種向ViT架構(gòu)添加局部性的有效方法。其次,開發(fā)了一種新的圖像大小課程學(xué)習(xí)策略,該策略允許在訓(xùn)練開始時減少從每個圖像中提

2022-11-24 14:56:31

永磁交流伺服電機模型是什么?永磁交流伺服電機模型有哪幾種控制策略?

2021-09-27 06:04:42

到準(zhǔn)備模型,然后再在邊緣的嵌入式系統(tǒng)上運行。訓(xùn)練深度學(xué)習(xí)模型是過程的工作量和時間密集型部分,其中通過提供需要時間和

2021-10-27 06:34:15

深度融合模型的特點,背景深度學(xué)習(xí)模型在訓(xùn)練完成之后,部署并應(yīng)用在生產(chǎn)環(huán)境的這一步至關(guān)重要,畢竟訓(xùn)練出來的模型不能只接受一些公開數(shù)據(jù)集和榜單的檢驗,還需要在真正的業(yè)務(wù)場景下創(chuàng)造價值,不能只是為了PR而

2021-07-16 06:08:20

tensorflow模型部署系列的一部分,用于tflite實現(xiàn)通用模型的部署。本文主要使用pb格式的模型文件,其它格式的模型文件請先進行格式轉(zhuǎn)換,參考tensorflow模型部署系列————預(yù)訓(xùn)練模型導(dǎo)出。從...

2021-12-22 06:51:18

),其中y取值1或-1(代表二分類的類別標(biāo)簽),這也是GBDT可以用來解決分類問題的原因。模型訓(xùn)練代碼地址 https://github.com/qianshuang/ml-expdef train

2019-01-25 15:02:15

請問LIDAR感知挑戰(zhàn)有哪些?

2021-06-17 11:49:08

目前官方的線上模型訓(xùn)練只支持K210,請問K510什么時候可以支持

2023-09-13 06:12:13

我在matlab中訓(xùn)練好了一個神經(jīng)網(wǎng)絡(luò)模型,想在labview中調(diào)用,請問應(yīng)該怎么做呢?或者labview有自己的神經(jīng)網(wǎng)絡(luò)工具包嗎?

2018-07-05 17:32:32

基于模型的動態(tài)測試工具TPTTPT特性PikeTec公司是全球知名的基于模型的嵌入式系統(tǒng)測試工具TPT的軟件供應(yīng)商,總部位于德國柏林,其創(chuàng)始人均在戴姆勒公司擁有十多年的軟件測試經(jīng)驗。TPT作為針對

2022-07-25 15:35:26

分析動態(tài)自適應(yīng)網(wǎng)絡(luò)安全模型P2DR的缺陷,提出對P2DR模型的幾點改進建議。針對模型中策略相關(guān)不足設(shè)計了一個策略部署模型,該部署模型實現(xiàn)了策略統(tǒng)一定制、自動分發(fā)、自適應(yīng)管

2009-04-13 09:40:16 27

27 在介紹策略、域和策略目標(biāo)等基本概念的基礎(chǔ)上,提出了一個通用性的策略部署模型,該模型采用基于域的分層結(jié)構(gòu),把策略存儲在離策略目標(biāo)最近的域中,并以遞增式算法進行收

2009-05-25 21:47:02 7

7 最佳捕魚策略的數(shù)學(xué)模型本文的數(shù)學(xué)模型提法清楚,相對于捕撈強度遞增的不同預(yù)測值,對魚群變化進行動態(tài)模撥。

2009-09-16 11:37:32 113

113 本文通過對水印系統(tǒng)感知特性和感知現(xiàn)象的討論,分析watson感知模型設(shè)計思想,研究Watson感知模型的應(yīng)用。

2011-09-01 10:14:50 2888

2888 水印系統(tǒng)不可能產(chǎn)生不可察覺的水印,其感知性只能用高低來衡量。這就需要對水印的感知性進行感知效果評價及建立相應(yīng)的感知模型進行描述。本文通過對水印系統(tǒng)感知特性和感知現(xiàn)

2011-10-13 17:05:38 24

24 霧霾監(jiān)測點作為霧霾數(shù)據(jù)感知的源頭,由于缺乏有效的評價方法,導(dǎo)致感知的數(shù)據(jù)不可靠。針對此問題,提出一種感知源信任評價和篩選模型,該模型采用數(shù)據(jù)觸發(fā)檢測方式來進行。當(dāng)感知源的數(shù)據(jù)到達(dá)時,首先

2017-12-23 10:34:46 0

0 由于觸覺是一種主動的感覺,即感覺器官在感覺過程中被移動,所以這些模型經(jīng)常描述優(yōu)化感知結(jié)果的運動策略。

2018-05-03 16:18:55 4458

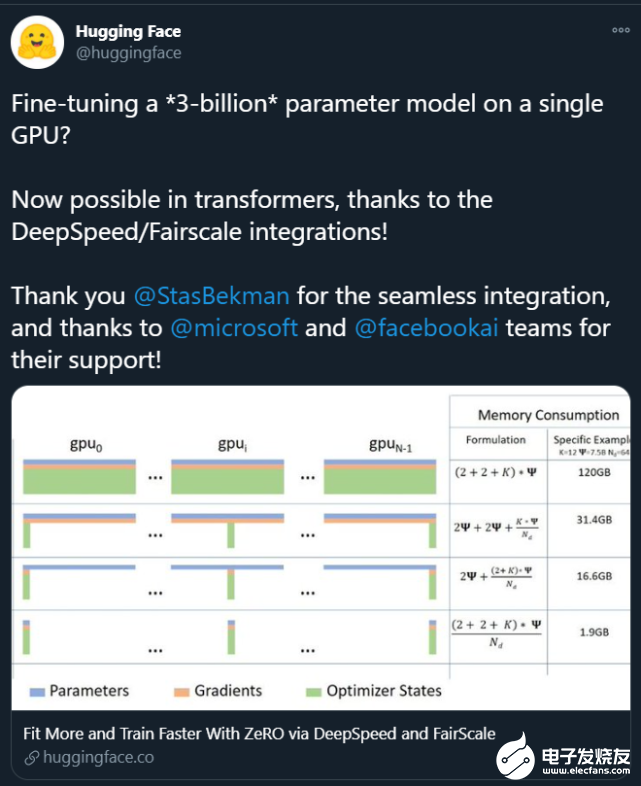

4458 深度學(xué)習(xí)模型和數(shù)據(jù)集的規(guī)模增長速度已經(jīng)讓 GPU 算力也開始捉襟見肘,如果你的 GPU 連一個樣本都容不下,你要如何訓(xùn)練大批量模型?通過本文介紹的方法,我們可以在訓(xùn)練批量甚至單個訓(xùn)練樣本大于 GPU

2018-12-03 17:24:01 676

676 在三維非剛性模型分析中,通常需要對不同姿態(tài)下的模型進行配準(zhǔn)。針對傳統(tǒng)配準(zhǔn)算法存在復(fù)雜度高、計算量大、精確度低等問題,提出一種新的基于分層策略的三維非剛性模型配準(zhǔn)算法。首先,定義熱核簽名函數(shù)為模型

2019-01-23 14:50:48 3

3 正如我們在本文中所述,ULMFiT使用新穎的NLP技術(shù)取得了令人矚目的成果。該方法對預(yù)訓(xùn)練語言模型進行微調(diào),將其在WikiText-103數(shù)據(jù)集(維基百科的長期依賴語言建模數(shù)據(jù)集Wikitext之一)上訓(xùn)練,從而得到新數(shù)據(jù)集,通過這種方式使其不會忘記之前學(xué)過的內(nèi)容。

2019-04-04 11:26:26 23207

23207

機器學(xué)習(xí)模型的訓(xùn)練,通常是通過學(xué)習(xí)某一組輸入特征與輸出目標(biāo)之間的映射來進行的。一般來說,對于映射的學(xué)習(xí)是通過優(yōu)化某些成本函數(shù),來使預(yù)測的誤差最小化。在訓(xùn)練出最佳模型之后,將其正式發(fā)布上線,再根據(jù)未來

2020-04-10 08:00:00 0

0 在這篇文章中,我會介紹一篇最新的預(yù)訓(xùn)練語言模型的論文,出自MASS的同一作者。這篇文章的亮點是:將兩種經(jīng)典的預(yù)訓(xùn)練語言模型(MaskedLanguage Model, Permuted

2020-11-02 15:09:36 2354

2354 本文把對抗訓(xùn)練用到了預(yù)訓(xùn)練和微調(diào)兩個階段,對抗訓(xùn)練的方法是針對embedding space,通過最大化對抗損失、最小化模型損失的方式進行對抗,在下游任務(wù)上取得了一致的效果提升。 有趣的是,這種對抗

2020-11-02 15:26:49 1818

1818

本期推送介紹了哈工大訊飛聯(lián)合實驗室在自然語言處理重要國際會議COLING 2020上發(fā)表的工作,提出了一種字符感知預(yù)訓(xùn)練模型CharBERT,在多個自然語言處理任務(wù)中取得顯著性能提升,并且大幅度

2020-11-27 10:47:09 1595

1595

量化感知訓(xùn)練(Quantization Aware Training )是在模型中插入偽量化模塊(fake\_quant module)模擬量化模型在推理過程中進行的舍入(r...

2020-12-08 22:57:05 1733

1733 導(dǎo)讀:預(yù)訓(xùn)練模型在NLP大放異彩,并開啟了預(yù)訓(xùn)練-微調(diào)的NLP范式時代。由于工業(yè)領(lǐng)域相關(guān)業(yè)務(wù)的復(fù)雜性,以及工業(yè)應(yīng)用對推理性能的要求,大規(guī)模預(yù)訓(xùn)練模型往往不能簡單直接地被應(yīng)用于NLP業(yè)務(wù)中。本文將為

2020-12-31 10:17:11 2227

2227

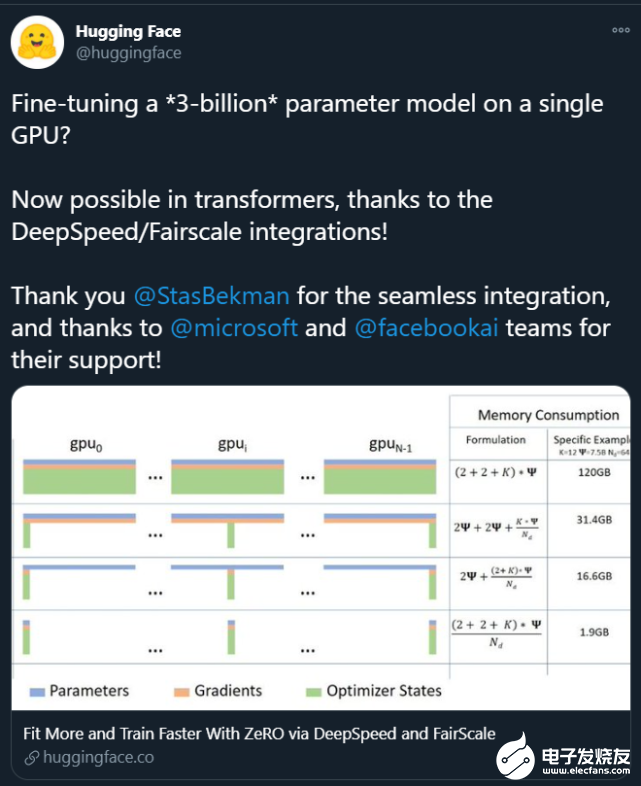

。這些大模型的出現(xiàn)讓普通研究者越發(fā)絕望:沒有「鈔能力」、沒有一大堆 GPU 就做不了 AI 研究了嗎? 在此背景下,部分研究者開始思考:如何讓這些大模型的訓(xùn)練變得更加接地氣?也就是說,怎么用更少的卡訓(xùn)練更大的模型? 為了解決這個問題,來自微軟、加州大學(xué)默塞德分校的研究

2021-02-11 09:04:00 2184

2184

為提高卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)檢測模型精度并增強檢測器對小目標(biāo)的檢測能力,提出一種脫離預(yù)訓(xùn)練的多尺度目標(biāo)檢測網(wǎng)絡(luò)模型。采用脫離預(yù)訓(xùn)練檢測網(wǎng)絡(luò)使其達(dá)到甚至超過預(yù)訓(xùn)練模型的精度,針對小目標(biāo)特點

2021-04-02 11:35:50 26

26 作為模型的初始化詞向量。但是,隨機詞向量存在不具備語乂和語法信息的缺點;預(yù)訓(xùn)練詞向量存在¨一詞-乂”的缺點,無法為模型提供具備上下文依賴的詞向量。針對該問題,提岀了一種基于預(yù)訓(xùn)練模型BERT和長短期記憶網(wǎng)絡(luò)的深度學(xué)習(xí)

2021-04-20 14:29:06 19

19 針對孿生區(qū)域候選網(wǎng)絡(luò)(RPN)易受干擾且目標(biāo)丟失后無法跟蹤的問題,引人錨框掩碼網(wǎng)絡(luò)機制,設(shè)計種新型孿生RPN模型。設(shè)置多尺度模板圖片,并將其與目標(biāo)圖片進行卷積操作,實現(xiàn)全圖檢測以避免目標(biāo)丟失。通過

2021-06-08 14:58:13 18

18 基于多層感知機模型的自適應(yīng)簡化率預(yù)測

2021-06-21 16:27:29 8

8 本文關(guān)注于向大規(guī)模預(yù)訓(xùn)練語言模型(如RoBERTa、BERT等)中融入知識。

2021-06-23 15:07:31 3536

3536

在某一方面的智能程度。具體來說是,領(lǐng)域?qū)<胰斯?gòu)造標(biāo)準(zhǔn)數(shù)據(jù)集,然后在其上訓(xùn)練及評價相關(guān)模型及方法。但由于相關(guān)技術(shù)的限制,要想獲得效果更好、能力更強的模型,往往需要在大量的有標(biāo)注的數(shù)據(jù)上進行訓(xùn)練。 近期預(yù)訓(xùn)練模型的

2021-09-06 10:06:53 3378

3378

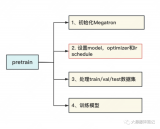

NVIDIA Megatron 是一個基于 PyTorch 的框架,用于訓(xùn)練基于 Transformer 架構(gòu)的巨型語言模型。本系列文章將詳細(xì)介紹Megatron的設(shè)計和實踐,探索這一框架如何助力

2021-10-20 09:25:43 2096

2096 2021 OPPO開發(fā)者大會:NLP預(yù)訓(xùn)練大模型 2021 OPPO開發(fā)者大會上介紹了融合知識的NLP預(yù)訓(xùn)練大模型。 責(zé)任編輯:haq

2021-10-27 14:18:41 1504

1504

NLP中,預(yù)訓(xùn)練大模型Finetune是一種非常常見的解決問題的范式。利用在海量文本上預(yù)訓(xùn)練得到的Bert、GPT等模型,在下游不同任務(wù)上分別進行finetune,得到下游任務(wù)的模型。然而,這種方式

2022-03-21 15:33:30 1867

1867 由于亂序語言模型不使用[MASK]標(biāo)記,減輕了預(yù)訓(xùn)練任務(wù)與微調(diào)任務(wù)之間的gap,并由于預(yù)測空間大小為輸入序列長度,使得計算效率高于掩碼語言模型。PERT模型結(jié)構(gòu)與BERT模型一致,因此在下游預(yù)訓(xùn)練時,不需要修改原始BERT模型的任何代碼與腳本。

2022-05-10 15:01:27 1193

1193 TAO 工具提供提供 QAT (Quantize Aware Training) 量化感知的訓(xùn)練模式,不過目前 QAT 效果還在驗證當(dāng)中,倒也不急于使用,因此我們還是以標(biāo)準(zhǔn)模式來訓(xùn)練,就是將配置文件

2022-05-13 10:57:19 1192

1192 為了減輕上述問題,提出了NoisyTune方法,即,在finetune前加入給預(yù)訓(xùn)練模型的參數(shù)增加少量噪音,給原始模型增加一些擾動,從而提高預(yù)訓(xùn)練語言模型在下游任務(wù)的效果,如下圖所示,

2022-06-07 09:57:32 2006

2006 本文對任務(wù)低維本征子空間的探索是基于 prompt tuning, 而不是fine-tuning。原因是預(yù)訓(xùn)練模型的參數(shù)實在是太多了,很難找到這么多參數(shù)的低維本征子空間。作者基于之前的工作提出

2022-07-08 11:28:24 954

954 表示輸入的特征,在傳統(tǒng)的對抗訓(xùn)練中, 通常是 token 序列或者是 token 的 embedding, 表示 ground truth. 對于由 參數(shù)化的模型,模型的預(yù)測結(jié)果可以表示為 。

2022-07-08 16:57:09 1062

1062 電子發(fā)燒友網(wǎng)報道(文/李彎彎)在深度學(xué)習(xí)中,經(jīng)常聽到一個詞“模型訓(xùn)練”,但是模型是什么?又是怎么訓(xùn)練的?在人工智能中,面對大量的數(shù)據(jù),要在雜亂無章的內(nèi)容中,準(zhǔn)確、容易地識別,輸出需要的圖像/語音

2022-10-23 00:20:03 7397

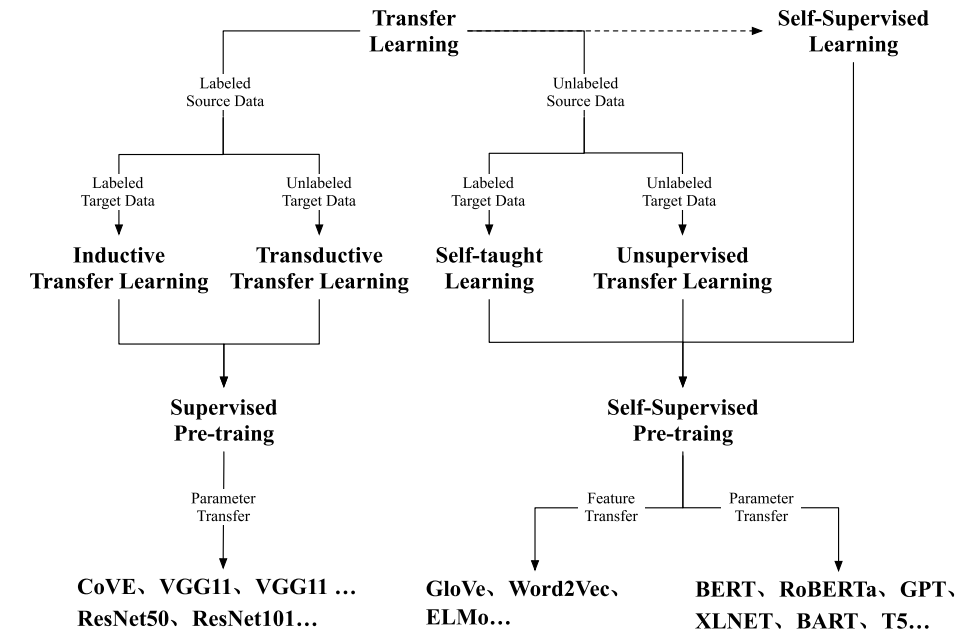

7397 隨著BERT、GPT等預(yù)訓(xùn)練模型取得成功,預(yù)訓(xùn)-微調(diào)范式已經(jīng)被運用在自然語言處理、計算機視覺、多模態(tài)語言模型等多種場景,越來越多的預(yù)訓(xùn)練模型取得了優(yōu)異的效果。

2022-11-08 09:57:19 3777

3777 ON Semiconductor Gen3 掃描 LiDAR 演示器的性能測量和模型驗證

2022-11-15 20:12:52 0

0 NVIDIA 發(fā)布了 TAO 工具套件 4.0 。該工具套件通過全新的 AutoML 功能、與第三方 MLOPs 服務(wù)的集成以及新的預(yù)訓(xùn)練視覺 AI 模型提高開發(fā)者的生產(chǎn)力。該工具套件的企業(yè)版現(xiàn)在

2022-12-15 19:40:06 737

737 2022年下半年開始,涌現(xiàn)出一大批“大模型”的優(yōu)秀應(yīng)用,其中比較出圈的當(dāng)屬AI作畫與ChatGPT,刷爆了各類社交平臺,其讓人驚艷的效果,讓AI以一個鮮明的姿態(tài),站到了廣大民眾面前,讓不懂AI的人也能直觀地體會到AI的強大。大模型即大規(guī)模預(yù)訓(xùn)練模型 。

2023-02-20 14:09:11 1424

1424

BERT類模型的工作模式簡單,但取得的效果也是極佳的,其在各項任務(wù)上的良好表現(xiàn)主要得益于其在大量無監(jiān)督文本上學(xué)習(xí)到的文本表征能力。那么如何從語言學(xué)的特征角度來衡量一個預(yù)訓(xùn)練模型的究竟學(xué)習(xí)到了什么樣的語言學(xué)文本知識呢?

2023-03-03 11:20:00 931

931 預(yù)訓(xùn)練 AI 模型是為了完成特定任務(wù)而在大型數(shù)據(jù)集上訓(xùn)練的深度學(xué)習(xí)模型。這些模型既可以直接使用,也可以根據(jù)不同行業(yè)的應(yīng)用需求進行自定義。 如果要教一個剛學(xué)會走路的孩子什么是獨角獸,那么我們首先應(yīng)

2023-04-04 01:45:02 1055

1055 作為深度學(xué)習(xí)領(lǐng)域的 “github”,HuggingFace 已經(jīng)共享了超過 100,000 個預(yù)訓(xùn)練模型

2023-05-19 15:57:43 512

512

預(yù)訓(xùn)練 AI 模型是為了完成特定任務(wù)而在大型數(shù)據(jù)集上訓(xùn)練的深度學(xué)習(xí)模型。這些模型既可以直接使用,也可以根據(jù)不同行業(yè)的應(yīng)用需求進行自定義。

2023-05-25 17:10:09 613

613 本文章將依次介紹如何將Pytorch自訓(xùn)練模型經(jīng)過一系列變換變成OpenVINO IR模型形式,而后使用OpenVINO Python API 對IR模型進行推理,并將推理結(jié)果通過OpenCV API顯示在實時畫面上。

2023-06-07 09:31:42 1092

1092

前文說過,用Megatron做分布式訓(xùn)練的開源大模型有很多,我們選用的是THUDM開源的CodeGeeX(代碼生成式大模型,類比于openAI Codex)。選用它的原因是“完全開源”與“清晰的模型架構(gòu)和預(yù)訓(xùn)練配置圖”,能幫助我們高效閱讀源碼。我們再來回顧下這兩張圖。

2023-06-07 15:08:24 2323

2323

在一些非自然圖像中要比傳統(tǒng)模型表現(xiàn)更好 CoOp 增加一些 prompt 會讓模型能力進一步提升 怎么讓能力更好?可以引入其他知識,即其他的預(yù)訓(xùn)練模型,包括大語言模型、多模態(tài)模型 也包括

2023-06-15 16:36:11 296

296

ai大模型和小模型的區(qū)別? 人工智能領(lǐng)域中的模型分為兩種,一種是大模型,另一種是小模型,兩者在訓(xùn)練和應(yīng)用中有著明顯的區(qū)別。 本文將從定義、特點、應(yīng)用等方面詳細(xì)介紹這兩種模型的區(qū)別。 一、概念定義

2023-08-08 17:30:54 4787

4787 卷積神經(jīng)網(wǎng)絡(luò)模型訓(xùn)練步驟? 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network, CNN)是一種常用的深度學(xué)習(xí)算法,廣泛應(yīng)用于圖像識別、語音識別、自然語言處理等諸多領(lǐng)域。CNN

2023-08-21 16:42:00 955

955 在《英特爾銳炫 顯卡+ oneAPI 和 OpenVINO 實現(xiàn)英特爾 視頻 AI 計算盒訓(xùn)推一體-上篇》一文中,我們詳細(xì)介紹基于英特爾 獨立顯卡搭建 YOLOv7 模型的訓(xùn)練環(huán)境,并完成了 YOLOv7 模型訓(xùn)練,獲得了最佳精度的模型權(quán)重。

2023-08-25 11:08:58 851

851

生成式AI和大語言模型(LLM)正在以難以置信的方式吸引全世界的目光,本文簡要介紹了大語言模型,訓(xùn)練這些模型帶來的硬件挑戰(zhàn),以及GPU和網(wǎng)絡(luò)行業(yè)如何針對訓(xùn)練的工作負(fù)載不斷優(yōu)化硬件。

2023-09-01 17:14:56 1065

1065

華為盤古大模型以Transformer模型架構(gòu)為基礎(chǔ),利用深層學(xué)習(xí)技術(shù)進行訓(xùn)練。模型的每個數(shù)量達(dá)到2.6億個,是目前世界上最大的漢語預(yù)備訓(xùn)練模型之一。這些模型包含許多小模型,其中最大的模型包含1億4千萬個參數(shù)。

2023-09-05 09:55:56 1304

1304 前面已經(jīng)講過了Yolov5模型目標(biāo)檢測和分類模型訓(xùn)練流程,這一篇講解一下yolov5模型結(jié)構(gòu),數(shù)據(jù)增強,以及訓(xùn)練策略。

2023-09-11 11:15:21 979

979

近期,一支來自中國的研究團隊正是針對這些問題提出了解決方案,他們推出了FLM-101B模型及其配套的訓(xùn)練策略。FLM-101B不僅大幅降低了訓(xùn)練成本,而且其性能表現(xiàn)仍然非常出色,它是目前訓(xùn)練成本最低的100B+ LLM。

2023-09-12 16:30:30 952

952

finetune)、rlhf(optional). ?State of GPT:大神 Andrej 揭秘 OpenAI 大模型原理和訓(xùn)練過程 。 supervised finetune 一般在 base

2023-09-19 10:00:06 530

530

Hello大家好,今天給大家分享一下如何基于深度學(xué)習(xí)模型訓(xùn)練實現(xiàn)圓檢測與圓心位置預(yù)測,主要是通過對YOLOv8姿態(tài)評估模型在自定義的數(shù)據(jù)集上訓(xùn)練,生成一個自定義的圓檢測與圓心定位預(yù)測模型

2023-12-21 10:50:05 562

562

Hello大家好,今天給大家分享一下如何基于深度學(xué)習(xí)模型訓(xùn)練實現(xiàn)工件切割點位置預(yù)測,主要是通過對YOLOv8姿態(tài)評估模型在自定義的數(shù)據(jù)集上訓(xùn)練,生成一個工件切割分離點預(yù)測模型

2023-12-22 11:07:46 318

318

谷歌模型訓(xùn)練軟件主要是指ELECTRA,這是一種新的預(yù)訓(xùn)練方法,源自谷歌AI。ELECTRA不僅擁有BERT的優(yōu)勢,而且在效率上更勝一籌。

2024-02-29 17:37:39 362

362 谷歌在模型訓(xùn)練方面提供了一些強大的軟件工具和平臺。以下是幾個常用的谷歌模型訓(xùn)練軟件及其特點。

2024-03-01 16:24:01 219

219

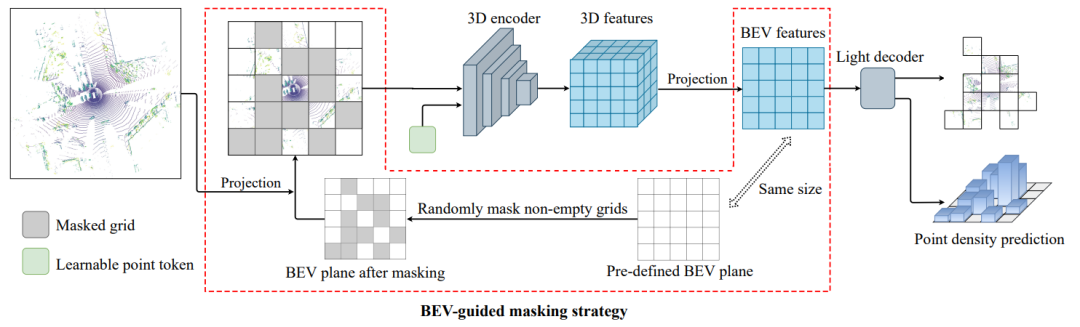

,首先預(yù)定義一個大小為

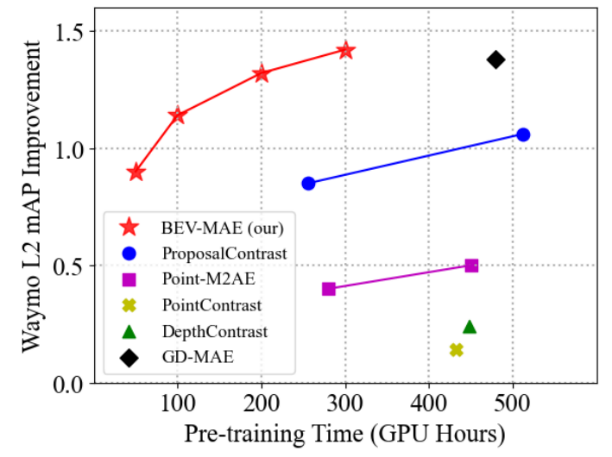

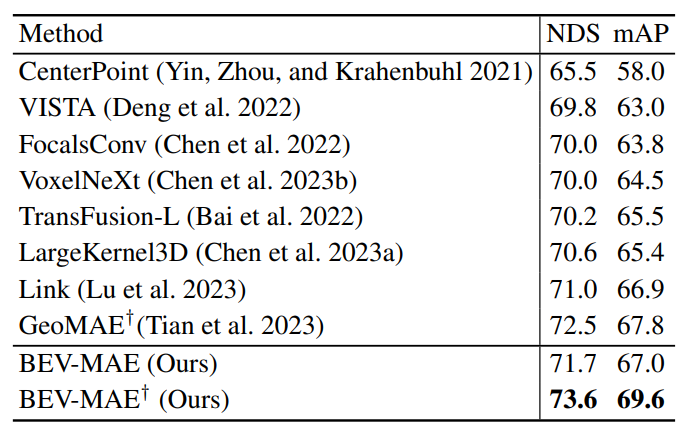

,首先預(yù)定義一個大小為 的網(wǎng)格狀鳥瞰圖平面。然后,根據(jù)點云的坐標(biāo)將每個點云投影到預(yù)定義平面的相應(yīng)鳥瞰圖網(wǎng)格中。之后,作者將隨機選擇一部分非空的鳥瞰圖網(wǎng)格作為被掩碼的網(wǎng)格,并將其余的鳥瞰圖網(wǎng)格視為可見網(wǎng)格。最后將所有投影到可見網(wǎng)格中的點云視為掩碼后的點云輸入到網(wǎng)絡(luò)中。

的網(wǎng)格狀鳥瞰圖平面。然后,根據(jù)點云的坐標(biāo)將每個點云投影到預(yù)定義平面的相應(yīng)鳥瞰圖網(wǎng)格中。之后,作者將隨機選擇一部分非空的鳥瞰圖網(wǎng)格作為被掩碼的網(wǎng)格,并將其余的鳥瞰圖網(wǎng)格視為可見網(wǎng)格。最后將所有投影到可見網(wǎng)格中的點云視為掩碼后的點云輸入到網(wǎng)絡(luò)中。

電子發(fā)燒友App

電子發(fā)燒友App

評論